基于微簇的 K - Dmeans 聚类算法改进

基于微簇的K-Dmeans聚类算法改进

张 昊*

摘 要:在现有的分布式聚类算法中普遍都存在着聚类效率较低且不能有效的保护数据隐私问题三本文针对K-Dmeans算法中原始数据聚类效果不佳的情况,对此算法进行改进三即提出了中心-边缘的系统框架结构,同时在数据集边缘节点进行数据聚类时提出了微簇概念,即边缘节点的数据按照规律进行二次细化聚类,再将聚类结果直接传输给中心节点,由中心节点对再次聚类的数据进行整合三简化了数据在各站点传输时的网络开销,同时保证了各站点数据的独立性,借此提高了数据隐私保护能力三

关键词:K-Dmeans算法二聚类二分布式聚类二微簇

一二概述

伴随信息化的不断发展,数据挖掘领域越来越被人们重视三所谓数据挖掘[1-2]就是从大量的二不完全的二有噪声的二模糊的二随机的数据中,提取潜在有用信息知识的过程三而如今数据挖掘技术面对海量的数据信息如何提高数据处理效率成为越来越多研究者面临的课题三利用聚类将大量数据分割可以大大简化数据挖掘的过程三聚类[3]是将大量待处理数据按照规律分为若干个簇,使每个簇内的数据具备高度相似性,而簇间数据则存在较大相异过程三较常用的聚类算法有层次聚类算法二分割聚类算法二基于密度算法二基于网格算法三

本文主要针对分割聚类算法中的K-Dmeans 算法进行改进三文献[6]中提出传统的K-Dmeans 算法,各站点间需要传递大量数据,既破坏了各站点的独立性,使网络开销增加,同时不同数据簇之间的界限在数据传输过程中变的模糊,导致数据聚类的效率降低三鉴于此,在K-Dmeans算法的基础上,本文提出了中心-边缘化数据节点的框架结构,引入微簇[3]的概念,即边缘节点的数据按照规律进行二次细化聚类,再将聚类结果传输给中心节点,由中心节点对再次聚类的数据进行整合三借此提高系统处理数据的能力三

二二相关概念

定义1 k-means算法[4-7]

K-means算法是将数据集分为k组,k组数据代表数据集分为k类三每个类随机抽取一个中心点,通过数据反复迭代,重新整合改变原有的分组情况,使得在原有的数据分组不断优化,最终中心点不再发生变化三聚类标准函数E收敛三

准则函数E定义为

E=∑k i=1∑p∈C i‖p-M i‖(1) 其中:p为类C i的空间点;M i为类C i数据对象的平均值三

定义2 k-Dmeans算法[8]

K-Dmeans算法其实就是分布式K-means算法,其指导思想是:任意选择数据集中一点作为主站点,利用k-means算法将其换分为k个簇,分割后各个簇中心点被主站点广播给其余k-1个子站点,通过数据的迭代将计算后的各样本点并入距离最近的中心点,并将不属于自身的样本对象传递给其他簇中心点,直到全局函数E收敛三

定义3 微簇(Cclass_id)

微簇就是对同一个集合中的多维数据进行一种整体表示方式三它的数据结构是:

(CF1x,n,class_id)

7

1 *张昊,男,铜陵学院数学与计算机学院讲师三

CF1x表示为该微簇的中心,所有数据在不同维度上的平均值均包含在其中;n为该微簇中的数据数量;class_id为该微簇的ID三

三、基于微簇的K-Dmeans聚类算法的改进

K-Dmeans算法较K-means算法有所改进,但是任然存在各站点之间传递数据占用大量网络资源,数据簇间界限不明,同时数据传递过程中还会泄露内部数据三鉴于此,在K-Dmeans的基础上引入微簇的概念,不仅可以大大提高数据聚类效率,也可减少隐私数据泄露的可能三

(一)系统框架结构

本文从另一个角度诠释K-Dmeans算法的系统框架,将主站点看做中心点,其他被划分好的k 个簇的中心点被看作边缘点,这样系统框架看做为中心 边缘结构三

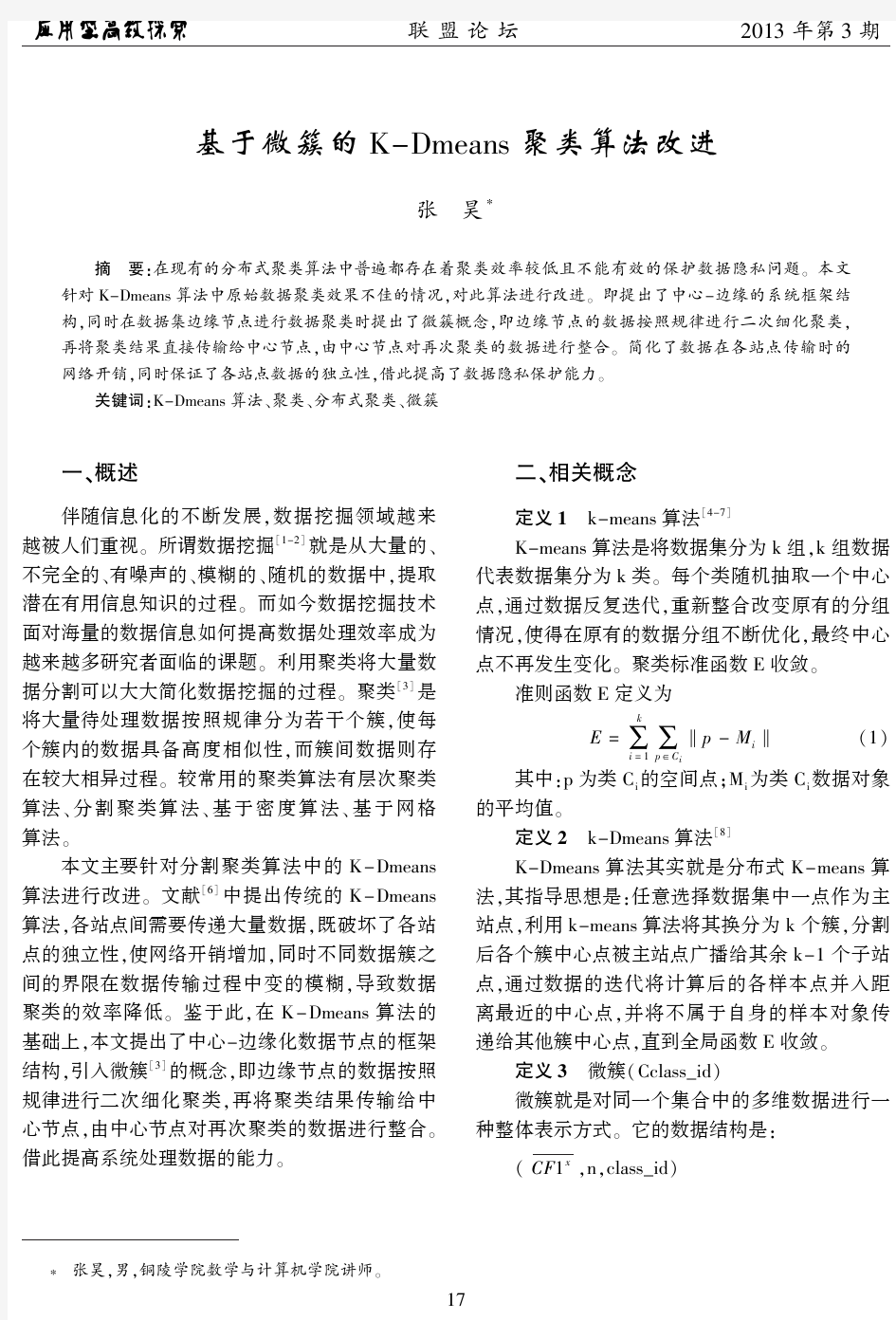

该系统框架中,每个边缘节点只处理该节点附近的局部数据并对处理好的数据结果进行分析,再将分析结果直接提交给中心点,在中心点进行二次处理和分析,最终得到数据聚类的结果,系统框架如图1所示三因为在该系统结构中边缘节点之间没有数据交互,每个边缘节点只与中心点进行交流,所以整个系统中就不存在元数据的传输三这样就降低了原数据在传输时的巨大消耗,同时也防止了原数据在传输过程中的泄露三大大提高数据聚类的效率三

User

Update Streams Update Streams Update Streams

图1 基于K-Dmeans聚类算法改进后的系统框架

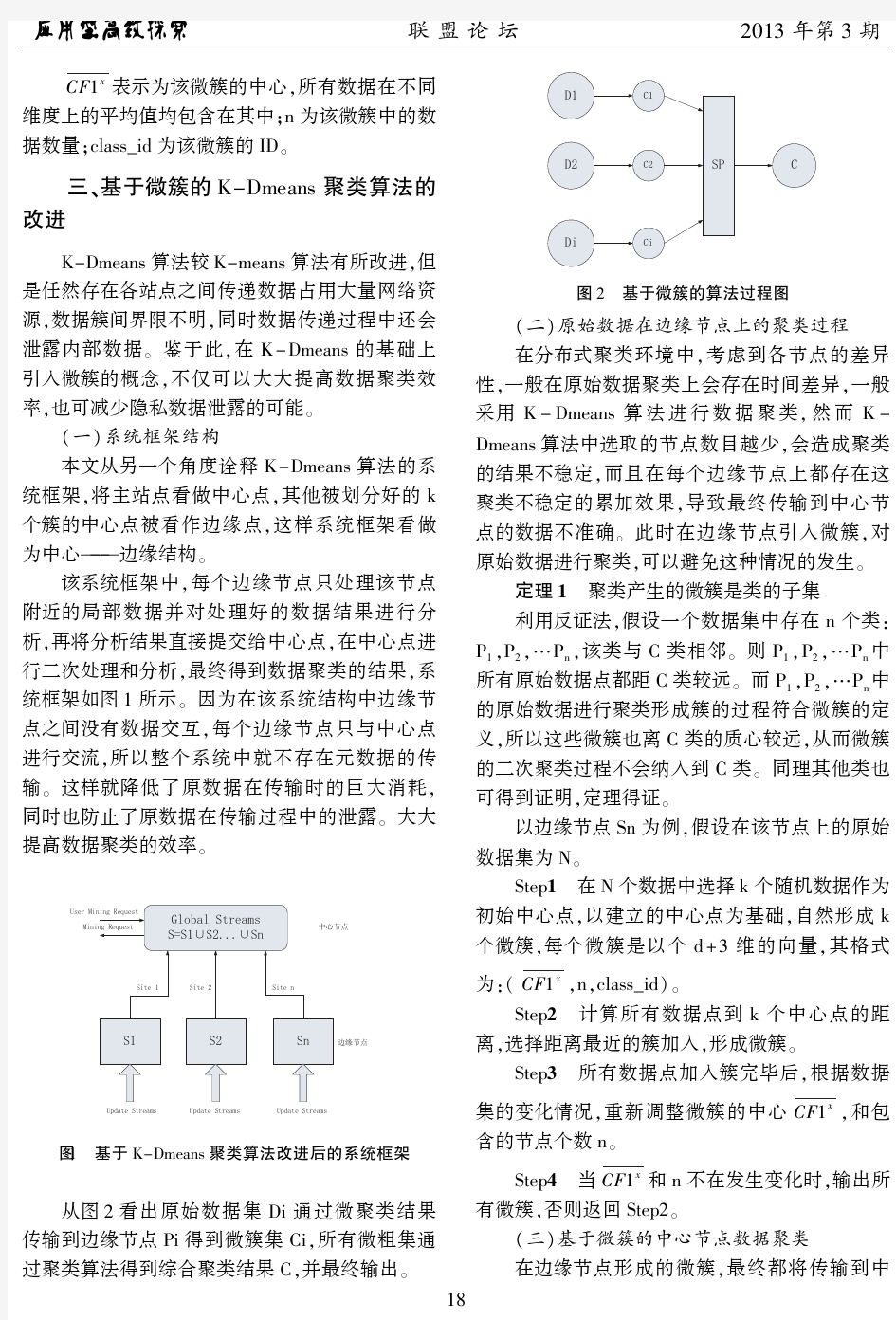

从图2看出原始数据集Di通过微聚类结果传输到边缘节点Pi得到微簇集Ci,所有微粗集通过聚类算法得到综合聚类结果C,并最终输出三

图2 基于微簇的算法过程图

(二)原始数据在边缘节点上的聚类过程

在分布式聚类环境中,考虑到各节点的差异性,一般在原始数据聚类上会存在时间差异,一般采用K-Dmeans算法进行数据聚类,然而K-

Dmeans算法中选取的节点数目越少,会造成聚类的结果不稳定,而且在每个边缘节点上都存在这聚类不稳定的累加效果,导致最终传输到中心节点的数据不准确三此时在边缘节点引入微簇,对原始数据进行聚类,可以避免这种情况的发生三定理1 聚类产生的微簇是类的子集

利用反证法,假设一个数据集中存在n个类: P1,P2, P n,该类与C类相邻三则P1,P2, P n中所有原始数据点都距C类较远三而P1,P2, P n中的原始数据进行聚类形成簇的过程符合微簇的定义,所以这些微簇也离C类的质心较远,从而微簇的二次聚类过程不会纳入到C类三同理其他类也可得到证明,定理得证三

以边缘节点Sn为例,假设在该节点上的原始数据集为N三

Step1 在N个数据中选择k个随机数据作为初始中心点,以建立的中心点为基础,自然形成k 个微簇,每个微簇是以个d+3维的向量,其格式为:(CF1x,n,class_id)三

Step2 计算所有数据点到k个中心点的距离,选择距离最近的簇加入,形成微簇三Step3 所有数据点加入簇完毕后,根据数据集的变化情况,重新调整微簇的中心

CF1x,和包含的节点个数n三

Step4 当CF1x和n不在发生变化时,输出所有微簇,否则返回Step2三

(三)基于微簇的中心节点数据聚类

在边缘节点形成的微簇,最终都将传输到中81

心节点进行融合,由于微簇之间具有不同的权值,即微簇包含的节点数目越多权重越大,其成为类中心的可能性也越大,且微簇可能存在重合性,所以每个微簇并不平等,故不能按照一般的聚类算法进行运算三因此考虑在中心点进行的数据聚类采用基于权值K-means 聚类算法,将微簇的质心作为中心节点的数据对象,并根据每个微簇的n 值分配不同的权重三算法步骤如下:

输入:来自m 个节点的微簇集{C 1,C 2, ,

C m },其中每个微簇集C j 包含该节点进行聚类后的k ’个微簇{c j 1,c j 2, ,c j m }三

输出:整个数据集的聚类结果三

Step 1 对m*k’个微簇进行处理,选择中心相等的微簇进行合并,调整n 的值;Step 2 选择k 个相互之间距离较大且权重大的簇作为初始聚类中心;

由于聚类的数据可能分布不均匀,若存在节

点C 1二C 2的质心A二B 不重合但非常接近的情况,则此时C 1二C 2权重相当,如果按照权重排序的方法选取初始质心,会导致以A二B 为质心进行聚类,聚类结果不准确三因此,本文采用了在进行权重排序的前提下设置门槛值的方法确保选择合适的质心三

首先,对m*k’个微簇进行权重排序;其次,计算任意两个微簇间距离的平均值

δ=d -

=

∑d ij /C 2mk

再次,按照权重大小进行排序,将排名第一的微簇作为第一个初始质心,再将计算好的新微簇与设定的门槛值进行比较,只有当选定的微簇距离大于门槛值,才可确定该微簇为初始质心:

d ij >δ

最终,选择k 个相互之间距离较大且权重大的簇作为初始聚类中心;

Step 3 按照距离将微簇分配到最近的类中,更新类中心及类中的原始数据数目;

由于微簇本身就是一个小规模的数据集合,与类中原先包含的数据源不相同,所以将微簇作为 原始数据”进行聚类,应该计算其几何平均值,而不能单纯计算数据点的平均值来确定类的中心三记录微簇中心点乘以微簇中所包含的数据量CF 1x *n,得到结果求平均,作为类更新后的中心三

有公式:

CF 1=

∑j

n j

∑n i

CF 1j

(2)

Step 4 最终类中心不再发生变化,执行Step5,否则返回Step3;

Step 5 输出聚类结果三

三、实验结果与性能分析

实验数据针对本文提出的基于微簇的K -

Dmeans 算法与K-Dmeans 算法进行比较,编程环境为Micsoft Visual C ++,操作系统为Windows XP,

实验用的4台计算机配置为3.5GHz Pentium ⅣCPU 以及2G 内存和一台24口的百兆以太网交换机三实验采用Iris[]数据集进行测试,如表1所

示:

表1 Iris 测试数据集

数据集纬度数据样本个数

Iris

41608

220

12100019

2000

实验过程将4台计算机组成局域网,利用Iris 数据集分别对K-Dmeans 算法和基于微簇的K -Dmeas 算法进行测试,总共进行10次实验三对所选取的4组数据集分别进行测试,实验第一部分测试两种算法的效率比较,实验中K -Dmeans 分布式聚类直接在局域网内进行数据的聚合;涉及到利用微簇进行聚类时每次随机选取6个边缘节点,每个边缘节点数据量为1000,总共聚合为30个微簇,微簇结果传递给中心节点聚合为6个类三最终将10次实验结果取平均值导出,将测试结果的数据聚类效率与精度进行对比三

500100015002000

Iris1

Iris2

Iris3

Iris4

/m s

图3 改进后算法与K-Dmeans 算法效率比较

9

1

从图3可以明显看出在数据集规模较小时,改进后的K-Dmeans 算法与K-Dmeans 算法用时相差不大,但随着数据集的规模不断变大,两种算法的时间差异性就比较明显了三这是因为改进后的算法采用中心-边缘架构且数据集在边缘节点进行微簇聚类,然后将聚类结果直接传递给中心节点进行处理,减少了类与类之间的数据传递,所以在处理数据时节省时间三

实验第二部分主要证明改进后的算法的精度问题,实验采用Micro -precision[],标准,其定义为:

Micro -precision =1

n ∑k

i =1

αi

(3)

公式中n 代表采集数据样本的总数,k 表示聚类的个数,αi 表示数据聚类后被正确归类的样本个数三从该公式中反映出当Micro -precision 值越大,最终聚类的精度越高三对数据样本集Iris 进行10次实验,其聚类精度对比如图

:

50

100

Iris1Iris2Iris3Iris4

/%

图4 改进后算法与K-Dmeans 算法精度比较

从图4可以看出,改进后的算法由于在在边缘节点进行了微簇聚类,等于对数据集的二次细化,所以在聚类效果上精度略高于K -Dmeans 算法三

四二结束语

本文针对K-Dmeans 算法在聚类中的数据传递消耗大二效率低的缺点进行改进,提出了中心-边缘框架结构,引入了微簇概念,在边缘节点进行微簇聚类,并将聚类结果直接传递给中心节点进行处理,有效的减少了原算法在数据传递中的网

络开销,且提高了数据聚类效果,降低了局部站点的数据迭代次数,实验结果证明,该算法的改进是一种有效可行的分布式聚类算法三但算法中对微簇参数的进一步分析,更有效的找出异类数据对象,还需要更加深入的研究三

参考文献:

[1]Han Jiawei ,KAMBER M.Data Mining Concepts and

Technique ,Second Edition [M ].Beijing :China Machine Press ,2007:312-402.

[2]Lee G ,Chang CY ,Chen ALP.Hiding sensitive Patterns

in association rules mining.In :Wong E ,Kanoun K ,eds.Proc.of the 28th Int'l Computer Software and Ap?plications Conf.(COMPSAC 2004).Piseataway :IEEE

Computer Society ,2004:424-29.

[3]Charu C Aggarw ,Jiawei Han ,Jianyong Wang.A Framwork

for On?Dem and Classification of Evolving Data Strings [J ].IEEE Transaction on Knowledges and Data Engi?neering 2006,18(5):322-326.

[4]Wang ET ,Lee G ,Lin YT.A novel method for protecting

sensitive knowledge in association rules mining.In :

Chen IR ,Ibbett R ,Mei H ,eds.Proc.of the 29th An?nual Int 'l Computer Software and Applications Conf.(COMPSAC 2005).Edinburgh :IEEE Computer Socie?ty ,2005:511-516.

[5]Oliveira SRM ,Zafanc OR ,Saygin Y.Secure association

rule sharing.In :Dai H ,Srikant R ,Zhang C ,eds.Proc.of the 8th Pacific-Asia Conf.on knowledge Dis?covery and Data Mining (PAKD 2004).Berlin :Spring?er-Verlag ,2004.74-85.

[6]刘力雄,郭云飞,康晶.分布式数据流聚类算法[J ].计

算机工程与设计,2011,32(8):2708-2711.

[7]陈文.基于FP 树的加权频繁模式挖掘算法[J ].计算

机工程,2011,38(6):63-65.

[8]Oliveira SRM ,Zaitane OR.Algorithms for balancing Pri?

vacy and knowledge discovery in association rule min?ing.In :Desai BC ,Ng W ,eds.Proc.of the 7th Int’l

Database Engineering and Applications symp.Hong

Kong :IEEE Computer society ,2003:54-63.

2

(完整word版)各种聚类算法介绍及对比

一、层次聚类 1、层次聚类的原理及分类 1)层次法(Hierarchical methods)先计算样本之间的距离。每次将距离最近的点合并到同一个类。然后,再计算类与类之间的距离,将距离最近的类合并为一个大类。不停的合并,直到合成了一个类。其中类与类的距离的计算方法有:最短距离法,最长距离法,中间距离法,类平均法等。比如最短距离法,将类与类的距离定义为类与类之间样本的最短距离。 层次聚类算法根据层次分解的顺序分为:自下底向上和自上向下,即凝聚的层次聚类算法和分裂的层次聚类算法(agglomerative和divisive),也可以理解为自下而上法(bottom-up)和自上而下法(top-down)。自下而上法就是一开始每个个体(object)都是一个 类,然后根据linkage寻找同类,最后形成一个“类”。自上而下法就是反过来,一开始所有个体都属于一个“类”,然后根据linkage排除异己,最后每个个体都成为一个“类”。这两种路方法没有孰优孰劣之分,只是在实际应用的时候要根据数据特点以及你想要的“类”的个数,来考虑是自上而下更快还是自下而上更快。至于根据Linkage判断“类” 的方法就是最短距离法、最长距离法、中间距离法、类平均法等等(其中类平均法往往被认为是最常用也最好用的方法,一方面因为其良好的单调性,另一方面因为其空间扩张/浓缩的程度适中)。为弥补分解与合并的不足,层次合并经常要与其它聚类方法相结合,如循环定位。 2)Hierarchical methods中比较新的算法有BIRCH(Balanced Iterative Reducing and Clustering Using Hierarchies利用层次方法的平衡迭代规约和聚类)主要是在数据量很大的时候使用,而且数据类型是numerical。首先利用树的结构对对象集进行划分,然后再利用其它聚类方法对这些聚类进行优化;ROCK(A Hierarchical Clustering Algorithm for Categorical Attributes)主要用在categorical的数据类型上;Chameleon(A Hierarchical Clustering Algorithm Using Dynamic Modeling)里用到的linkage是kNN(k-nearest-neighbor)算法,并以此构建一个graph,Chameleon的聚类效果被认为非常强大,比BIRCH好用,但运算复杂度很高,O(n^2)。 2、层次聚类的流程 凝聚型层次聚类的策略是先将每个对象作为一个簇,然后合并这些原子簇为越来越大的簇,直到所有对象都在一个簇中,或者某个终结条件被满足。绝大多数层次聚类属于凝聚型层次聚类,它们只是在簇间相似度的定义上有所不同。这里给出采用最小距离的凝聚层次聚类算法流程: (1) 将每个对象看作一类,计算两两之间的最小距离; (2) 将距离最小的两个类合并成一个新类; (3) 重新计算新类与所有类之间的距离; (4) 重复(2)、(3),直到所有类最后合并成一类。

各种聚类算法及改进算法的研究

论文关键词:数据挖掘;聚类算法;聚类分析论文摘要:该文详细阐述了数据挖掘领域的常用聚类算法及改进算法,并比较分析了其优缺点,提出了数据挖掘对聚类的典型要求,指出各自的特点,以便于人们更快、更容易地选择一种聚类算法解决特定问题和对聚类算法作进一步的研究。并给出了相应的算法评价标准、改进建议和聚类分析研究的热点、难点。上述工作将为聚类分析和数据挖掘等研究提供有益的参考。 1 引言随着经济社会和科学技术的高速发展,各行各业积累的数据量急剧增长,如何从海量的数据中提取有用的信息成为当务之急。聚类是将数据划分成群组的过程,即把数据对象分成多个类或簇,在同一个簇中的对象之间具有较高的相似度,而不同簇中的对象差别较大。它对未知数据的划分和分析起着非常有效的作用。通过聚类,能够识别密集和稀疏的区域,发现全局的分布模式,以及数据属性之间的相互关系等。为了找到效率高、通用性强的聚类方法人们从不同角度提出了许多种聚类算法,一般可分为基于层次的,基于划分的,基于密度的,基于网格的和基于模型的五大类。 2 数据挖掘对聚类算法的要求(1)可兼容性:要求聚类算法能够适应并处理属性不同类型的数据。(2)可伸缩性:要求聚类算法对大型数据集和小数据集都适用。(3)对用户专业知识要求最小化。(4)对数据类别簇的包容性:即聚类算法不仅能在用基本几何形式表达的数据上运行得很好,还要在以其他更高维度形式表现的数据上同样也能实现。(5)能有效识别并处理数据库的大量数据中普遍包含的异常值,空缺值或错误的不符合现实的数据。(6)聚类结果既要满足特定约束条件,又要具有良好聚类特性,且不丢失数据的真实信息。(7)可读性和可视性:能利用各种属性如颜色等以直观形式向用户显示数据挖掘的结果。(8)处理噪声数据的能力。(9)算法能否与输入顺序无关。 3 各种聚类算法介绍随着人们对数据挖掘的深入研究和了解,各种聚类算法的改进算法也相继提出,很多新算法在前人提出的算法中做了某些方面的提高和改进,且很多算法是有针对性地为特定的领域而设计。某些算法可能对某类数据在可行性、效率、精度或简单性上具有一定的优越性,但对其它类型的数据或在其他领域应用中则不一定还有优势。所以,我们必须清楚地了解各种算法的优缺点和应用范围,根据实际问题选择合适的算法。 3.1 基于层次的聚类算法基于层次的聚类算法对给定数据对象进行层次上的分解,可分为凝聚算法和分裂算法。 (1)自底向上的凝聚聚类方法。这种策略是以数据对象作为原子类,然后将这些原子类进行聚合。逐步聚合成越来越大的类,直到满足终止条件。凝聚算法的过程为:在初始时,每一个成员都组成一个单独的簇,在以后的迭代过程中,再把那些相互邻近的簇合并成一个簇,直到所有的成员组成一个簇为止。其时间和空间复杂性均为O(n2)。通过凝聚式的方法将两簇合并后,无法再将其分离到之前的状态。在凝聚聚类时,选择合适的类的个数和画出原始数据的图像很重要。 [!--empirenews.page--] (2)自顶向下分裂聚类方法。与凝聚法相反,该法先将所有对象置于一个簇中,然后逐渐细分为越来越小的簇,直到每个对象自成一簇,或者达到了某个终结条件。其主要思想是将那些成员之间不是非常紧密的簇进行分裂。跟凝聚式方法的方向相反,从一个簇出发,一步一步细化。它的优点在于研究者可以把注意力集中在数据的结构上面。一般情况下不使用分裂型方法,因为在较高的层很难进行正确的拆分。 3.2 基于密度的聚类算法很多算法都使用距离来描述数据之间的相似性,但对于非凸数据集,只用距离来描述是不够的。此时可用密度来取代距离描述相似性,即基于密度的聚类算法。它不是基于各种各样的距离,所以能克服基于距离的算法只能发现“类圆形”的聚类的缺点。其指导思想是:只要一个区域中的点的密度(对象或数据点的数目)大过某个阈值,就把它加到与之相近的聚类中去。该法从数据对象的分布密度出发,把密度足够大的区域连接起来,从而可发现任意形状的簇,并可用来过滤“噪声”数据。常见算法有DBSCAN,DENCLUE 等。[1][2][3]下一页 3.3 基于划分的聚类算法给定一个N个对象的元组或数据库,根据给定要创建的划分的数目k,将数据划分为k个组,每个组表示一个簇类(<=N)时满足如下两点:(1)每个组至少包含一个对象;(2)每个对

改进的K-means聚类算法及应用

改进的K-means聚类算法及应用 摘要:传统的k-means算法需要事先确定初始聚类中心,聚类精确程度不高。针对以上问题,本文结合熵值法和动态规划算法来对传统的k-means算法进行改进,提出了基于熵值法及动态规划的改进k-means算法。熵值法用来修订算法的距离计算公式,以提高算法的聚类精确程度, 动态规划算法用来确定算法的初始聚类中心。将改进算法应用于矿井监测传感器聚类中,结果显示较传统的k-means算法,改进算法效率有了明显提高,聚类精确程度有较大增强。 关键词:k-means;动态规划;熵值法;聚类精确度;矿井监测传感器 【abstract】the traditional k-means has sensitivity to the initial clustering centers, and its clustering accuracy is low. to against these short comings, an improved k-means algorithm based on the combination of dynamic programming algorithm and entropy method is proposed. the entropy method is used to amend the distance calculating formula to improve the clustering accuracy, and dynamic programming algorithm is used to define the initial cluster centers. the result of the simulation on the clustering in the mine monitoring sensors shows that the proposed algorithm has better

k-means聚类算法的研究全解

k-means聚类算法的研究 1.k-means算法简介 1.1 k-means算法描述 给定n个对象的数据集D和要生成的簇数目k,划分算法将对象组织划分为k个簇(k<=n),这些簇的形成旨在优化一个目标准则。例如,基于距离的差异性函数,使得根据数据集的属性,在同一个簇中的对象是“相似的”,而不同簇中的对象是“相异的”。划分聚类算法需要预先指定簇数目或簇中心,通过反复迭代运算,逐步降低目标函数的误差值,当目标函数收敛时,得到最终聚类结果。这类方法分为基于质心的(Centroid-based)划分方法和基于中心的(Medoid-based)划分方法,而基于质心的划分方法是研究最多的算法,其中k-means算法是最具代表和知名的。 k-means算法是1967年由MacQueen首次提出的一种经典算法,经常用于数据挖掘和模式识别中,是一种无监督式的学习算法,其使用目的是对几何进行等价类的划分,即对一组具有相同数据结构的记录按某种分类准则进行分类,以获取若干个同类记录集。k-means聚类是近年来数据挖掘学科的一个研究热点和重点,这主要是因为它广泛应用于地球科学、信息技术、决策科学、医学、行为学和商业智能等领域。迄今为止,很多聚类任务都选择该算法。k-means算法是应用最为广泛的聚类算法。该算法以类中各样本的加权均值(成为质心)代表该类,只用于数字属性数据的聚类,算法有很清晰的几何和统计意义,但抗干扰性较差。通常以各种样本与其质心欧几里德距离总和作为目标函数,也可将目标函数修改为各类中任意两点间欧几里德距离总和,这样既考虑了类的分散度也考虑了类的紧致度。k-means算法是聚类分析中基于原型的划分聚类的应用算法。如果将目标函数看成分布归一化混合模型的似然率对数,k-means算法就可以看成概率模型算法的推广。 k-means算法基本思想: (1)随机的选K个点作为聚类中心; (2)划分剩余的点; (3)迭代过程需要一个收敛准则,此次采用平均误差准则。 (4)求质心(作为中心); (5)不断求质心,直到不再发生变化时,就得到最终的聚类结果。 k-means聚类算法是一种广泛应用的聚类算法,计算速度快,资源消耗少,但是k-means算法与初始选择有关系,初始聚类中心选择的随机性决定了算法的有效性和聚

K-means文本聚类算法

最大距离法选取初始簇中心的K-means文本聚类算法的研究 的评论 背景 随着计算机技术和网络技术的飞速发展,人们的生活方式产生了极大的改变。计算机从一个有几个房子大小的巨无霸,已经变成了小巧的笔记本。网络设备也已经从PC端走向移动端。越来越丰富的网络设备,让人们能在网络里畅游,网络对于人们来说触手可及,同时也产生了巨大的数据流量。人们如何从海量的数据中找到有用的信息,成为了现在计算机学科的研究热点。聚类是数据挖掘中重要的一支。由于聚类具有无需先验知识的优势,可以根据数据自然分部而获取知识。聚类成为数据挖掘领域一个非常活跃的领域,而且得到了广泛的应用。聚类就是把一个数据集合分成几个簇,在同一个簇里,数据相关性最高,但是在2个不同的簇里,数据相关性最低。K-means聚类算法主要针对处理大数据集时,处理快速简单,并且算法具有高效性和可伸缩性。但是,K-means聚类算法随机的选择初始簇中心会导致以下缺点:(1)得到的聚类结果中容易出现局部最优,而不是全局最优;(2)聚类结果不具有稳定性,很大程度上依赖于初始簇中心;(3)聚类过程中的迭代次数增加使聚类过程中的总耗时增加。 传统的k-means聚类算法 传统的聚类算法思想:首先从N个数据对象集合中随机选择k个对象,然后计算剩余的N-k个对象与k个对象的距离(相似度),与k个对象中哪个对象的距离最小,就把分给那个对象;然后在计算每个簇中的簇中心,即是每个簇中对象的均值;不断重复这一过程步骤,直到标准测度函数E开始收敛为止。 K-means算法描述如下: 输入:迭代终止条件ε,最大的迭代次数为max,簇的总数目是k,样本集有N个数据对象。 输出:满足迭代终止条件的k个簇和迭代次数s。 随机初始化k个簇中心: 对每个数据对象,分别计算该对象与k个簇中心均值的距离,并选择距离最小的簇将该对象加个到该簇里; 重新计算k个簇的中心,利用函数E计算出此时的函数值; 如果带到最大迭代次数或满足:

(完整版)聚类算法总结

1.聚类定义 “聚类是把相似的对象通过静态分类的方法分成不同的组别或者更多的子集(subset),这样让在同一个子集中的成员对象都有一些相似的属性”——wikipedia “聚类分析指将物理或抽象对象的集合分组成为由类似的对象组成的多个类的分析过程。它是一种重要的人类行为。聚类是将数据分类到不同的类或者簇这样的一个过程,所以同一个簇中的对象有很大的相似性,而不同簇间的对象有很大的相异性。”——百度百科 说白了,聚类(clustering)是完全可以按字面意思来理解的——将相同、相似、相近、相关的对象实例聚成一类的过程。简单理解,如果一个数据集合包含N个实例,根据某种准则可以将这N 个实例划分为m个类别,每个类别中的实例都是相关的,而不同类别之间是区别的也就是不相关的,这个过程就叫聚类了。 2.聚类过程: 1) 数据准备:包括特征标准化和降维. 2) 特征选择:从最初的特征中选择最有效的特征,并将其存储于向量中. 3) 特征提取:通过对所选择的特征进行转换形成新的突出特征.

4) 聚类(或分组):首先选择合适特征类型的某种距离函数(或构造新的距离函数)进行接近程度的度量;而后执行聚类或分组. 5) 聚类结果评估:是指对聚类结果进行评估.评估主要有3 种:外部有效性评估、内部有效性评估和相关性测试评估. 3聚类算法的类别 没有任何一种聚类技术(聚类算法)可以普遍适用于揭示各种多维数据集所呈现出来的多种多样的结构,根据数据在聚类中的积聚规则以及应用这些规则的方法,有多种聚类算法.聚类算法有多种分类方法将聚类算法大致分成层次化聚类算法、划分式聚类算法、基于密度和网格的聚类算法和其他聚类算法,如图1 所示 的4 个类别.

聚类分析K-means算法综述

聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇;

(6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。

[改进的聚类算法在农业经济类型划分中的应用] kmeans聚类算法改进

[改进的聚类算法在农业经济类型划分中的应用] kmeans聚类算法改进 一、引言 吉林省各地自然、经济、社会条件各有差异,对农业经济的 影响很大。为了稳定提高粮食综合生产能力,促进农业经济结构 进一步优化。就需要准确地对省内各市县农业经济类型进行划 分,以期做到合理的资源优化配置。本文采用一种改进的k-均值 聚类分析技术对所采集的吉林省各县市农业生产的相关数据进行 分析,目的是对吉林省各地农业经济类型进行划分,揭示各地区 农业生产的特点和优势,为加快全省农业经济发展提供依据。 二、改进的聚类算法基本原理 改进的聚类算法的基本思想是:首先对数据集合进行系统聚 类分析,得到聚类树及相应的聚类中心矩阵;接着从聚类树中查 找较早形成的大类,并计算其聚类中心,这样我们就得到了较好 的聚类数k及比较具有代表性的初试聚类中心集合;最后通过k- 均值算法进行聚类分析。 虽然此改进算法需要我们人为的设定条件,但是这些条件都 是在进行系统聚类分析之后的数据基础上得来的,比经典的k-均 值算法的直接判断聚类数和随机抽取初始聚类中心要具有明显的 优势。根据本文待挖掘的数据量和系统聚类的结果,初始条件设

定如下:被判定为较早形成的大类聚类,其包含的数据对象应大于4,与下一次合并的聚类间距越小越好,且应小于所有聚类过程中的聚类间距均值。 三、改进的聚类算法在吉林农业经济类型划分中的应用 分类指标的选择 农业经济系统是一个多因素、多层次、结构复杂的系统,要正确地划分农业经济类型,首先必须选择一套能全面反映当前农业经济状况的指标体系。为此我们根据吉林农业的实际情况,选择对农业经济发展起主导作用的因子作为聚类指标,通过实地调查和对统计资料的综合分析,选定以下10个指标:X1 ,年平均降水量;X2 ,年平均温度;X3 ,农业人口;X4 ,每公顷粮食产量;X5 ,农业机械总动力;X6 ,粮食面积占耕地面积比例; X7 ,林业产值占农业总产值比例;X8 ,牧业产值占农业总产值比例;X9,渔业产值占农业总产值比例;X10 ,人均收入。 数据准备 根据以上10项指标,我们通过查阅xx年《吉林省统计年鉴》可以得到吉林省各地区农业经济各项指标的原始数据,如表1所示。 数据来源:根据xx年《吉林省统计年鉴》整理。 数据挖掘结果 首先对以上数据进行标准化转换,之后采用系统聚类分析法得到聚类树,分析聚类树及聚类间距我们可以得到初始聚类数为

matlab实现Kmeans聚类算法

matlab实现Kmeans聚类算法 1.简介: Kmeans和应用于混合高斯模型的受限EM算法是一致的。高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。 Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。Kmeans和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。 k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。 上图中的彩色部分是一些二维空间点。上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。这就是聚类算法要做的事情。 这个算法的输入是: 1:点的数据(这里并不一定指的是坐标,其实可以说是向量)

2:K,聚类中心的个数(即要把这一堆数据分成几组) 所以,在处理之前,你先要决定将要把这一堆数据分成几组,即聚成几类。但并不是在所有情况下,你都事先就能知道需要把数据聚成几类的。意味着使用k-means就不能处理这种情况,下文中会有讲解。 把相应的输入数据,传入k-means算法后,当k-means算法运行完后,该算法的输出是: 1:标签(每一个点都有一个标签,因为最终任何一个点,总会被分到某个类,类的id号就是标签) 2:每个类的中心点。 标签,是表示某个点是被分到哪个类了。例如,在上图中,实际上有4中“标签”,每个“标签”使用不同的颜色来表示。所有黄色点我们可以用标签以看出,有3个类离的比较远,有两个类离得比较近,几乎要混合在一起了。 当然,数据集不一定是坐标,假如你要对彩色图像进行聚类,那么你的向量就可以是(b,g,r),如果使用的是hsv颜色空间,那还可以使用(h,s,v),当然肯定可以有不同的组合例如(b*b,g*r,r*b) ,(h*b,s*g,v*v)等等。 在本文中,初始的类的中心点是随机产生的。如上图的红色点所示,是本文随机产生的初始点。注意观察那两个离得比较近的类,它们几乎要混合在一起,看看算法是如何将它们分开的。 类的初始中心点是随机产生的。算法会不断迭代来矫正这些中心点,并最终得到比较靠5个中心点的距离,选出一个距离最小的(例如该点与第2个中心点的距离是5个距离中最小的),那么该点就归属于该类.上图是点的归类结果示意图. 经过步骤3后,每一个中心center(i)点都有它的”管辖范围”,由于这个中心点不一定是这个管辖范围的真正中心点,所以要重新计算中心点,计算的方法有很多种,最简单的一种是,直接计算该管辖范围内所有点的均值,做为心的中心点new_center(i). 如果重新计算的中心点new_center(i)与原来的中心点center(i)的距离大于一定的阈值(该阈值可以设定),那么认为算法尚未收敛,使用new_center(i)代替center(i)(如图,中心点从红色点

基于向量空间模型的文本聚类算法

基于向量空间模型的文本聚类算法 转自:https://www.wendangku.net/doc/5b7156672.html,/2009/0910/15270.php 1 文本聚类研究现状 Internet 已经发展为当今世界上最大的信息库和全球范围内传播信息最主要的渠道。随着Internet 的大规模普及和企业信息化程度的提高,各种资源呈爆炸式增长。在中国互联网络信息中心(CNNIC)2007 年1 月最新公布的中国互联网络发展状况统计报告中显示,70.2% 的网络信息均以文本形式体现。对于这种半结构或无结构化数据,如何从中获取特定内容的信息和知识成为摆在人们面前的一道难题。近年来,文本挖掘、信息过滤和信息检索等方面的研究出现了前所未有的高潮。 作为一种无监督的机器学习方法,聚类技术可以将大量文本信息组成少数有意义的簇,并提供导航或浏览机制。 文本聚类的主要应用点包括: (1) 文本聚类可以作为多文档自动文摘等自然语言处理应用的预处理步骤。其中比较典型的例子是哥伦比亚大学开发的多文档自动文摘系统Newsblaster[1] 。该系统将新闻进行 聚类处理,并对同主题文档进行冗余消除、信息融合、文本生成等处理,从而生成一篇简明扼要的摘要文档。 (2) 对搜索引擎返回的结果进行聚类,使用户迅速定位到所需要的信息。比较典型的系统有Infonetware Real Term Search 。Infonetware 具有强大的对搜索结果进行主题分类的功能。另外,由Carrot Search 开发的基于Java 的开源Carrot2 搜索结果聚合聚类引擎2.0 版也是这方面的利用,Carrot2 可以自动把自然的搜索结果归类( 聚合聚类) 到相应的语义类别中,提供基于层级的、同义的以及标签过滤的功能。 (3) 改善文本分类的结果,如俄亥俄州立大学的Y.C.Fang 等人的工作[2] 。 (4) 文档集合的自动整理。如Scatter/Gather[3] ,它是一个基于聚类的文档浏览系统。 2 文本聚类过程 文本聚类主要依据聚类假设:同类的文档相似度较大,非同类的文档相似度较小。作为一种无监督的机器学习方法,聚类由于不需要训练过程、以及不需要预先对文档手工标注类别,因此具有较高的灵活性和自动化处理能力,成为对文本信息进行有效组织、摘要和导航的重要手段。文本聚类的具体过程如图 1 所示。 图 1 文本聚类过程

各种聚类算法的比较

各种聚类算法的比较 聚类的目标是使同一类对象的相似度尽可能地小;不同类对象之间的相似度尽可能地大。目前聚类的方法很多,根据基本思想的不同,大致可以将聚类算法分为五大类:层次聚类算法、分割聚类算法、基于约束的聚类算法、机器学习中的聚类算法和用于高维度的聚类算法。摘自数据挖掘中的聚类分析研究综述这篇论文。 1、层次聚类算法 1.1聚合聚类 1.1.1相似度依据距离不同:Single-Link:最近距离、Complete-Link:最远距离、Average-Link:平均距离 1.1.2最具代表性算法 1)CURE算法 特点:固定数目有代表性的点共同代表类 优点:识别形状复杂,大小不一的聚类,过滤孤立点 2)ROCK算法 特点:对CURE算法的改进 优点:同上,并适用于类别属性的数据 3)CHAMELEON算法 特点:利用了动态建模技术 1.2分解聚类 1.3优缺点 优点:适用于任意形状和任意属性的数据集;灵活控制不同层次的聚类粒度,强聚类能力 缺点:大大延长了算法的执行时间,不能回溯处理 2、分割聚类算法 2.1基于密度的聚类 2.1.1特点 将密度足够大的相邻区域连接,能有效处理异常数据,主要用于对空间数据的聚类

1)DBSCAN:不断生长足够高密度的区域 2)DENCLUE:根据数据点在属性空间中的密度进行聚类,密度和网格与处理的结合 3)OPTICS、DBCLASD、CURD:均针对数据在空间中呈现的不同密度分不对DBSCAN作了改进 2.2基于网格的聚类 2.2.1特点 利用属性空间的多维网格数据结构,将空间划分为有限数目的单元以构成网格结构; 1)优点:处理时间与数据对象的数目无关,与数据的输入顺序无关,可以处理任意类型的数据 2)缺点:处理时间与每维空间所划分的单元数相关,一定程度上降低了聚类的质量和准确性 2.2.2典型算法 1)STING:基于网格多分辨率,将空间划分为方形单元,对应不同分辨率2)STING+:改进STING,用于处理动态进化的空间数据 3)CLIQUE:结合网格和密度聚类的思想,能处理大规模高维度数据4)WaveCluster:以信号处理思想为基础 2.3基于图论的聚类 2.3.1特点 转换为组合优化问题,并利用图论和相关启发式算法来解决,构造数据集的最小生成数,再逐步删除最长边 1)优点:不需要进行相似度的计算 2.3.2两个主要的应用形式 1)基于超图的划分 2)基于光谱的图划分 2.4基于平方误差的迭代重分配聚类 2.4.1思想 逐步对聚类结果进行优化、不断将目标数据集向各个聚类中心进行重新分配以获最优解

改进C均值聚类算法

改进C 均值聚类算法 C 均值算法属于聚类技术中一种基本的划分方法,具有简单、快速的优点。其基本思想是选取c 个数据对象作为初始聚类中心,通过迭代把数据对象划分到不同的簇中,使簇内部对象之间的相似度很大,而簇之间对象的相似度很小。对C 均值算法的初始聚类中心选择方法进行了改进,提出了一种从数据对象分布出发动态寻找并确定初始聚类中心的思路以及基于这种思路的改进算法。 1、C-均值聚类算法 ① 给出n 个混合样本,令1=I ,表示迭代运算次数,选取c 个初始聚合中心)1(j Z ,c j ,...,2,1=; ② 计算每个样本与聚合中心的距离))(,(I Z x D j k ,n k ,....,2,1=,c j ,...,2,1=。 若},...,2,1)),(,({min ))(,(,...,2,1n k I Z x D I Z x D j k c j i k ===,则i k w x ∈。 ③ 计算c 个新的集合中心:∑== +j n k j k j j x n I Z 1 )(1)1(,c j ,...,2,1=。 ④ 判断:若)()1(I Z I Z j j ≠+,c j ,...,2,1=,则1+=I I ,返回②,否则算法结束。 2、C-均值改进算法的思想 在C-均值算法中,选择不同的初始聚类中心会产生不同的聚类结果且有不同的准确率,此方法就是如何找到与数据在空间分布上尽可能相一致的初始聚类中心。对数据进行划分,最根本的目的是使得一个聚类中的对象是相似的,而不同聚类中的对象是不相似的。如果用距离表示对象之间的相似性程度,相似对象之间的距离比不相似对象之间的距离要小。如果能够寻找到C 个初始中心,它们分别代表了相似程度较大的数据集合,那么就找到了与数据在空间分布上相一致的初始聚类中心。 目前,初始聚类中心选取的方法有很多种,在此仅介绍两种: 1)基于最小距离的初始聚类中心选取法 其主要思想: (1) 计算数据对象两两之间的距离; (2) 找出距离最近的两个数据对象,形成一个数据对象集合A1 ,并将它们从总的数据集合U 中删除; (3) 计算A1 中每一个数据对象与数据对象集合U 中每一个样本的距离,找出在U 中与A1 中最近的数据对象,将它并入集合A1 并从U 中删除, 直到A1 中的数据对象个数到达一定阈值; (4) 再从U 中找到样本两两间距离最近的两个数据对象构成A2 ,重复上面的过程,直到形成k 个对象集合; (5) 最后对k 个对象集合分别进行算术平均,形成k 个初始聚类中心。 这种方法和Huffman 算法一样。后一种算法介绍是是基于最小二叉树的方法,看

k-means文本聚类

目录 1 概念及应用背景 (1) 1.1概念 (1) 1.2应用背景................................................................................... 错误!未定义书签。 2 系统设计框架..................................................................................... 错误!未定义书签。 2.1总体框架................................................................................... 错误!未定义书签。 2.2文本聚类的具体过程 (1) 3应用程序具体实现及说明 (3) 3.1获取文档的输入....................................................................... 错误!未定义书签。 3.2提取文档的TF/IDF权重 (3) 3.3 k-means进行数据聚类 (4) 4 实验结果及分析................................................................................. 错误!未定义书签。 4.1实验结果................................................................................... 错误!未定义书签。 4.2结果分析................................................................................... 错误!未定义书签。5结论...................................................................................................... 错误!未定义书签。 5.1实验结论................................................................................... 错误!未定义书签。 5.2个人感受................................................................................... 错误!未定义书签。附录:项目框架和主程序代码............................................................. 错误!未定义书签。

聚类算法比较

聚类算法: 1. 划分法:K-MEANS算法、K-M EDOIDS算法、CLARANS算法; 1)K-means 算法: 基本思想是初始随机给定K个簇中心,按照最邻近原则把待分类样本点分到各个簇。然后按平均法重新计算各个簇的质心,从而确定新的簇心。一直迭代,直到簇心的移动距离小于某个给定的值。 K-Means聚类算法主要分为三个步骤: (1)第一步是为待聚类的点寻找聚类中心 (2)第二步是计算每个点到聚类中心的距离,将每个点聚类到离该点最近的聚类中去 (3)第三步是计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心 反复执行(2)、(3),直到聚类中心不再进行大范围移动或者聚类次数达到要求为止 下图展示了对n个样本点进行K-means聚类的效果,这里k取2: (a)未聚类的初始点集 (b)随机选取两个点作为聚类中心 (c)计算每个点到聚类中心的距离,并聚类到离该点最近的聚类中去 (d)计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心 (e)重复(c),计算每个点到聚类中心的距离,并聚类到离该点最近的聚类中去 (f)重复(d),计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心 优点: 1.算法快速、简单; 2.对大数据集有较高的效率并且是可伸缩性的; 3.时间复杂度近于线性,而且适合挖掘大规模数据集。 缺点: 1. 在 K-means 算法中 K 是事先给定的,这个 K 值的选定是非常难以估计的。 2. 在 K-means 算法中,首先需要根据初始聚类中心来确定一个初始划分,然后对初始划分进行优化。这个初始聚类中心的选择对聚类结果有较大的影响。

(完整版)X-means:一种针对聚类个数的K-means算法改进

X-means:一种针对聚类个数的K-means算法改进 摘要 尽管K-means很受欢迎,但是他有不可避免的三个缺点:1、它的计算规模是受限的。2、它的聚类个数K必须是由用户手动指定的。3、它的搜索是基于局部极小值的。在本文中,我们引入了前两种问题的解决办法,而针对最后一个问题,我们提出了一种局部补救的措施。根据先前有关算法改进的工作,我们引入了一种根据BIC(Bayesian Information Criterion)或者AIC(Akaike information criterion)得分机制而确定聚类个数的算法,本文的创新点包括:两种新的利用充分统计量的方式,还有一种有效地测试方法,这种方法在K-means算法中可以用来筛选最优的子集。通过这样的方式可以得到一种快速的、基于统计学的算法,这种算法可以实现输出聚类个数以及他们的参量值。实验表明,这种技术可以更科学的找出聚类个数K值,比利用不同的K值而重复使用K-means算法更快速。 1、介绍 K-means算法在处理量化数据中已经用了很长时间了,它的吸引力主要在于它很简单,并且算法是局部最小化收敛的。但是它有三点不可避免的缺点:首先,它在完成每次迭代的过程中要耗费大量的时间,并且它所能处理的数据量也是很少的。第二,聚类个数K值必须由用户自身来定义。第三,当限定了一个确定的K值时,K-means算法往往比一个动态K值的算法表现的更差。我们要提供针对这些问题的解决办法,通过嵌入树型的数据集以及将节点存储为充分统计变量的方式来大幅度提高算法的计算速度。确定中心的分析算法要考虑到泰森多边形边界的几何中心,并且在估计过程的任何地方都不能存在近似的方法。另外还有一种估计方法,“黑名单”,这个列表中将会包含那些需要在指定的区域内被考虑的图心。这种方法不仅在准确度上以及处理数据的规模上都表现的非常好,而这个快速算法在X-means 聚类算法当中充当了结构算法的作用,通过它可以很快的估计K值。这个算法在每次使用 K-means算法之后进行,来决定一个簇是否应该为了更好的适应这个数据集而被分开。决定的依据是BIC得分。在本文中,我们阐述了“黑名单”方法如何对现有的几何中心计算BIC 得分,并且这些几何中心所产生的子类花费不能比一个单纯的K-means聚类算法更高。更进一步的,我们还通过缓存状态信息以及估计是否需要重新计算的方法来改善估计方法。 我们已经用X-means算法进行了实验,验证了它的确比猜K值更加科学有效。X-means 算法可以在人造的或者是真实数据中表现的更好,通过BIC得分机制。它的运行速度也是比K-means更快的。 2、定义 我们首先描述简单的K-means算法应该考虑哪些因素。通过K-means可以把一定量的数据集分为K个数据子集,这K个数据子集分别围绕着K个聚类中心。这种算法保持着K个聚类中心不变,并且通过迭代不断调整这K个聚类中心。在第一次迭代开始之前,K个聚类中心都是随机选取的,算法当聚类中心不再变化的时候返回最佳的结果,在每一次迭代中,算法都要进行如下的动作: 1、对于每一个节点向量,找到距离它最近的聚类中心,归入此类。 2、重新评估每一个图心的位置,对于每一个图心,必须是簇的质心。 K-means聚类算法通过局部最小化每个向量到对应图心的距离来实现聚类。同时,它处理真实数据时是非常慢的。许多情况下,真实的数据不能直接用K-means进行聚类,而要经过二次抽样筛选之后再进行聚类。Ester曾经提出了一种可以从树形数据中获得平衡的抽样数据的方法。Ng和Han曾经提出了一种可以指导概率空间对输入向量的检索模拟模型。

K-means-聚类算法研究综述

K-means聚类算法研究综述 摘要:总结评述了K-means聚类算法的研究现状,指出K-means聚类算法是一个NP难优化问题,无法获得全局最优。介绍了K-means聚类算法的目标函数,算法流程,并列举了一个实例,指出了数据子集的数目K,初始聚类中心选取,相似性度量和距离矩阵为K-means聚类算法的3个基本参数。总结了K-means聚类算法存在的问题及其改进算法,指出了K-means 聚类的进一步研究方向。 关键词:K-means聚类算法;NP难优化问题;数据子集的数目K;初始聚类中心选取;相似性度量和距离矩阵 Review of K-means clustering algorithm Abstract: K-means clustering algorithm is reviewed. K-means clustering algorithm is a NP hard optimal problem and global optimal result cannot be reached. The goal,main steps and example of K-means clustering algorithm are introduced. K-means algorithm requires three user-specified parameters: number of clusters K,cluster initialization,and distance metric. Problems and improvement of K-means clustering algorithm are summarized then. Further study directions of K-means clustering algorithm are pointed at last. Key words: K-means clustering algorithm; NP hard optimal problem; number of clusters K; cluster initialization; distance metric K-means聚类算法是由Steinhaus1955年、Lloyed1957年、Ball & Hall1965年、McQueen1967年分别在各自的不同的科学研究领域独立的提出。K-means聚类算法被提出来后,在不同的学科领域被广泛研究和应用,并发展出大量不同的改进算法。虽然K-means聚类算法被提出已经超过50年了,但目前仍然是应用最广泛的划分聚类算法之一[1]。容易实施、简单、高效、成功的应用案例和经验是其仍然流行的主要原因。 文中总结评述了K-means聚类算法的研究现状,指出K-means聚类算法是一个NP难优化问题,无法获得全局最优。介绍了K-means聚类算法的目标函数、算法流程,并列举了一个实例,指出了数据子集的数目K、初始聚类中心选取、相似性度量和距离矩阵为K-means聚类算法的3个基本参数。总结了K-means聚类算法存在的问题及其改进算法,指出了K-means聚类的进一步研究方向。 1经典K-means聚类算法简介 1.1K-means聚类算法的目标函数 对于给定的一个包含n个d维数据点的数据集 12 {x,x,,x,,x} i n X=??????,其中d i x R ∈,以及要生成的数据子集的数目K,K-means聚类算法将数据对象组织为 K个划分{c,i1,2,} k C K ==???。每个划分代表一个类c k,每个类c k有一个类别中心iμ。选取欧氏距离作为相似性和 距离判断准则,计算该类内各点到聚类中心 i μ的距离平方和 2 (c) i i k i k x C J xμ ∈ =- ∑(1) 聚类目标是使各类总的距离平方和 1 (C)(c) K k k J J = =∑最小。 22 1111 (C)(c) i i K K K n k i k ki i k k k x C k i J J x d x μμ ==∈== ==-=- ∑∑∑∑∑ (2)其中, 1 i i ki i i x c d x c ∈ ? =? ? ? 若 若 ,显然,根据最小二乘 法和拉格朗日原理,聚类中心 k μ应该取为类别 k c类各数据点的平均值。 K-means聚类算法从一个初始的K类别划分开始,然