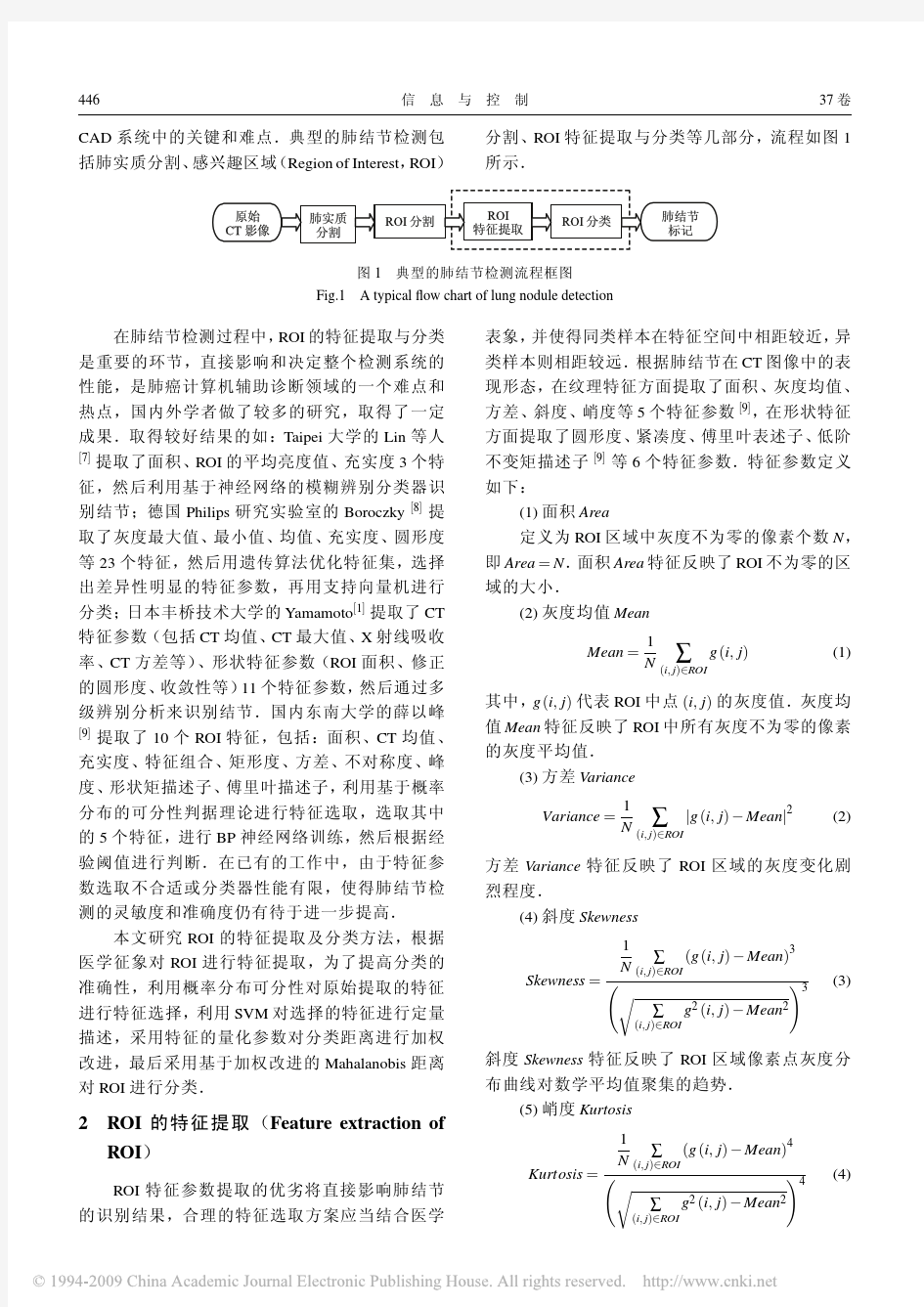

面向肺癌CAD 系统的感兴趣区域特征选择与分类算法

用c++对感兴趣区域的提取

一. 设计目的和意义 通过设计,较全面地掌握各种图像提取算法的基本理论、原理和实现手段,并能分析感兴趣区域(ROI)提取效果及对进一步处理的影响,使学生具有一定综合分析问题和解决问题的能力。 二.设计内容和要求 原始数据: 所获取二值图像。 技术要求: (1)完成题目所要求技术:全面掌握与区域提取算法相关的基本理论、原理和实现手段; (2)通过仿真(实验)验证,编程实现对处理实景图像进行感兴趣区域提取的算法和实现手段,并进行结果分析。 设计要求: 课程设计的目的在于培养学生的综合素质,要求学生做到: (1)根据题目要求查阅有关资料,确定方案,写出设计方案; (2)根据对选题的理解,消化查阅资料,给出相关的实现算法和理论根据; (3) 在Matlab或C++或VC环境下,实现算法,并给出仿真结果; (4) 对结果进行分析总结 三.设计工作任务 每个成员单独用一种方法,在Matlab或VC环境下运行程序,达到对图像感兴趣区域的提取的目的。 四.每种特征提取的代码和运行结果 1 通过腐蚀实现轮廓提取 (1)程序代码 // DibImage.cpp: implementation of the CDibImage class. // DIB(Independent Bitmap) 函数: // // PaintDIB() - 绘制DIB对象 // CreateDIBPalette() - 创建DIB对象调色板 // FindDIBBits() - 返回DIB图像象素起始位置 // DIBWidth() - 返回DIB宽度 // DIBHeight() - 返回DIB高度

// PaletteSize() - 返回DIB调色板大小 // DIBNumColors() - 计算DIB调色板颜色数目 // CopyHandle() - 拷贝内存块 // // SaveDIB() - 将DIB保存到指定文件中 // ReadDIBFile() - 重指定文件中读取DIB对象 ////////////////////////////////////////////////////////////////////// #include "stdafx.h" #include "TemplateTrans.h" #include "DibImage.h" #include "math.h" #ifdef _DEBUG #undef THIS_FILE static char THIS_FILE[]=__FILE__; #define new DEBUG_NEW #endif ////////////////////////////////////////////////////////////////////// // Construction/Destruction ////////////////////////////////////////////////////////////////////// CDibImage::CDibImage() {} CDibImage::~CDibImage() {} ////////////////////////////////////////////////////////////////////// // function ////////////////////////////////////////////////////////////////////// BOOL CDibImage::Enhance(LPSTR lpDIBBits,LONG lWidth,LONG lHeight) { //边缘检测 LPSTR lpSrc; LPSTR lpDst; LPSTR lpNewDIBBits; HLOCAL hNewDIBBits; long i,j; unsigned char n,e,s,w,ne,se,nw,sw;

视觉感兴趣区域的算法

定义视觉感兴趣区域的算法:眼球注视点的比较 Claudio M.Privitera and Lawrence W. Stark, Fellow, IEEE 摘要-很多机器视觉应用,如压缩,图案数据库查询,以及图像理解,经常需要用来详细分析图像中的一个代表子集, 它可能会被排列成一组被称作视觉感兴趣区域(ROIs)的位点。我们已经研究和开发了一种方法,其用于自动识别aROls这样的子集(根据算法检测的ROI),使用不同的图像处理算法,IPAs,和适当的聚类过程。在人类感知,一个内在的表现指示着自上而下,上下文相关的眼球运动序列,以注视hROls的相似的序列(人识别的ROI).在这篇论文中,我们引进我们自己的方法并且我们用aROLs比较hROLs 来作为一个评估和选择自下而上的算法的标准。最后,一个应用程序会被论述。 关键词:眼球运动,扫描途径理论,感兴趣的认同和比较区域 1 引言 眼球运动是人类视觉的重要组成部分因为它们必须使用视网膜中的小凹,最终,视觉注意到的图像的每个部分,会被固定,并与高分辨率处理。平均每秒三眼的注视一般发生在积极寻找之中;这些快速的眼跳会穿插在眼睛注视之中,被称为扫视,在此期间,视力被抑制。只有一小部分的眼睛注视(hROIs,人体检测的感兴趣区域)会被经常被大脑需要去做识别一个复杂的视觉输入(图1,上图)。我们一直在研究和界定一个这种基于数字图像智能处理的复杂的认知机制的计算模型。 图像处理算法,IPAs,通常被用来检测和定位在数字图像分析的特定特征,例如,空间频率,纹理构象,或对视觉刺激的位点的其它信息的值。应用一个IPA到图像意味着改变这种图像变为定义相应的算法特征像素值的新范围。变换的图像的局部最大值代表位点,其中该特定的特征是特别突出的,他们可以被用作基础或识别aROIs,被算法检测的感兴趣区域。许多局部最大值可以由图像变换来生成:因此,一个聚类过程是必需的,以减少在初始的大的局部最大值变成aROIs(图1,下图)的一个最后的小的子集。 aROIs和hROIs可以通过对其空间位置或结构性结合的分析,以及时间次序或顺序性结合的分析来互相比较。这些比较的结果衡量的IPA的能力,和它的集聚过程一起来预测hROIs。因此,我们的目标和我们的措施定量是明确的。首要的问题是,IPAs是否能像人类连续瞥眼那样对待一张图片。 在第2节中,以获得眼睛运动数据为目的的实验方案会被进行了详细讨论。第3节是专门定义一系列的IPAs的。在第4节中,聚类和排序问题会被讨论。用于比较hROIs和aROIs 计算和统计平台会在第5节被介绍。在第6节我们讨论自上而下的视野和人类扫描途径。在第7节,比较的结果会被讨论,而最后在第八节,我们会展示一个应用。 2 刺激的表现形式以及眼部移动的测试 计算机控制实验展示图片并且仔细测量使用摄像机来观察眼球运动[21]。红外源光被投射向被检体的眼睛,在角膜上产生一个明亮的浦肯野反射,这种反射是很容易被一个视频摄像机和眼睛跟踪服务器来跟踪的。受试者被指示观看有眼睛跟踪功能的计算机屏幕上的视觉刺激(对于之前和之后的数据采集的持续时间4秒,加长校正周期)。受试者坐在在屏幕的前面,他的头固定到一个固定下巴的结构。观看距离是从计算机屏幕到受试者约40厘米;刺激大小是平均为15厘米×20厘米,约21×29度的对向视角,并且眼点位置记录系统的

常见的特征选择或特征降维方法

URL:https://www.wendangku.net/doc/9a3571670.html,/14072.html 特征选择(排序)对于数据科学家、机器学习从业者来说非常重要。好的特征选择能够提升模型的性能,更能帮助我们理解数据的特点、底层结构,这对进一步改善模型、算法都有着重要作用。 特征选择主要有两个功能: 1.减少特征数量、降维,使模型泛化能力更强,减少过拟合 2.增强对特征和特征值之间的理解 拿到数据集,一个特征选择方法,往往很难同时完成这两个目的。通常情况下,选择一种自己最熟悉或者最方便的特征选择方法(往往目的是降维,而忽略了对特征和数据理解的目的)。 在许多机器学习的书里,很难找到关于特征选择的容,因为特征选择要解决的问题往往被视为机器学习的一种副作用,一般不会单独拿出来讨论。本文将介绍几种常用的特征选择方法,它们各自的优缺点和问题。 1 去掉取值变化小的特征Removing features with low variance 这应该是最简单的特征选择方法了:假设某种特征的特征值只有0和1,并且在所有输入样本中,95%的实例的该特征取值都是1,那就可以认为这个特征作用不大。如果100%都是1,那这个特征就没意义了。当特征值都是离散型变量的时候这种方法才能用,如果是连续型变量,就需要将连续变量离散化之后才能用,而且实际当中,一般不太会有95%以上都取某个值的特征存在,所以这种方法虽然简单但是不太好用。可以把它作为特征选择的预处理,先去掉那些取值变化小的特征,然后再从接下来提到的特征选择方法中选择合适的进行进一步的特征选择。

2 单变量特征选择Univariate feature selection 单变量特征选择能够对每一个特征进行测试,衡量该特征和响应变量之间的关系,根据得分扔掉不好的特征。对于回归和分类问题可以采用卡方检验等方式对特征进行测试。 这种方法比较简单,易于运行,易于理解,通常对于理解数据有较好的效果(但对特征优化、提高泛化能力来说不一定有效);这种方法有许多改进的版本、变种。 2.1 Pearson相关系数Pearson Correlation 皮尔森相关系数是一种最简单的,能帮助理解特征和响应变量之间关系的方法,该方法衡量的是变量之间的线性相关性,结果的取值区间为[-1,1],-1表示完全的负相关(这个变量下降,那个就会上升),+1表示完全的正相关,0表示没有线性相关。 Pearson Correlation速度快、易于计算,经常在拿到数据(经过清洗和特征提取之后的)之后第一时间就执行。 Pearson相关系数的一个明显缺陷是,作为特征排序机制,他只对线性关系敏感。如果关系是非线性的,即便两个变量具有一一对应的关系, Pearson相关性也可能会接近0。 2.2 互信息和最大信息系数Mutual information and maximal information coefficient (MIC)

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述 摘要:文本分类是信息检索和过滤过程中的一项关键技术,其任务是对未知类别的文档进行自动处理,判别它们所属于的预定义类别集合中的类别。本文主要对文本分类中所涉及的特征选择和分类算法进行了论述,并通过实验的方法进行了深入的研究。 采用kNN和Naive Bayes分类算法对已有的经典征选择方法的性能作了测试,并将分类结果进行对比,使用查全率、查准率、F1值等多项评估指标对实验结果进行综合性评价分析.最终,揭示特征选择方法的选择对分类速度及分类精度的影响。 关键字:文本分类特征选择分类算法 A Review For Feature Selection And Classification Algorithm In Text Categorization Abstract:Text categorization is a key technology in the process of information retrieval and filtering,whose task is to process automatically the unknown categories of documents and distinguish the labels they belong to in the set of predefined categories. This paper mainly discuss the feature selection and classification algorithm in text categorization, and make deep research via experiment. kNN and Native Bayes classification algorithm have been applied to test the performance of classical feature detection methods, and the classification results based on classical feature detection methods have been made a comparison. The results have been made a comprehensive evaluation analysis by assessment indicators, such as precision, recall, F1. In the end, the influence feature selection methods have made on classification speed and accuracy have been revealed. Keywords:Text categorization Feature selection Classification algorithm

图像显著性目标检测算法研究

图像显著性目标检测算法研究 随着移动电子设备的不断升级与应用,使用图像来记录或表达信息已成为一种常态。我们要想快速地在海量图像中提取出有价值的信息,那么需要模拟人类视觉系统在机器视觉系统进行计算机视觉热点问题的研究。 图像显著性目标检测对图像中最引人注意且最能表征图像内容的部分进行检测。在图像显著性目标检测任务中,传统的方法一般利用纹理、颜色等低层级视觉信息自下向上地进行数据驱动式检测。 对于含有单一目标或高对比度的自然场景图像,可以从多个角度去挖掘其显著性信息,如先验知识、误差重构等。然而,对于那些具有挑战性的自然场景图像,如复杂的背景、低对比度等,传统的方法通常会检测失败。 基于深度卷积神经网络的算法利用高层级语义信息结合上下文充分挖掘潜在的细节,相较于传统的方法已取得了更优越的显著性检测性能。本文对于图像显著性检测任务存在的主要问题提出了相应的解决方法。 本文的主要贡献如下:为充分挖掘图像多种显著性信息,并使其能够达到优势互补效果,本文提出了一种有效的模型,即融合先验信息和重构信息的显著性目标检测模型。重构过程包括密度重构策略与稀疏重构策略。 密度重构其优势在于能够更准确地定位存在于图像边缘的显著性物体。而稀疏重构更具鲁棒性,能够更有效地抑制复杂背景。 先验过程包含背景先验策略与中心先验策略,通过先验信息可更均匀地突出图像中的显著性目标。最后,把重构过程与先验过程生成的显著特征做非线性融合操作。 实验结果充分说明了该模型的高效性能与优越性能。针对图像中存在多个显

著性目标或者检测到的显著性目标存在边界模糊问题,本文提出了一种基于多层级连续特征细化的深度显著性目标检测模型。 该模型包括三个阶段:多层级连续特征提取、分层边界细化和显著性特征融合。首先,在多个层级上连续提取和编码高级语义特征,该过程充分挖掘了全局空间信息和不同层级的细节信息。 然后,通过反卷积操作对多层级特征做边界细化处理。分层边界细化后,把不同层级的显著特征做融合操作得到结果显著图。 在具有挑战性的多个基准数据集上使用综合评价指标进行性能测试,实验结果表明该方法具有优越的显著性检测性能。对于低对比度或者小目标等问题,本文提出一种新颖模型,即通道层级特征响应模型。 该模型包含三个部分:通道式粗特征提取,层级通道特征细化和层级特征图融合。该方法基于挤压激励残差网络,依据卷积特征通道之间的相关性进行建模。 首先,输入图像通过通道式粗特征提取过程生成空间信息丢失较多的粗糙特征图。然后,从高层级到低层级逐步细化通道特征,充分挖掘潜在的通道相关性细节信息。 接着,对多层级特征做融合操作得到结果显著图。在含有复杂场景的多个基准数据集上与其它先进算法进行比较,实验结果证明该算法具有较高的计算效率和卓越的显著性检测性能。

特征选择算法综述20160702

特征选择方法综述 控制与决策2012.2 问题的提出 特征选择框架基于搜索策略划分特征选择方法基于评价准则划分特征选择方法结论 一、问题的提出特征选择是从一组特征中挑选出一些最有效的特征以降低特征空间维数的过程,是模式识别的关键问题之一。对于模式识别系统,一个好的学习样本是训练分类器的关键,样本中是否含有不相关或冗余信息直接影响着分类器的性能。因此研究有效的特征选择方法至关重要。 特征选择算法的目的在于选择全体特征的一个较少特征集合,用以对原始数据进行有效表达按照特征关系度量划分,可分为依赖基尼指数、欧氏距离、信息熵。 、特征选择框架 由于子集搜索是一个比较费时的步骤,一些学者基于相关和冗余分析,给出了下面一种特征选择框架,避免了子集搜索,可以高效快速地寻找最优子集。 从特征选择的基本框架看出,特征选择方法中有4 个基本步骤:候选特征子集的生成(搜索策略)、评价准则、停止准则和验证方法。目前对特征选择方法的研究主要集中于搜索策略和评价准则。因而,本文从搜索策略和评价准则两个角度对特征选择方法进行分类。 三、基于搜索策略划分特征选择方法 基本的搜索策略按照特征子集的形成过程,形成的特征选择方法如下:

图3 基于搜索策略划分特征选择方法 其中,全局搜索如分支定界法,存在问题: 1)很难确定优化特征子集的数目; 2)满足单调性的可分性判据难以设计; 3)处理高维多类问题时,算法的时间复杂度较高。 随机搜索法如模拟退火、遗传算法、禁忌搜索算法等,存在问题: 1)具有较高的不确定性,只有当总循环次数较大时,才可能找到较好的结果。 2)在随机搜索策略中,可能需对一些参数进行设置,参数选择的合适与否对最终结果的好坏起着很大的作用。 启发式搜索如SFS、SBS、SFFS、SFBS等,存在问题: 1)虽然效率高,但是它以牺牲全局最优为代价。 每种搜索策略都有各自的优缺点,在实际应用过程中,根据具体环境和准则函数来寻找一个最佳的平衡点。例如,特征数较少,可采用全局最优搜索策略;若不要求全局最优,但要求计算速度快,可采用启发式策略;若需要高性能的子集,而不介意计算时间,则可采用随机搜索策略。 四、基于评价准则划分特征选择方法

特征选择综述

特征选择常用算法综述 一.什么是特征选择(Featureselection ) 特征选择也叫特征子集选择 ( FSS , Feature SubsetSelection ) 。是指从已有的M个特征(Feature)中选择N个特征使得系统的特定指标最优化。 需要区分特征选择与特征提取。特征提取 ( Feature extraction )是指利用已有的特征计算出一个抽象程度更高的特征集,也指计算得到某个特征的算法。 特征提取与特征选择都能降低特征集的维度。 评价函数 ( Objective Function ),用于评价一个特征子集的好坏的指标。这里用符号J ( Y )来表示评价函数,其中Y是一个特征集,J( Y )越大表示特征集Y 越好。 评价函数根据其实现原理又分为2类,所谓的Filter和Wrapper 。 Filter(筛选器):通过分析特征子集内部的信息来衡量特征子集的好坏,比如特征间相互依赖的程度等。Filter实质上属于一种无导师学习算法。 Wrapper(封装器):这类评价函数是一个分类器,采用特定特征子集对样本集进行分类,根据分类的结果来衡量该特征子集的好坏。Wrapper实质上是一种有导师学习算法。 二.为什么要进行特征选择? 获取某些特征所需的计算量可能很大,因此倾向于选择较小的特征集特征间的相关性,比如特征A完全依赖于特征B,如果我们已经将特征B选入特征集,那么特征A 是否还有必要选入特征集?我认为是不必的。特征集越大,分类器就越复杂,其后果就是推广能力(generalization capability)下降。选择较小的特征集会降低复杂度,可能会提高系统的推广能力。Less is More ! 三.特征选择算法分类 精确的解决特征子集选择问题是一个指数级的问题。常见特征选择算法可以归为下面3类: 第一类:指数算法 ( Exponential algorithms ) 这类算法对特征空间进行穷举搜索(当然也会采用剪枝等优化),搜索出来的特征集对于样本集是最优的。这类算法的时间复杂度是指数级的。

有关特征选择内容

特征选择和集成学习是当前机器学习中的两大研究热点,其研究成果己被广泛地应用于提高单个学习器的泛化能力。 特征选择是指从原始特征集中选择使某种评估标准最优的特征子集。其目的是根据一些准则选出最小的特征子集,使得任务如分类、回归等达到和特征选择前近似甚至更好的效果。通过特征选择,一些和任务无关或者冗余的特征被删除,简化的数据集常常会得到更精确的模型,也更容易理解。 滤波式(filter)方法的特征评估标准直接由数据集求得,而无需学习算法进行反馈,其优点是运行效率高,因此非常适用于集成学习.假设用于集成的特征选择算法有k种,,抽取产生m 个子训练集,在每个训练集上利用其中一种特征选择算法选出满足条件的属性作为个体svm训练的输入空间,并训练得到m个svm个体,然后对其他的特征选择算法重复执行上述过程,最后将得到的k*m 个子svm的预测结果集成. 特征选择是从一组数量为D 的原始特征中选出数量为d(D>d)的一组最优特征采用遗传退火算法进行特征选择.随机生成长度为 D 的二进制串个体其中1 的个数为d 。连续产生这样的个体M 个M 为种群规模其大小影响着遗传算法的最终结果及其执行效率M。 特征选择的目的是找出分类能力最强的特征组合需要一个定量准则来度量特征组合的分类能力。度量特征选择算法优劣的判据很多各样本之所以能分开是因为它们位于特征空间的不同区域如果类间

距离越大类内各样本间的距离越小则分类效果越好。 各种新搜索算法和评估标准都应用到特征选择算法中。如粗糙集算法,神经网络剪枝法,支持向量机的评估标准,特征集的模糊嫡评价,马尔可夫算法等

入侵检测系统的数据含有大量的冗余与噪音特征,使得系统耗用的计算资源很大,导致系统训练时间长,实时性差,检测效果不好,引入特征选择算法能够去除高维数据中无用和冗余的信息,保留对分类效果起关键作用的信息,在不影响分类效果的同时减少数据量,降低了数据存储复杂度,减轻系统负荷,提高入侵检测系统的检测速度,增强入侵检测系统的健壮性。 入侵检测问题从机器学习的角度看实际上是一个分类问题,分类器的性能不仅与分类器设计算法有关,而且与选择的特征子集有关。一个高度相关的特征子集可有效改进分类器的性能,因而特征选择(属性约简)具有重要的理论意义和应用价值。 集成学习(Ensemble Learning)是通过将一组学习器以某种方式组合在一起可以显著提高学习系统的泛化能力(有监督的分类器集成和半监督的分类器集成)。 神经网络集成可以显著地提高神经网络系统的泛化能力,被视为

分支界定算法及其在特征选择中的应用研究

分支界定算法及其在特征选择中的应用研究作者:王思臣于潞刘水唐金元 来源:《现代电子技术》2008年第10期 摘要:分支界定算法是目前为止惟一既能保证全局最优,又能避免穷尽搜索的算法。他自上而下进行搜索,同时具有回溯功能,可使所有可能的特征组合都被考虑到。对分支界定算法进行研究,并对其做了一些改进;最后对改进前后的算法在特征选择领域进行比较,选择效率有了明显的提高。 关键词:分支界定算法;特征选择;特征集;最小决策树;局部预测 中图分类号:TP31 文献标识码:A 文章编号:1004-373X(2008)10-142- (Qingdao Branch,Naval Aeronautical Engineering Institute,Qingdao, Abstract:Branch&Bound Algorithm is the only method which can ensure best of all the vectors,and it can avoid endless searching.It searches from top to bottom and has the function that from bottom to top,so it can include all of the feature vectors.The Branch&Bound Algorithm is studied in the paper,and it is improved,the two algorithms are compared by the feature seclection,the Keywords:branch&bound algorithm;feature selection;feature vector;minimum solution 随着科学技术的发展,信息获取技术的不断提高和生存能力的提升,对于目标特征能够获得的数据量越来越大,维数越来越高,一方面可以使信息更充分,但在另一方面数据中的冗余和无关部分也会相应的增多。特征选择[1,2]就是为了筛选出那些对于分类来说最相关的特征,而去掉冗余和无关的特征。 分支界定算法[1,3,4]是一种行之有效的特征选择方法,由于合理地组织搜索过程,使其有可能避免计算某些特征组合,同时又能保证选择的特征子集是全局最优的。但是如果原始特征集的维数与要选择出来的特征子集的维数接近或者高很多,其效率就不够理想。基于此,本文对分支界定算法做了一定的改进,经过实验验证,与改进前相比其效率有明显的提高。 1 分支界定算法的基本原理

第2章 感兴趣区域基本操作

第2章感兴趣区域基本操作 实验目的:掌握感兴趣区域的选取方法,为监督分类、图像数字化以及图像子集提取操作奠定基础。 主要内容:(1)感兴趣区域定义 (2)感兴趣区域编辑; (2)感兴趣区控制 第1节定义感兴趣区(Defining Regions of Interest) 感兴趣区(ROIs :Regions of Interest)是选定图像的子集。这些区域可以呈不规则的形状,通常用来提取分类的统计信息、掩膜,及其它操作。ENVI 允许选择任意的多边形、点或矢量的组合来作为一个感兴趣区。可以定义多个感兴趣区,并绘制到主图像、滚动或缩放窗口中的任何一个中。 在主图像窗口中,选择Tools> Region of Interest,出现Region of Interest Controls 对话框。 1 “I mage”、“S croll” 或“Z oom”切换按钮 通过这些按钮之间的切换来控制是否感兴趣区将定义在选择显示的主图像窗口、滚动窗口或缩放窗口内。选择“Off ”来使感兴趣区选项无效,或通过点击适当的切换按钮来取消选择所需要的窗口。 2 选择感兴趣区类型 多边形“P olygon”、折线“Polyline”、点“Point”、矩形“Rectangle”和椭圆和“Ellipse”。每种类型都有一组不同的鼠标按键任务。一个区域可以包含这五种感兴趣区类型的任意组合。 3 擦除(Erase) 如果一种感兴趣区选择了多个区域,某些区域要擦除,则先点击“Goto(转到)”按钮,转到相应的区域。然后点击“Delete Part(删除部分)”按钮。 4 新区域(New Region) 由感兴趣区类型的任意组合构成的多个区域,可以被包含在一个感兴趣区中。要启动一个新的感兴趣区,在Region of Interest Controls 对话框内,点击“New Region”,一个新名将出现在“Available Regions of Interest”列表中。 新区域将使用图示颜色列表中系统默认的下一种颜色。 第2节编辑 1 修改基本信息 要改变当前列在“A vailable Regions”下的区域的名称、颜色及区域填充类型,在

视觉显著性检测方法及其应用研究

视觉显著性检测方法及其应用研究 随着科学技术和多媒体技术的发展,人们在日常生活中产生的多媒体数据,尤其是图像数据呈指数级增长。海量的图像数据除了使人们的日常生活变得丰富多彩和便利之外,也给计算机视觉处理技术提出了新的挑战。 大部分图像中只包含了少量重要的信息,人眼视觉系统则具有从大量数据中找出少量重要信息并进行进一步分析和处理的能力。计算机视觉是指使用计算机模拟人眼视觉系统的机理,并使其可以像人类一样视察与理解事物,其中的一个关键问题为显著性检测。 本文针对目前已有显著性检测方法存在的问题,将重点从模拟人眼视觉注意机制以及针对图像像素和区域的鲁棒特征提取方法进行专门的研究。同时,本文还将显著性检测思想和方法引入到场景文本检测的研究中,既能提高场景文本检测的性能,又能拓展基于显著性检测的应用范畴。 针对人眼视觉注意机制的模拟,本文提出了一种基于超像素聚类的显著性检测方法。该方法分析了人眼视觉注意机制中由粗到细的过程,并采用计算机图像处理技术来模拟该过程。 具体而言,本文首先将原始图像分割为多个超像素,然后采用基于图的合并聚类算法将超像素进行聚类,直到只有两个类别为止,由此得到一系列具有连续类别(区域)个数的中间图像。其中在包含类别数越少的中间图像中的区域被给予更大的权重,并采用边界连通性度量来计算区域的显著性值,得到初始显著性图。 最终基于稀疏编码的重构误差和目标偏见先验知识对初始显著性图进一步细化得到最终的显著性图。针对鲁棒特征提取,本文提出了一种基于区域和像素级融合的显著性检测方法。

对于区域级显著性估计,本文提出了一种自适应区域生成技术用于区域提取。对于像素级显著性预测,本文设计了一种新的卷积神经网络(CNN)模型,该模型考虑了不同层中的特征图之间的关系,并进行多尺度特征学习。 最后,提出了一种基于CNN的显著性融合方法来充分挖掘不同显著性图(即 区域级和像素级)之间的互补信息。为了提高性能和效率,本文还提出了另一种基于深层监督循环卷积神经网络的显著性检测方法。 该网络模型在原有的卷积层中引入循环连接,从而能为每个像素学习到更丰富的上下文信息,同时还在不同层中分别引入监督信息,从而能为每个像素学习 到更具区分能力的局部和全局特征,最后将它们进行融合,使得模型能够进行多 尺度特征学习。针对基于文本显著性的场景文本检测方法的研究,本文提出了一种仅对文本区域有效的显著性检测CNN模型,该模型在不同层使用了不同的监督信息,并将多层信息进行融合来进行多尺度特征学习。 同时为了提高文本检测的性能,本文还提出了一种文本显著性细化CNN模型和文本显著性区域分类CNN模型。细化CNN模型对浅层的特征图与深层的特征图进行整合,以便提高文本分割的精度。 分类CNN模型使用全卷积神经网络,因此可以使用任意大小的图像作为模型的输入。为此,本文还提出了一种新的图像构造策略,以便构造更具区分能力的图像区域用于分类并提高分类精度。

特征选择算法综述20160702

特征选择方法综述 控制与决策 2012.2 ●问题的提出 ●特征选择框架 ●基于搜索策略划分特征选择方法 ●基于评价准则划分特征选择方法 ●结论 一、问题的提出 特征选择是从一组特征中挑选出一些最有效的特征以降低特征空间维数的过程,是模式识别的关键问题之一。对于模式识别系统,一个好的学习样本是训练分类器的关键,样本中是否含有不相关或冗余信息直接影响着分类器的性能。因此研究有效的特征选择方法至关重要。 特征选择算法的目的在于选择全体特征的一个较少特征集合,用以对原始数据进行有效表达按照特征关系度量划分,可分为依赖基尼指数、欧氏距离、信息熵。 二、特征选择框架 由于子集搜索是一个比较费时的步骤,一些学者基于相关和冗余分析,给出了下面一种特征选择框架,避免了子集搜索,可以高效快速地寻找最优子集。 从特征选择的基本框架看出,特征选择方法中有4个基本步骤:候选特征子集的生成(搜索策略)、评价准则、停止准则和验证方法。目前对特征选择方法的研究主要集中于搜索策略和评价准则。因而,本文从搜索策略和评价准则两个角度对特征选择方法进行分类。

三、基于搜索策略划分特征选择方法 基本的搜索策略按照特征子集的形成过程,形成的特征选择方法如下: 图3基于搜索策略划分特征选择方法 其中,全局搜索如分支定界法,存在问题: 1)很难确定优化特征子集的数目; 2)满足单调性的可分性判据难以设计; 3)处理高维多类问题时,算法的时间复杂度较高。 随机搜索法如模拟退火、遗传算法、禁忌搜索算法等,存在问题: 1)具有较高的不确定性,只有当总循环次数较大时,才可能找到较好的结果。 2)在随机搜索策略中,可能需对一些参数进行设置,参数选择的合适与否对最终结果的好坏起着很大的作用。 启发式搜索如SFS、SBS、SFFS、SFBS等,存在问题: 1)虽然效率高,但是它以牺牲全局最优为代价。 每种搜索策略都有各自的优缺点,在实际应用过程中,根据具体环境和准则函数来寻找一个最佳的平衡点。例如,特征数较少,可采用全局最优搜索策略;若不要求全局最优,但要求计算速度快,可采用启发式策略;若需要高性能的子集,而不介意计算时间,则可采用随机搜索策略。 四、基于评价准则划分特征选择方法

特征选择算法综述及基于某weka的性能比较

数据挖掘中的特征选择算法综述及基于WEKA的性能比较 良龙 (大学信息科学与工程学院) 摘要:自进入21世纪以来,随着信息技术的飞速发展,产生了海量的具有潜在应用价值的数据,将这些数据转换成有用的信息和知识的需求也越来越迫切,因此数据挖掘引起了信息产业界和整个社会的极大关注。特征选择作为一种常见的降维方法,在数据挖掘中起到不可忽视的作用。本文首先介绍了数据挖掘处理对象的趋势,然后概述了特征选择算法,最后通过数据挖掘软件WEKA比较了分别基于Filter和Wrapper方法的特征选择算法的性能。 关键词:数据挖掘;特征选择;WEKA;Filter;Wrapper;性能比较 A survey of feature selection algorithm in Data Mining and the performance comparison based on WEKA Abstract: As the mass of data which have potential application and value have been created by the rapid development of information technology since the 21st century, the needs to transferring these data into useful information and knowledge are being more and more urgent, so the Data Mining caused the whole society and the information industry of great concern. Feature selection is critical to Data Mining for that it is a common method to reduce dimensions. The tendency of Data Mining’s

信息熵特征选择方案样本

基于互信息的特征选择 1. 模型 定义D1 病集S 由有关心脏病病种i X ( i =1, 2, …, n) 组成, 令患者的疾病信息熵1-2为: )(1log )()(1i n i i X P X P X H ∑=-= (1) 显然疾病信息熵具有Shannon 信息熵的性质, 反映了临床中具体病人的客观信息及实际医疗干预过程中所表现的信息在总体特征上的平均不确定性. 定义D2: 一个诊断病例库能够表示为关于病例特征的矩阵形式 n m ij x Casebase ?=][ (2) 其中, ij x —病例库中第j 个病例的第i 个属性值; m —病例特征数量; n —病例库规模; 定义D3: 一个信息系统( IS) 能够表示为 ,,,r r f R I U R V f ∈=<> (3) 其中, U 是对象的非空有限集合, R 是属性的非空有限集合, r r R V V ∈= 是属性值 的集合, V r 表示了属性任意r R ∈时的属性值范围, :r f U R V ?→ 是一个信息函数, 它指定U 中每一个对象 x 的属性值. 1 马笑潇, 黄席樾, 等. 基于信息熵的诊断过程认知信息流分析[J]. 重庆大学学报: 自然科学版, ,25(5):25-28. 2 王园, 吉国力, 魏磊. 信息熵在临床定量诊断分析中的研究及应用[J]. 厦门大学学报: 自然科学版, ,43(B08):353-356.

当R 中的属性集可进一步分解为条件属性集合C 和决策属性集合D, 且满足 ,R C D C D =? ?=?时, 信息系统(IS)称为决策系统(DS)3. a i 为某一条件属性, 则决策属性D 对某一条件属性a i 的依赖程度能够利用下式计算4-5: ( 4) 式中, R C 、 R D 分别表示条件属性集合C 和策属性集合D 在论域上的等价关 系.()D C R H R 表示R D 相对于R C 的条件熵.(,)i I a D 的值越大, 则条件属性a i 对决策属性D 的重要性越大.如果(,)0i I a D =, 则说明a i 对于D 不起作用, 能够删除.在基于属性信息增益的约简方法中, 计算案例库属性集的每个属性的信息增益, 并约定属性的信息增益大于某个阈值时就将该属性归入最优属性子集, 否则弃用属性. 1.3 基于互信息的特征选择6: 三种经典的基于互信息的特征选择算法, 分别为信息增益、 互信息和交叉熵, 以及于互信息最大化的特征选择算法7。 3 张文宇. 数据挖掘与粗糙集方法[M]. 西安电子科技大学出版社, : 49. 4 屈利, 苑津莎, 李丽. 基于事例推理的电力系统短期负荷预测[J]. 电力科学与工程, ,24(2):59-63. 5 程其云, 孙才新, 周湶, 等. 粗糙集信息熵与自适应神经网络模糊系统相结合的电力短期负荷预测模型及方法[J]. 电网技术, ,28 (17): 72-75. 6 Li Y F, Xie M, Goh T N. A study of mutual information based feature selection for case based reasoning in software cost estimation [J]. Expert Systems with Applications, , 36(3, Part 2): 5921-5931. 7唐亮,段建国,许洪波,梁玲.基于互信息最大化的特征选择算法及应用[J]. 计算机工程与应用, ,44(13):130-133

特征选择、特征提取MATLAB算法实现(模式识别)

6特征选择 6.1问题 对“threethreelarge.m”数据,采用任意一种特征选择算法,选择2个特征 6.2思路 采用简单特征选择法(simple feature selection approach),首先计算每一个特征的分类能力值,再选择出其中最大分类能力的l个特征。 6.3结果 eigs=8.92340.00000.0767 SelectedFeature=13 也就是说,选取x和z坐标作为特征。 6.4代码 %特征选择代码,见FSthrthrlrg.m文件 m1=[0,0,0];m2=[0,0,0];m3=[0,0,0];m=[0,0,0]; for i=1:200 m1(1)=m1(1)+(x1(i,1)-m1(1))/i; m1(2)=m1(2)+(x1(i,2)-m1(2))/i; m1(3)=m1(3)+(x1(i,3)-m1(3))/i; end; for i=1:190 m2(1)=m2(1)+(x2(i,1)-m2(1))/i; m2(2)=m2(2)+(x2(i,2)-m2(2))/i; m2(3)=m2(3)+(x2(i,3)-m2(3))/i; end; for i=1:210 m3(1)=m3(1)+(x3(i,1)-m3(1))/i; m3(2)=m3(2)+(x3(i,2)-m3(2))/i; m3(3)=m3(3)+(x3(i,3)-m3(3))/i; end; m(1)=(m1(1)+m2(1)+m3(1))/3; m(2)=(m1(2)+m2(2)+m3(2))/3; m(3)=(m1(3)+m2(3)+m3(3))/3; sw1=zeros(3,3);sw2=zeros(3,3);sw3=zeros(3,3);sw=zeros(3,3);sb=zeros(3,3); for i=1:200 sw1=sw1+([x1(i,1),x1(i,2),x1(i,3)]-m1)'*([x1(i,1),x1(i,2),x1(i,3)]-m1); end; for i=1:190 sw2=sw2+([x2(i,1),x2(i,2),x2(i,3)]-m2)'*([x2(i,1),x2(i,2),x2(i,3)]-m2); end; for i=1:210 sw3=sw3+([x3(i,1),x3(i,2),x3(i,3)]-m3)'*([x3(i,1),x3(i,2),x3(i,3)]-m3); end; N1=200;N2=190;N3=210;N=N1+N2+N3;

特征选择、特征提取matlab算法实现(模式识别)

6 特征选择 6.1 问题 对“threethreelarge.m”数据,采用任意一种特征选择算法,选择2个特征 6.2 思路 采用简单特征选择法(simple feature selection approach),首先计算每一个特征的分类能力值,再选择出其中最大分类能力的l个特征。 6.3 结果 eigs = 8.9234 0.0000 0.0767 SelectedFeature = 1 3 也就是说,选取x和z坐标作为特征。 6.4 代码 % 特征选择代码,见FSthrthrlrg.m文件 m1=[0,0,0]; m2=[0,0,0]; m3=[0,0,0]; m=[0,0,0]; for i=1:200 m1(1)=m1(1)+(x1(i,1)-m1(1))/i; m1(2)=m1(2)+(x1(i,2)-m1(2))/i; m1(3)=m1(3)+(x1(i,3)-m1(3))/i; end; for i=1:190 m2(1)=m2(1)+(x2(i,1)-m2(1))/i; m2(2)=m2(2)+(x2(i,2)-m2(2))/i; m2(3)=m2(3)+(x2(i,3)-m2(3))/i; end; for i=1:210 m3(1)=m3(1)+(x3(i,1)-m3(1))/i; m3(2)=m3(2)+(x3(i,2)-m3(2))/i; m3(3)=m3(3)+(x3(i,3)-m3(3))/i; end; m(1)=(m1(1)+m2(1)+m3(1))/3; m(2)=(m1(2)+m2(2)+m3(2))/3; m(3)=(m1(3)+m2(3)+m3(3))/3; sw1=zeros(3,3); sw2=zeros(3,3); sw3=zeros(3,3); sw=zeros(3,3); sb=zeros(3,3); for i=1:200 sw1=sw1+([x1(i,1),x1(i,2),x1(i,3)]-m1)'*([x1(i,1),x1(i,2),x1(i,3)]-m1); end; for i=1:190 sw2=sw2+([x2(i,1),x2(i,2),x2(i,3)]-m2)'*([x2(i,1),x2(i,2),x2(i,3)]-m2); end; for i=1:210 sw3=sw3+([x3(i,1),x3(i,2),x3(i,3)]-m3)'*([x3(i,1),x3(i,2),x3(i,3)]-m3); end; N1=200; N2=190; N3=210; N=N1+N2+N3;