epc10膜片钳patchmaster数据处理分析2

EPC10膜片钳PatchMaster数据处理分析PatchMaster生成以.dat为后缀格式的数据,用相应的记录软件PatchMaster可以直接打开,尽管在PatchMaster提供的Online Analysis功能可以对感兴趣的参数数据进行获取并输出,但是对某些数据的分析还需借助第三方软件处理后再进一步的分析;在此结合实际使用,总结一下对突触后电流发放及多个动作电位如何更好的分析,这两种数据的特点是需要对多个电流或电位的峰值、阈值、时程等多个参数进行获取,目前国内处理这类数据主要使用MiniAnalysis软件,因此如何运用MiniAnalysis转换并处理以上两种数据进行总结,供大家参考。

1.数据初步输出

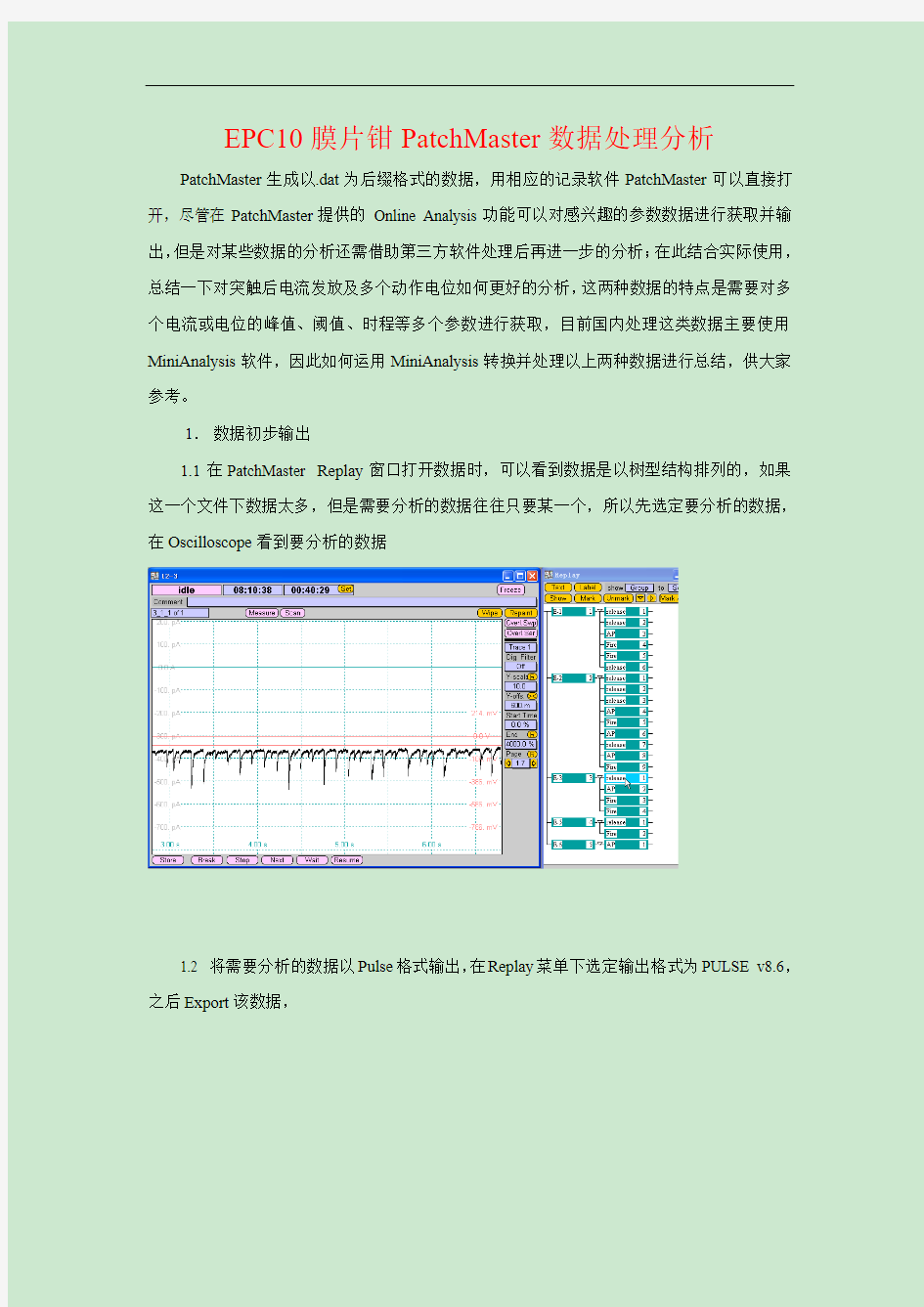

1.1在PatchMaster Replay窗口打开数据时,可以看到数据是以树型结构排列的,如果这一个文件下数据太多,但是需要分析的数据往往只要某一个,所以先选定要分析的数据,在Oscilloscope看到要分析的数据

1.2 将需要分析的数据以Pulse格式输出,在Replay菜单下选定输出格式为PULSE v8.6,之后Export该数据,

选好路径,保存该数据就可以了,这样主要是为了使要分析的数据成为单独的一个data ,便于后续的转换和分析。

2. 数据转换

在安装了MiniAnalysis 软件后会有一个附加的功能ABF

Utility ,准备利用它进行数据转换,打开后找到刚才保存下的数据,选中.dat 格式的文件,然后点击右侧Convert Known File to ABF ,

此时会提示未知格式是否转换,选Yes,出来个对话窗口,此窗口参数填写一定要正确,在Sampling Interval 填写与Patchmaster采集该数据时一致的采样率,这样确保转换出来的数据X轴正确,下面Unit 单位选择pA或mV与你采集的数据一致,Scaling Factor确保Y轴一致,原始数据Y值如果是电流值的话,在Gain是1情况下采集的信号,写0.001,Gain 2写0.002 ,电压值的话0.01,以此类推,实际中多试几次确保转换后的Y值与原始值想匹配,在上述值都正确的情况下点击Convert to ABF,这样在主窗口的右侧出现转换后的数据,

至此,数据转换结束。

3.数据分析

通过上述方法转换后的数据可以直接用clampfit 或minianalysis打开了,根据需要可以选择适合的软件分析数据。在此,主要说一下MiniAnalysis的使用。

打开MiniAnalysis 主程序,通过右侧Flies打开转换后的文件一定要是.ABF格式的,通过调整左侧上方控件Gain及左侧游标位置,及左下方x轴大小将电流图调整合适。

此时选择右上方Analysis,出现一些分析需要设定的选项,根据数据设置合理的选项进行自动分析,下面的Analysis this window 点击会根据设定的相应值对事件自动分析在下方就看到每个events的各个参数,可以根据初步得到的参数对以前设定的值进行调整,将所要研究的Events都包括进去,也可以用鼠标直接点击电流图中的各个Events得到相应的参数,这样接着在Analysis next window 或nonstop analysis对所有数据自动分析完毕。

各个Event参数可以选定复制到Excel、Origin、SigmaPlot等数据分析绘图软件里进行进一步的分析绘图。

该数据处理完毕后就形成一个处理后的数据,此时不能直接关闭MiniAnalysis 软件,否则此处理结果不会保存,可以选择另一个需要分析的数据,选Yes,这样就会出现一个.EVT

格式文件,这样以后就可以直接用MiniAnalysis打开分析过的数据。

定性数据分析第二章课后答案(供参考)

第二章课后作业 【第1题】 解:由题可知消费者对糖果颜色的偏好情况(即糖果颜色的概率分布),调查者 取500块糖果作为研究对象,则以消费者对糖果颜色的偏好作为依据,500块糖果的颜色分布如下表1.1所示: 表1.1 理论上糖果的各颜色数 由题知r=6,n=500,我们假设这些数据与消费者对糖果颜色的偏好分布是相符,所以我们进行以下假设: 原假设::0H 类i A 所占的比例为)6,...,1(0==i p p i i 其中i A 为对应的糖果颜色,)6,...,1(0=i p i 已知,16 10=∑=i i p 则2χ检验的计算过程如下表所示: 在这里6=r 。检验的p 值等于自由度为5的2χ变量大于等于18.0567的概率。在Excel 中输入“)5,0567.18(chidist =”,得出对应的p 值为05.00028762.0<<=p ,故拒绝原假设,即这些数据与消费者对糖果颜色的偏好分布不相符。 【第2题】 解:由题可知 ,r=3,n=200,假设顾客对这三种肉食的喜好程度相同,即顾客 选择这三种肉食的概率是相同的。所以我们可以进行以下假设:

原假设 )3,2,1(3 1 :0==i p H i 则2χ检验的计算过程如下表所示: 在这里3=r 。检验的p 值等于自由度为2的2χ变量大于等于15.72921的概率。在Excel 中输入“)2,72921.15(chidist =”,得出对应的p 值为 05.00003841.0<<=p ,故拒绝原假设,即认为顾客对这三种肉食的喜好程度是 不相同的。 【第3题】 解:由题可知 ,r=10,n=800,假设学生对这些课程的选择没有倾向性,即选 各门课的人数的比例相同,则十门课程每门课程被选择的概率都相等。所以我们可以进行以下假设: 原假设)10,...,2,1(1.0:0==i p H i 则2χ检验的计算过程如下表所示: 在这里10=r 。检验的p 值等于自由度为9的2χ变量大于等于5.125的概率。在Excel 中输入“)9,125.5(chidist =”,得出对应的p 值为05.0823278349.0>>=p ,

最新分析化学--分析结果的数据处理

§2-2 分析结果的数据处理 一、可疑测定值的取舍 1、可疑值:在平行测定的数据中,有时会出现一二个与其它结果相差较大的测定值,称为可疑值或异常值(离群值、极端值) 2、方法 ㈠、Q 检验法:由迪安(Dean )和狄克逊(Dixon )在1951年提出。 步骤: 1、将测定值由小至大按顺序排列:x 1,x 2,x 3,…x n-1,x n ,其中可疑值为x 1或 x n 。 2、求出可疑值与其最邻近值之差x 2-x 1或x n -x n-1。 3、用上述数值除以极差,计算出Q Q=11χχχχ---n n n 或Q=11 2χχχχ--n 4、根据测定次数n 和所要求的置信度P 查Q p ,n 值。(分析化学中通常取0.90的置信度) 5、比较Q 和Q p ,n 的大小: 若Q >Q p ,n ,则舍弃可疑值; 若Q <Q p ,n ,则保留可疑值。 例:4次测定铁矿石中铁的质量分数(%)得40.02, 40.16,40.18和40.20。 ㈡、格鲁布斯法: 步骤: 1、将测定值由小至大按顺序排列:x 1,x 2,x 3,…x n-1,x n ,其中可疑值为x 1或 x n 。 2、计算出该组数据的平均值x 和标准偏差s 。 3、计算统计量G : 若x 1为可疑值,则G==s 1 χχ-

若x n 为可疑值,则G==s n χ χ- 4、根据置信度P 和测定次数n 查表得G p ,n ,比较二者大小 若G >G p ,n ,说明可疑值相对平均值偏离较大,则舍去; 若G <G p ,n ,则保留。 注意:置信度通常取0.90或0.95。 例1:分析石灰石铁含量4次,测定结果为:1.61%, 1.53%,1.54%和1.83%。问上述各值中是否有应该舍弃的可疑值。(用格鲁布斯检验法检验 P=0.95) 例 2 测定碱灰中总碱量(以w Na 2O 表示),5次测定结果分别为:40.10%,40.11%,40.12%,40.12%和40.20% (1)用格鲁布斯法检验40.20%是否应该舍去;(2)报告经统计处理后的分析结果;(3)用m 的置信区间表示分析结果(P=0.95) 二、显著性检验 用统计的方法检验测定值之间是否存在显著性差异,以此推测它们之间是否存在系统误差,从而判断测定结果或分析方法的可靠性,这一过程称为显著性检验。 定量分析中常用的有t 检验法和F 检验法。 ㈠、样本平均值与真值的比较(t 检验法) 1、原理:t 检验法用来检验样本平均值与标准值或两组数据的平均值之间是否存在显著性差异,从而对分析方法的准确度作出评价,其根据是样本随机误差的t 分布规律。 2、步骤: ①、计算平均值和平均值的标准偏差。 ②、由P 13式 μ= x±t p,f s=μ= x±t p,f n s 得:T -χ== t p,f s x 得 t==X S T -χ 根据上式计算t 值。 ③、查表得t p,f ,比较t 值

大数据分析及其在医疗领域中的应用-图文(精)

第7期 24 2014年4月10日 计算机教育 ComputerEducation ◆新视点 文章编号:1672.5913(2014)07—0024-06 中图分类号:G642 大数据分析及其在医疗领域中的应用 邹北骥 (中南大学信息科学与工程学院,湖南长沙410083) 摘要:互联网和物联网技术的快速发展给数据的上传与下载带来了前所未有的便利,使得互联网上 的数据量急剧增长,由此产生了针对大数据的存储、计算、分析、处理等新问题,尤其是对大数据的挖掘。文章分析当前大数据产生的背景,阐述大数据的基本特征及其应用,结合医疗领域,论述医疗 大数据分析的目的、意义和主要方法。 关键词:大数据;物联网;医疗;大数据挖掘 1 大数据早已存在,为何现在称之为大

数据时代 计算与数据是一对孪生姐妹,计算需要数据,数据通过计算产生新的价值。数据是客观事 物的定量表达,来自于客观世界并早已存在。例 如,半个世纪前,全球的人口数量就有数十亿,与之相关的数据就是大数据;但是在那个时代,由于技术的局限性,大数据的采集、存储和处理 还难以实现。 互联网时代之前,采集世界各地的数据并让它们快速地进入计算系统几乎是一件不可想象的 事情。20世纪80年代兴起的互联网技术在近30 年里发生了翻天覆地的变化,彻底地改变了人们的工作和生活方式【l】。通过互联网人们不仅可以下载到新闻、小说、论文等各类文字数据,而且可以轻而易举地下载到音乐、图像和视频等多媒体数据,这使得互联网上的数据流量急剧增长。据统计,现在互联网上每分钟流人流出的数 据量达到1 000 PB,即10亿 GBt21。 推动大数据产生的另一个重要因素是物联网技术。近几年发展起来的物联网技 术通过给每个物品贴上标签 并应用RFID等技术实现了

大数据处理框架选型分析

大数据处理框架选型分析

前言 说起大数据处理,一切都起源于Google公司的经典论文:《MapReduce:Simplied Data Processing on Large Clusters》。在当时(2000年左右),由于网页数量急剧增加,Google公司内部平时要编写很多的程序来处理大量的原始数据:爬虫爬到的网页、网页请求日志;计算各种类型的派生数据:倒排索引、网页的各种图结构等等。这些计算在概念上很容易理解,但由于输入数据量很大,单机难以处理。所以需要利用分布式的方式完成计算,并且需要考虑如何进行并行计算、分配数据和处理失败等等问题。 针对这些复杂的问题,Google决定设计一套抽象模型来执行这些简单计算,并隐藏并发、容错、数据分布和均衡负载等方面的细节。受到Lisp和其它函数式编程语言map、reduce思想的启发,论文的作者意识到许多计算都涉及对每条数据执行map操作,得到一批中间key/value对,然后利用reduce操作合并那些key值相同的k-v对。这种模型能很容易实现大规模并行计算。 事实上,与很多人理解不同的是,MapReduce对大数据计算的最大贡献,其实并不是它名字直观显示的Map和Reduce思想(正如上文提到的,Map和Reduce思想在Lisp等函数式编程语言中很早就存在了),而是这个计算框架可以运行在一群廉价的PC机上。MapReduce的伟大之处在于给大众们普及了工业界对于大数据计算的理解:它提供了良好的横向扩展性和容错处理机制,至此大数据计算由集中式过渡至分布式。以前,想对更多的数据进行计算就要造更快的计算机,而现在只需要添加计算节点。 话说当年的Google有三宝:MapReduce、GFS和BigTable。但Google三宝虽好,寻常百姓想用却用不上,原因很简单:它们都不开源。于是Hadoop应运而生,初代Hadoop的MapReduce和

第二章 误差和分析数据处理

第二章误差和分析数据处理 1.指出下列各种误差是系统误差还是偶然误差?如果是系统误差,请区别方法误差、仪器和试剂误差或操作误差,并给出它们的减免办法。 (1)砝码受腐蚀;(2)天平的两臂不等长;(3)容量瓶与移液管未经校准;(4)在重量分析中,试样的非被测组分被共沉淀;(5)试剂含被测组分;(6)试样在称量过程中吸湿;(7)化学计量点不在指示剂的变色范围内;(8)读取滴定管读数时,最后一位数字估计不准;(9)在分光光度法测定中,波长指示器所示波长与实际波长不符。(10)在HPLC测定中,待测组分峰与相邻杂质峰部分重叠。 答:(1)系统误差;校准砝码。 (2)系统误差;校准仪器。 (3)系统误差;校准仪器。 (4)系统误差;控制条件扣除共沉淀。 (5)系统误差;扣除试剂空白或将试剂进一步提纯。 (6)系统误差;在110℃左右干燥后称重。 (7)系统误差;重新选择指示剂。 (8)偶然误差;最后一位是估计值,因而估计不准产生偶然误差。 (9)系统误差;校准仪器。 (10)系统误差;重新选择分析条件。 2.表示样本精密度的统计量有哪些? 与平均偏差相比,标准偏差能更好地表示一组数据的离散程度,为什么? 3.说明误差与偏差、准确度与精密度的区别和联系。 4.什么叫误差传递?为什么在测量过程中要尽量避免大误差环节? 5.何谓t分布?它与正态分布有何关系? 6.在进行有限量实验数据的统计检验时,如何正确选择置信水平? 7.为什么统计检验的正确顺序是:先进行可疑数据的取舍,再进行F检验,在F检验通过后,才能进行t检验? 8.说明双侧检验与单侧检验的区别,什么情况用前者或后者? 9.何谓线性回归?相关系数的意义是什么? 10.进行下述运算,并给出适当位数的有效数字。

大数据处理及分析理论方法技术

大数据处理及分析理论方法技术 (一)大数据处理及分析建设的过程 随着数据的越来越多,如何在这些海量的数据中找出我们需要的信息变得尤其重要,而这也是大数据的产生和发展原因,那么究竟什么是大数据呢?当下我国大数据研发建设又有哪些方面着力呢? 一是建立一套运行机制。大数据建设是一项有序的、动态的、可持续发展的系统工程,必须建立良好的运行机制,以促进建设过程中各个环节的正规有序,实现统合,搞好顶层设计。 二是规范一套建设标准。没有标准就没有系统。应建立面向不同主题、覆盖各个领域、不断动态更新的大数据建设标准,为实现各级各类信息系统的网络互连、信息互通、资源共享奠定基础。

三是搭建一个共享平台。数据只有不断流动和充分共享,才有生命力。应在各专用数据库建设的基础上,通过数据集成,实现各级各类指挥信息系统的数据交换和数据共享。 四是培养一支专业队伍。大数据建设的每个环节都需要依靠专业人员完成,因此,必须培养和造就一支懂指挥、懂技术、懂管理的大数据建设专业队伍。 (二)大数据处理分析的基本理论 对于大数据的概念有许多不同的理解。中国科学院计算技术研究所李国杰院士认为:大数据就是“海量数据”加“复杂数据类型”。而维基百科中的解释为:大数据是由于规模、复杂性、实时性而导致的使之无法在一定时间内用常规软件工具对其进行获取、存储、搜索、分享、分析、可视化的数据集合。 对于“大数据”(Bigdata)研究机构Gartner给出了这样的定义。“大数据”是需要新处理模式才能具有更强的决

图2.1:大数据特征概括为5个V (三)大数据处理及分析的方向 众所周知,大数据已经不简简单单是数据大的事实了,而最重要的现实是对大数据进行分析,只有通过分析才能获取很多智能的,深入的,有价值的信息。那么越来越多的应用涉及到大数据,而这些大数据的属性,包括数量,速度,多样性等等都是呈现了大数据不断增长的复杂性,所以大数据的分析方法在大数据领域就显得尤为重要,可以说是决定

第七章分析化学中的数据处理

第七章分析化学中的数据处理 一、大纲要求及考点提示 掌握准确度、精密度的概念和表示方法;了解误差产生原因及减免方法;了解统计学的基本概念;熟悉有限次实验数据的统计处理;熟悉有效数字及运算规则。 二、主要概念、重要定理与公式 (一)基本概念 1. 平行测定:由同一个人,用同一种方法,对同一个样品进行的多次测定,称平行测定。 2. 平均值 3. 平均偏差 偏差是用于衡量分析结果的精密度。平均偏差是用来表示一组测定结果的精密度。 4. 相对平均偏差 5. 样本标准偏差 这是最常用的表示分析结果精密度的方法,用标准偏差衡量数据的分散程度比平均偏差更为恰当。对有限次测量所得到的分析数据,标准偏差为样本标准偏差 6. 总体标准偏差 当测量次数为无限多次时,各测量值对总体平均值的偏差,用总体标准偏差表示。 7. 相对标准偏差 相对标准偏差(也叫变异系数) 8. 标准偏差与平均偏差 当测量次数非常多时,标准偏差与标准偏差有下列关系:δ=0.797σ≈0.80σ 9. 平均值的标准偏差 (二)随机误差的正态分布 1.正态分布 分析化学中测量结果的数据一般都符合正态分布的规律。 2.随机误差的区间概率 3.少量数据的统计处理 (1) t检验法: 对于少量实验数据要用t分布进行统计处理,以合理推断总体的特性。t分布曲线下一定范围内的积分面积就是t值在该范围内出现的概率。: (2) F检验法 检验两组数据的精密度是否存在差异,要用F检验法。 4.异常值的取舍 一组平行测定数据,有时会有个别离群数据。对不能确定的异常值要进行校验后进行取舍。常用的异常值的检验方法有Q检验法、4d法、Groubbs法等。 5.误差传递 (1)系统误差的传递规则: 加减法运算时,分析结果的巨额多误差是各部绝对误差的代数和,如果有关项有系数,

大数据处理流程的主要环节

大数据处理流程的主要环节 大数据处理流程主要包括数据收集、数据预处理、数据存储、数据处理与分析、数据展示/数据可视化、数据应用等环节,其中数据质量贯穿于整个大数据流程,每一个数据处理环节都会对大数据质量产生影响作用。通常,一个好的大数据产品要有大量的数据规模、快速的数据处理、精确的数据分析与预测、优秀的可视化图表以及简练易懂的结果解释,本节将基于以上环节分别分析不同阶段对大数据质量的影响及其关键影响因素。 一、数据收集 在数据收集过程中,数据源会影响大数据质量的真实性、完整性数据收集、一致性、准确性和安全性。对于Web数据,多采用网络爬虫方式进行收集,这需要对爬虫软件进行时间设置以保障收集到的数据时效性质量。比如可以利用八爪鱼爬虫软件的增值API设置,灵活控制采集任务的启动和停止。 二、数据预处理 大数据采集过程中通常有一个或多个数据源,这些数据源包括同构或异构的数据库、文件系统、服务接口等,易受到噪声数据、数据值缺失、数据冲突等影响,因此需首先对收集到的大数据集合进行预处理,以保证大数据分析与预测结果的准确性与价值性。

大数据的预处理环节主要包括数据清理、数据集成、数据归约与数据转换等内容,可以大大提高大数据的总体质量,是大数据过程质量的体现。数据清理技术包括对数据的不一致检测、噪声数据的识别、数据过滤与修正等方面,有利于提高大数据的一致性、准确性、真实性和可用性等方面的质量; 数据集成则是将多个数据源的数据进行集成,从而形成集中、统一的数据库、数据立方体等,这一过程有利于提高大数据的完整性、一致性、安全性和可用性等方面质量; 数据归约是在不损害分析结果准确性的前提下降低数据集规模,使之简化,包括维归约、数据归约、数据抽样等技术,这一过程有利于提高大数据的价值密度,即提高大数据存储的价值性。 数据转换处理包括基于规则或元数据的转换、基于模型与学习的转换等技术,可通过转换实现数据统一,这一过程有利于提高大数据的一致性和可用性。 总之,数据预处理环节有利于提高大数据的一致性、准确性、真实性、可用性、完整性、安全性和价值性等方面质量,而大数据预处理中的相关技术是影响大数据过程质量的关键因素 三、数据处理与分析 1、数据处理 大数据的分布式处理技术与存储形式、业务数据类型等相关,针对大数据处理的主要计算模型有MapReduce分布式计算框架、分布式内存计算系统、分布式流计算系统等。

简析大数据及其处理分析流程

昆明理工大学 空间数据库期末考察报告《简析大数据及其处理分析流程》 学院:国土资源工程学院 班级:测绘121 姓名:王易豪 学号:201210102179 任课教师:李刚

简析大数据及其处理分析流程 【摘要】大数据的规模和复杂度的增长超出了计算机软硬件能力增长的摩尔定律,对现有的IT架构以及计算能力带来了极大挑战,也为人们深度挖掘和充分利用大数据的大价值带来了巨大机遇。本文从大数据的概念特征、处理分析流程、大数据时代面临的挑战三个方面进行详细阐述,分析了大数据的产生背景,简述了大数据的基本概念。 【关键词】大数据;数据处理技术;数据分析 引言 大数据时代已经到来,而且数据量的增长趋势明显。据统计仅在2011 年,全球数据增量就达到了1.8ZB (即1.8 万亿GB)[1],相当于全世界每个人产生200GB 以上的数据,这些数据每天还在不断地产生。 而在中国,2013年中国产生的数据总量超过0.8ZB(相当于8亿TB),是2012年所产生的数据总量的2倍,相当于2009年全球的数据总量[2]。2014年中国所产生的数据则相当于2012 年产生数据总量的10倍,即超过8ZB,而全球产生的数据总量将超40ZB。数据量的爆发式增长督促我们快速迈入大数据时代。 全球知名的咨询公司麦肯锡(McKinsey)2011年6月份发布了一份关于大数据的详尽报告“Bigdata:The next frontier for innovation,competition,and productivity”[3],对大数据的影响、关键技术和应用领域等都进行了详尽的分析。进入2012年以来,大数据的关注度与日俱增。

分析化学中的数据处理

分析化学中的数据处理 第7章分析化学中的数据处理 教学目的:用数理统计的方法处理实验数据,将会更好地表达结果,既能显示出测量的精密度,又能表达出结果的准确度;介绍显着性检验的方法,用于检验样本值与标准值的比较、两个平均值的比较和可疑值的取舍。 教学重点:总体平均值的估计;t检验法 教学难点:对随机变量正态分布的理解;各种检验法的正确使用,双侧和单侧检验如何查表。 1.总体与样本 总体:在统计学中,对于所考察的对象的全体,称为总体(或母体)。 个体:组成总体的每个单元。 样本(子样):自总体中随机抽取的一组测量值(自总体中随机抽取的一部分个体)。 样本容量:样品中所包含个体的数目,用n表示。 例题: 分析延河水总硬度,依照取样规则,从延河取来供分析用2000ml样品水,这2000ml样品水是供分析用的总体,如果从样品水中取出20个试样进行平行分析,得到20个分析结果,则这组分析结果就是延河样品水的一个随机样本,样本容量为20。 2.随机变量来自同一总体的无限多个测量值都是随机出现的,叫随机变量。 ,(总体平均值),(单次测量的平均偏差) 7.1 标准偏差 7.1.1总体标准偏差(无限次测量) n-测量次数 7.1.2样本标准偏差(有限次测量) (n-1)-自由度 7.1.3相对标准偏差 相对标准偏差(变异系数) 7.1.4标准偏差与平均偏差 当测定次数非常多(n大于20)时,,但是 7.1.5平均值的标准偏差 统计学可证明平均值的标准偏差与单次测量结果的标准偏差存在下列关系:,(无限次测量) ,(有限次测量)

7.2 随机误差的正态分布 7.2.1频数分布 频数:每组中数据的个数。 相对频数:频数在总测定次数中所占的分数。 频数分布直方图:以各组分区间为底,相对频数为高做成的一排矩形。 特点: 1. 离散特性:测定值在平均值周围波动。波动的程度用总体标准偏差?表示。 2. 集中趋势:向平均值集中。用总体平均值?表示。在确认消除了系统误差的前提下,总体平均值就是真值。 7.2.2正态分布(无限次测量) 1.正态分布曲线:如果以x-?(随机误差)为横坐标,曲线最高点横坐标为0,这时表示的是随机误差的正态分布曲线。 ,记为:N(?,?2), ?-决定曲线在X轴的位置 ?-决定曲线的形状,?小?曲线高、陡峭,精密度好;??曲线低、平坦,精密度差。 随机误差符合正态分布:(1) (1)大误差出现的几率小,小误差出现的几率大; (2)绝对值相等的正负误差出现的几率相等; (3)误差为零的测量值出现的几率最大。 (4) x=?时的概率密度为 2.标准正态分布N(0,1) 令, 7.2.3随机误差的区间概率 所有测量值出现的概率总和应为1,即 求变量在某区间出现的概率, 概率积分表,p248。注意:表中列出的是单侧概率,求?u间的概率,需乘以2。 随机误差出现的区间测量值出现的区间概率 u=?1 x=??1? 0.3413×2=68.26%u=?2 x=??2? 0.4773×2=95.46%u=?3 x=??3? 0.4987×2=99.74%结论: 1.随机误差超过3?的测量值出现的概率仅占0.3%。 2.当实际工作中,如果重复测量中,个别数据误差的绝对值大于3?,则这些测量值可舍去。

分析化学-分析结果的数据处理

§2-2 分析结果的数据处理 一、可疑测定值的取舍 1、可疑值:在平行测定的数据中,有时会出现一二个与其它结果相差较大的测定值,称为可疑值或异常值(离群值、极端值) 2、方法 ㈠、Q 检验法:由迪安(Dean )和狄克逊(Dixon )在1951年提出。 步骤: 1、将测定值由小至大按顺序排列:x 1,x 2,x 3,…x n-1,x n ,其中可疑值为x 1或 x n 。 2、求出可疑值与其最邻近值之差x 2-x 1或x n -x n-1。 3、用上述数值除以极差,计算出Q Q=11χχχχ---n n n 或Q=11 2χχχχ--n 4、根据测定次数n 和所要求的置信度P 查Q p ,n 值。(分析化学中通常取0.90的置信度) 5、比较Q 和Q p ,n 的大小: 若Q >Q p ,n ,则舍弃可疑值; 若Q <Q p ,n ,则保留可疑值。 例:4次测定铁矿石中铁的质量分数(%)得40.02, 40.16,40.18和40.20。 ㈡、格鲁布斯法: 步骤: 1、将测定值由小至大按顺序排列:x 1,x 2,x 3,…x n-1,x n ,其中可疑值为x 1或 x n 。 2、计算出该组数据的平均值x 和标准偏差s 。 3、计算统计量G : 若x 1为可疑值,则G==s 1 χχ-

若x n 为可疑值,则G==s n χ χ- 4、根据置信度P 和测定次数n 查表得G p ,n ,比较二者大小 若G >G p ,n ,说明可疑值相对平均值偏离较大,则舍去; 若G <G p ,n ,则保留。 注意:置信度通常取0.90或0.95。 例1:分析石灰石铁含量4次,测定结果为:1.61%, 1.53%,1.54%和1.83%。问上述各值中是否有应该舍弃的可疑值。(用格鲁布斯检验法检验 P=0.95) 例 2 测定碱灰中总碱量(以w Na 2O 表示),5次测定结果分别为:40.10%,40.11%,40.12%,40.12%和40.20% (1)用格鲁布斯法检验40.20%是否应该舍去;(2)报告经统计处理后的分析结果;(3)用m 的置信区间表示分析结果(P=0.95) 二、显著性检验 用统计的方法检验测定值之间是否存在显著性差异,以此推测它们之间是否存在系统误差,从而判断测定结果或分析方法的可靠性,这一过程称为显著性检验。 定量分析中常用的有t 检验法和F 检验法。 ㈠、样本平均值与真值的比较(t 检验法) 1、原理:t 检验法用来检验样本平均值与标准值或两组数据的平均值之间是否存在显著性差异,从而对分析方法的准确度作出评价,其根据是样本随机误差的t 分布规律。 2、步骤: ①、计算平均值和平均值的标准偏差。 ②、由P 13式 μ= x±t p,f s=μ= x±t p,f n s 得:T -χ== t p,f s x 得 t==X S T -χ 根据上式计算t 值。 ③、查表得t p,f ,比较t 值

课程名称大数据分析与应用

课程名称:大数据分析与应用 一、课程编码: 课内学时:32学分:2 二、适用学科专业:计算机专业硕士 三、先修课程:无 四、教学目标 通过本课程的课堂学习与应用案例,建立科学的大数据观,掌握大数据架构、大数据精准语义搜索、大数据语义分析挖掘、知识图谱等关键技术,熟练使用常用的大数据搜索挖掘与可视化工具,提升大数据的综合应用能力。 五、教学方式 课堂学习、研讨班与应用实践 六、主要内容及学时分配 1.科学的大数据观2学时 1.1.大数据的定义,科学发展渊源; 1.2.如何科学看待大数据? 1.3.如何把握大数据,分别从“知著”、“显微”、“晓义”三个层面阐述科学的大 数据观。 2.大数据技术平台与架构4学时 2.1云计算技术与开源平台搭建 2.2Hadoop、Spark等数据架构、计算范式与应用实践 3.机器学习与常用数据挖掘4学时 3.1常用机器学习算法:Bayes,SVM,最大熵、深度神经网络等; 3.2常用数据挖掘技术:关联规则挖掘、分类、聚类、奇异点分析。 4.大数据语义精准搜索4学时 4.1.通用搜索引擎与大数据垂直业务的矛盾; 4.2.大数据精准搜索的基本技术:快速增量在线倒排索引、结构化与非机构化数 据融合、大数据排序算法、语义关联、自动缓存与优化机制; 4.3.大数据精准搜索语法:邻近搜索、复合搜索、情感搜索、精准搜索; 4.4.JZSearch大数据精准搜索应用案例:国家电网、中国邮政搜索、国家标准搜 索、维吾尔语搜索、内网文档搜索、舆情搜索; 5.非结构化大数据语义挖掘10学时 5.1.语义理解基础:ICTCLAS与汉语分词 5.2.内容关键语义自动标引与词云自动生成; 5.3.大数据聚类; 5.4.大数据分类与信息过滤; 5.5.大数据去重、自动摘要; 5.6.情感分析与情绪计算;

大数据应用分析案例分析

大数据应用分析案例分 析 Company Document number:WTUT-WT88Y-W8BBGB-BWYTT-19998

大数据应用与案例分析 当下,”大数据”几乎是每个IT人都在谈论的一个词汇,不单单是时代发展的趋势,也是革命技术的创新。大数据对于行业的用户也越来越重要。掌握了核心数据,不单单可以进行智能化的决策,还可以在竞争激烈的行业当中脱颖而出,所以对于大数据的战略布局让越来越多的企业引起了重视,并重新定义了自己的在行业的核心竞争。 在当前的互联网领域,大数据的应用已十分广泛,尤其以企业为主,企业成为大数据应用的主体。大数据真能改变企业的运作方式吗答案毋庸置疑是肯定的。随着企业开始利用大数据,我们每天都会看到大数据新的奇妙的应用,帮助人们真正从中获益。大数据的应用已广泛深入我们生活的方方面面,涵盖医疗、交通、金融、教育、体育、零售等各行各业。 大数据应用的关键,也是其必要条件,就在于"IT"与"经营"的融合,当然,这里的经营的内涵可以非常广泛,小至一个零售门店的经营,大至一个城市的经营。以下是关于各行各业,不同的组织机构在大数据方面的应用的案例,并在此基础上作简单的梳理和分类。 一、大数据应用案例之:医疗行业 SetonHealthcare是采用IBM最新沃森技术医疗保健内容分析预测的首个客户。该技术允许企业找到大量病人相关的临床医疗信息,通过大数据处理,更好地分析病人的信息。在加拿大多伦多的一家医院,针对早产婴儿,每秒钟有超过3000次的数据读取。通过这些数据分析,医院能够提前知道哪些早产儿出现问题并且有针对性地采取措施,避免早产婴儿夭折。

实验数据的处理分析

实验数据的处理分析

实验数据的处理方法 杨鹏 【摘要】物理学是一门实验的科学,物理学中的新概念、新规律的发现都依赖于反复的实验。而处理实验数据时,需选择适当的实验数据处理方法,才能较准确、客观的反映实验结果,减小误差。本文介绍了实验数据处理中涉及到的一些基本概念,重点综述了物理实验中常用的数据处理方法。并指出了各自适用的条件及优缺点。 【关键词】误差;数据处理;作图法;最小二乘法;逐差法 Abstract:Physics is an experimental science, New concepts in physics, the discovery of new rules rely on trial and error, The experimental data processing,Need to select the appropriate treatment of the experimental data,To more accurately reflect the objective results,Reduce errors. This article describes the experimental data processing involved in some of the basic concepts Summary of experiments focused on the physical data processing methods commonly used. And pointed out the advantages and disadvantages of each applicable condition. Keywords:Error; Data Processing;Mapping;Least squares;By subtraction 【引言】数据处理是指由实验测得的数据, 必须经过科学的分析和处理, 才能揭示出各物理量之间的关系。我们把从获得原始数据起到得出结论为止的加工过程称为数据处理。正确的处理实验记录的数据,对我们科学的了解被测量或研究对象的客观规律,选择恰当的实验数据处理方法,最大限度的减小误差让实验数据无限接近理想条件下的结果,这是实验数据处理的意义所在。在这方面研究的文献有很多,例如费业泰的《误差理论与数据处理》等。要对实验结果进行分析,根据不同的实验方法,我们可以采用不同的数据处理方法,常用

大数据分析的应用和产品

大数据分析的应用和产品 大数据很火。2月18日,微软宣布投资三家中国云计算和大数据公司。2月19日,IBM宣布将与AT&T在大数据分析领域展开合作——AT&T计划贡献出一个全球可访问的移动网络,用来收集数据并将其发送至应用程序;IBM公司则主要致力于生产用于数据管理和分析的软件。 “读心术”、“未卜先知”,都是大数据分析头上的耀眼光环。不管你信不信,“数据”真的会说话。人们在互联网上的一切行为都会留下数据,而通过对这些数据的分析,就能够得到消费习惯、职业、喜好甚至性格等信息。在这些信息的基础上,政府可以治理交通,减少犯罪率,而企业则可以利用这些数据进行有针对性的营销,提升业绩。 虽然目前大数据分析还处于发展的初级阶段,要从海量的非结构性数据中提取出有用信息并不是一件容易的事儿,但是很多企业已经开始利用大数据分析并推出了相关的应用和产品。大数据分析究竟能做什么?大数据分析又正在做什么?让我们一起来看看吧! 洞察“人类大迁徙” “春运”,被誉为人类历史上规模最大、有周期性的人类大迁徙。过去,我们只是粗略地知道在40天左右的时间里,有几十亿人次的人口流动。现在,随着大数据时代的到来,我们可以描绘出能够揭露更多细节的“迁徙地图”。 2014年的春运,央视首次推出了“据说春运”特别节目,基于“百度迁徙”提供的可视化大数据服务,实时播报国内春节人口的迁徙情况,例如最热门的迁出城市,最热门的迁入城市等等。尽管采用的是大数据这一当前最时髦的科技手段,但浅显易懂的“迁徙地图”,还是几乎让每个老百姓都看得明白。 那么,这张“迁徙地图”是如何绘制的呢?原理上其实并不复杂。目前,几乎每个中国人都拥有一部手机,而每部手机每一天基本上都会产生3次与位置相关的数据:既包括来自基站的数据,也包括用户在使用定位、导航等与位置相关服务时产生的数据。因此,只要调

实验数据的处理分析

实验数据的处理方法 杨鹏 【摘要】物理学是一门实验的科学,物理学中的新概念、新规律的发现都依赖于反复的实验。而处理实验数据时,需选择适当的实验数据处理方法,才能较准确、客观的反映实验结果,减小误差。本文介绍了实验数据处理中涉及到的一些基本概念,重点综述了物理实验中常用的数据处理方法。并指出了各自适用的条件及优缺点。 【关键词】误差;数据处理;作图法;最小二乘法;逐差法 Abstract:Physics is an experimental science, New concepts in physics, the discovery of new rules rely on trial and error, The experimental data processing,Need to select the appropriate treatment of the experimental data,To more accurately reflect the objective results,Reduce errors. This article describes the experimental data processing involved in some of the basic concepts Summary of experiments focused on the physical data processing methods commonly used. And pointed out the advantages and disadvantages of each applicable condition. Keywords:Error; Data Processing;Mapping;Least squares;By subtraction 【引言】数据处理是指由实验测得的数据, 必须经过科学的分析和处理, 才能揭示出各物理量之间的关系。我们把从获得原始数据起到得出结论为止的加工过程称为数据处理。正确的处理实验记录的数据,对我们科学的了解被测量或研究对象的客观规律,选择恰当的实验数据处理方法,最大限度的减小误差让实验数据无限接近理想条件下的结果,这是实验数据处理的意义所在。在这方面研究的文献有很多,例如费业泰的《误差理论与数据处理》等。要对实验结果进行分析,根据不同的实验方法,我们可以采用不同的数据处理方法,常用的有作图法、最

大数据分析与应用

《应用统计学系列教材·大数据分析:方法与应用》可用做统计学、管理学、计算机科学等专业进行数据挖掘、机器学习、人工智能等相关课程的本科高年级、研究生教材或教学参考书。 目录 第1章大数据分析概述 1.1大数据概述 1.1.1什么是大数据 1.1.2数据、信息与认知 1.1.3数据管理与数据库 1.1.4数据仓库 1.1.5数据挖掘的内涵和基本特征1.2数据挖掘的产生与功能 1.2.1数据挖掘的历史 1.2.2数据挖掘的功能 1.3数据挖掘与相关领域之间的关系1.3.1数据挖掘与机器学习 1.3.2数据挖掘与数据仓库 1.3.3数据挖掘与统计学 1.3.4数据挖掘与智能决策 1.3.5数据挖掘与云计算 1.4大数据研究方法 1.5讨论题目 1.6推荐阅读 第2章数据挖掘流程 2.1数据挖掘流程概述 2.1.1问题识别 2.1.2数据理解 2.1.3数据准备 2.1.4建立模型 2.1.5模型评价 2.1.6部署应用 2.2离群点发现 2.2.1基于统计的离群点检测 2.2.2基于距离的离群点检测 2.2.3局部离群点算法 2.3不平衡数据级联算法 2.4讨论题目 2.5推荐阅读 第3章有指导的学习 3.1有指导的学习概述3.2K—近邻 3.3决策树 3.3.1决策树的基本概念 3.3.2分类回归树 3.3.3决策树的剪枝 3.4提升方法 3.5随机森林树 3.5.1随机森林树算法的定义 3.5.2如何确定随机森林树算法中树的节点分裂变量 3.5.3随机森林树的回归算法 3.6人工神经网络 3.6.1人工神经网络基本概念 3.6.2感知器算法 3.6.3LMS算法 3.6.4反向传播算法 3.6.5神经网络相关问题讨论 3.7支持向量机 3.7.1最大边距分类 3.7.2支持向量机问题的求解 3.7.3支持向量机的核方法 3.8多元自适应回归样条 3.9讨论题目 3.10推荐阅读 第4章无指导的学习 4.1关联规则 4.1.1静态关联规则算法Apriori算法 4.1.2动态关联规则算法Carma算法 4.1.3序列规则挖掘算法 4.2聚类分析 4.2.1聚类分析的含义及作用 4.2.2距离的定义 4.2.3系统层次聚类法 4.2.4K—均值算法 4.2.5BIRCH算法 4.2.6基于密度的聚类算法 4.3基于预测强度的聚类方法 4.3.1预测强度 4.3.2预测强度方法的应用 4.3.3案例分析 4.4聚类问题的变量选择 4.4.1高斯成对罚模型聚类

分析化学中的误差及数据处理(精)

第三章 分析化学中的误差及数据处理 本章基本要求: 1 掌握误差和偏差的基本概念、准确度与精密度的概念和衡量其大小的方式;了解误差的分类、特点、产生的原因及其减免测定误差的措施。了解准确度与精密度之间的关系和它们在实际工作中的应用。 2 掌握有效数字的概念、有效数字在分析测定中的应用规则、可疑数据的取舍和有效数字的运算规则。 3 掌握平均值的置信区间的概念和计算;掌握t 检验法、F 检验法以及Q 检验法的应用;了解随机误差的分布特征—正态分布。 4 掌握通过选择合适的分析方法、用标准样品对照、减小测量误差和随机误差、消除系统误差等提高分析结果准确度的方法。 分析人员用同一种方法对同一个试样进行多次分析,即使分析人员技术相当熟练,仪器设备很先进,也不可能做到每一次分析结果完全相同,所以在分析中往往要平行测定多次,然后取平均值代表分析结果,但是平均值同真实值之间还可能存在差异,因此分析中误差是不可避免的。 §3.1 分析化学中的误差 一 真值(x T ) 某一物理量本身具有的客观存在的真实值。真值是未知的、客观存在的量。在特定情况下认为是已知的: 1 理论真值(如某化合物的理论组成,例:纯NaCl 中Cl 的含量) 2 计量学约定真值(如国际计量大会确定的长度、质量、物质的量单位如米、千克等;标准参考物质证书上给出的数值;有经验的人用可靠方法多次测定的平均值,确认消除了系统误差。) 3 相对真值(如认定精确度高一个数量级的测定值作为低一级测量值的真值。(如标准试样(在仪器分析中常常用到)的含量) 二 平均值(x ) 12...n x x x x n +++= 强调:n 次测量值的算术平均值虽不是真值,但比单次测量结果更接近真值,是对真值的最佳估计,它表示一组测定数据的集中趋势。 三 中位数 (x M ) 一组测量数据按大小顺序排列,中间一个数据即为中位数XM,当测量值的个数位数时,中位数为中间相临两个测量值的平均值。 例1. 小 10.10,10.20,10.40,10.46,10.50 大 x =10.33 x M =10.40 例2. 10.10,10.20,10.40,10.46,10.50,10.54 x =10.37 x M =10.43 它的优点是能简单直观说明一组测量数据的结果,且不受两端具有过大误差数据的影响。例3:当有异常值时, 10.10,10.20,10.40,10.46,10.50,12.80 x M =10.43 x =10.74

分析化学中的误差与数据处理(精)

第3章分析化学中的误差与数据处理 一、选择题 1.下列叙述错误的是() A.误差是以真值为标准的,偏差是以平均值为标准的,实际工作中获得的所谓“误差”,实质上仍是偏差 B.对某项测定来说,它的系统误差大小是不可测量的 C.对偶然误差来说,大小相近的正误差和负误差出现的机会是均等的 D.标准偏差是用数理统计方法处理测定的数据而获得的 2.四位学生进行水泥熟料中SiO2 , CaO, MgO, Fe2O3 ,Al2O3的测定。下列结果(均为百分含量)表示合理的是() A.21.84 , 65.5 , 0.91 , 5.35 , 5.48 B.21.84 , 65.50 , 0.910 , 5.35 , 5.48 C.21.84 , 65.50 , 0.9100, 5.350 , 5.480 D.21.84 , 65.50 , 0.91 , 5.35, 5.48 3.准确度和精密度的正确关系是() A.准确度不高,精密度一定不会高B.准确度高,要求精密度也高 C.精密度高,准确度一定高D.两者没有关系 4.下列说法正确的是() A.精密度高,准确度也一定高B.准确度高,系统误差一定小 C.增加测定次数,不一定能提高精密度D.偶然误差大,精密度不一定差 5.以下是有关系统误差叙述,错误的是() A.误差可以估计其大小B.误差是可以测定的 C.在同一条件下重复测定中,正负误差出现的机会相等D.它对分析结果影响比较恒定6.滴定终点与化学计量点不一致,会产生() A.系统误差B.试剂误差C.仪器误差D.偶然误差 7.下列误差中,属于偶然误差的是() A.砝码未经校正B.容量瓶和移液管不配套 C.读取滴定管读数时,最后一位数字估计不准D.重量分析中,沉淀的溶解损失8.可用于减少测定过程中的偶然误差的方法是() A.进行对照试验B.进行空白试验C.进行仪器校准D.增加平行试验的次数9.下列有效数字位数错误的是() A.[H+]=6.3×10-12mol/L (二位) B.pH=11.20(四位) C.CHCl=0.02502mol/L (四位) D.2.1 (二位) 10.由计算器算得9.250.21334 1.200100 ? ? 的结果为0.0164449。按有效数字运算规则将结果修约 为() A.0.016445B.0.01645C.0.01644D.0.0164 11.下列有关随机误差的叙述中不正确的是() A.随机误差在分析中是不可避免的B.随机误差出现正误差和负误差的机会是均等的C.随机误差具有单向性D.随机误差是由一些不确定的偶然因素造成的 12.指出下列表述中错误的表述() A.置信水平愈高,测定的可靠性愈高B.置信水平愈高,置信区间愈宽 C.置信区间的大小与测定次数的平方根成反比D.置信区间的位置取决于测定的平均值13.在分析工作中要减小测定的偶然误差可采取()方法

- 大数据处理技术的总结与分析

- 简析大数据及其处理分析流程知识讲解

- 大数据处理及分析理论方法技术

- 大数据分析与处理方法解读

- 大数据处理分析的六大最好工具

- 大数据处理和分析

- 简析大数据及其处理分析流程

- 如何进行大数据分析及处理 - 51Testing

- 大数据分析技术架构解决方案

- 大数据的处理和分析

- 大数据处理框架选型分析

- 大数据处理技术的总结与分析

- 大数据处理技术的总结与分析

- 大数据数据分析方法数据处理流程实战案例样本

- 智慧树知道网课《大数据处理和分析》课后章节测试满分答案

- 大数据分析与处理中的关键科学问题

- 大数据分析技术架构解决方案

- 大数据分析与处理

- 大数据的处理与分析

- 大数据处理分析的六大最好工具