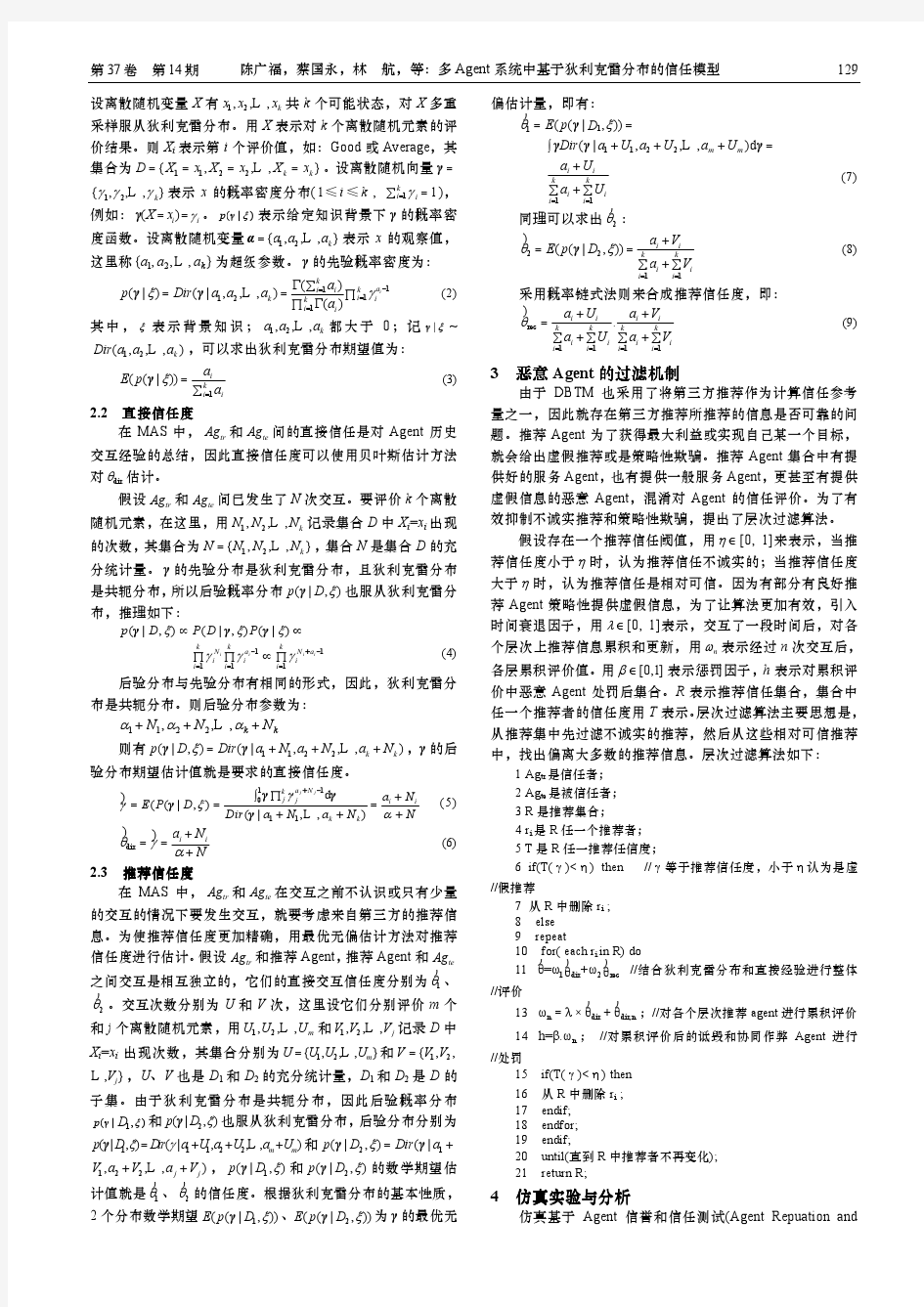

多Agent系统中基于狄利克雷分布的信任模型

LDA模型

LDA(主题模型)算法 &&概念: 首先引入主题模型(Topic Model)。何谓“主题”呢?望文生义就知道是什么意思了,就是诸如一篇文章、一段话、一个句子所表达的中心思想。不过从统计模型的角度来说,我们是用一个特定的词频分布来刻画主题的,并认为一篇文章、一段话、一个句子是从一个概率模型中生成的。 LDA可以用来识别大规模文档集(document collection)或语料库(corpus)中潜藏的主题信息。它采用了词袋(bag of words)的方法,这种方法将每一篇文档视为一个词频向量,从而将文本信息转化为易于建模的数字信息。 LDA(Latent Dirichlet Allocation)是一种文档主题生成模型,也称为一个三层贝叶斯概率模型,包含词、主题和文档三层结构。所谓生 注:每一篇文档代表了一些主题所构成的一个概率分布,而每一个主题又代表了很多单词所构成的一个概率分布。 备注: 流程(概率分布):→→ 许多(单)词某些主题一篇文档 /**解释:LDA生成过程 *对于语料库中的每篇文档,LDA定义了如下生成过程(generativeprocess): *1.对每一篇文档,从主题分布中抽取一个主题; *2.从上述被抽到的主题所对应的单词分布中抽取一个单词; *3.重复上述过程直至遍历文档中的每一个单词。 **/ 把各个主题z在文档d中出现的概率分布称之为主题分布,且是一个多项分布。把各个词语w在主题z下出现的概率分布称之为词分布,这个词分布也是一个多项分布。

&&深入学习: 理解LDA,可以分为下述5个步骤: 1.一个函数:gamma函数 2.四个分布:二项分布、多项分布、beta分布、Dirichlet分布 3.一个概念和一个理念:共轭先验和贝叶斯框架 4.两个模型:pLSA、LDA(在本文第4 部分阐述) 5.一个采样:Gibbs采样 本文便按照上述5个步骤来阐述,希望读者看完本文后,能对LDA有个尽量清晰完整的了解。同时,本文基于邹博讲LDA的PPT、rickjin的LDA数学八卦及其它参考资料写就,可以定义为一篇学习笔记或课程笔记,当然,后续不断加入了很多自己的理解。若有任何问题,欢迎随时于本文评论下指出,thanks。 1 gamma函数 整体把握LDA 关于LDA有两种含义,一种是线性判别分析(Linear Discriminant Analysis),一种是概率主题模型:隐含狄利克雷分布(Latent Dirichlet Allocation,简称LDA),本文讲后者(前者会在后面的博客中阐述)。 另外,我先简单说下LDA的整体思想,不然我怕你看了半天,铺了太长的前奏,却依然因没见到LDA的影子而显得“心浮气躁”,导致不想再继续看下去。所以,先给你吃一颗定心丸,明白整体框架后,咱们再一步步抽丝剥茧,展开来论述。 按照wiki上的介绍,LDA由Blei, David M.、Ng, Andrew Y.、Jordan于2003年提出,是一种主题模型,它可以将文档集中每篇文档的主题以概率分布的形式给出,从而通过分析一些文档抽取出它们的主题(分布)出来后,便可以根据主题(分布)进行主题聚类或文本分类。同时,它是一种典型的词袋模型,即一篇文档是由一组词构成,词与词之间没有先后顺序的关系。此外,一篇文档可以包含多个主题,文档中每一个词都由其中的一个主题生成。 LDA的这三位作者在原始论文中给了一个简单的例子。比如假设事先给定了这几个主题:Arts、Budgets、Children、Education,然后通过学习的方式,获取每个主题Topic对应的词语。如下图所示:

通俗理解LDA主题模型

通俗理解LDA主题模型 0 前言 印象中,最开始听说“LDA”这个名词,是缘于rickjin在2013年3月写的一个LDA科普系列,叫LDA数学八卦,我当时一直想看来着,记得还打印过一次,但不知是因为这篇文档的前序铺垫太长(现在才意识到这些“铺垫”都是深刻理解LDA 的基础,但如果没有人帮助初学者提纲挈领、把握主次、理清思路,则很容易陷入LDA的细枝末节之中),还是因为其中的数学推导细节太多,导致一直没有完整看完过。 2013年12月,在我组织的Machine Learning读书会第8期上,@夏粉_百度讲机器学习中排序学习的理论和算法研究,@沈醉2011 则讲主题模型的理解。又一次碰到了主题模型,当时貌似只记得沈博讲了一个汪峰写歌词的例子,依然没有理解LDA到底是怎样一个东西(但理解了LDA之后,再看沈博主题模型的PPT会很赞)。 直到昨日下午,机器学习班第12次课上,邹讲完LDA之后,才真正明白LDA原来是那么一个东东!上完课后,趁热打铁,再次看LDA数学八卦,发现以前看不下去的文档再看时竟然一路都比较顺畅,一口气看完大部。看完大部后,思路清晰了,知道理解LDA,可以分为下述5个步骤: 1. 一个函数:gamma函数 2. 四个分布:二项分布、多项分布、beta分布、Dirichlet分布 3. 一个概念和一个理念:共轭先验和贝叶斯框架 4. 两个模型:pLSA、LDA(在本文第4 部分阐述) 5. 一个采样:Gibbs采样 本文便按照上述5个步骤来阐述,希望读者看完本文后,能对LDA有个尽量清晰完整 可以定义为一篇学习笔记或课程笔记,当然,后续不断加入了很多自己的理解。若有任何问题,欢迎随时于本文评论下指出,thanks。

基于Labeled-LDA模型的文本分类新算法

第第第第第第第第第 第第第第第第第第第

Labeled模型的文本分类新 基于 Labeled-LDA 模型的文本分类新算法

李文波 1,2,孙乐 1,黄瑞红 1,冯元勇 1,张大鲲 1

(1.中第科第院软件研究所,北京 100080;2.中第科第院研究生院,北京 100049)

摘 要:

隐含狄利克雷分配(LDA,Latent Dirichlet Allocation)模型是近年来提出的一种具有表示文本

主题能力的非监督第习模型。本文提出了一种附加类别标签的 LDA 模型(Labeled-LDA) ,通过在传统 LDA 模型中融入文本类别第第,提高了该模型的表示能力。基于 Labeled-LDA 模型可以计算出隐含主题在各类别 上的分配量,从而克服了传统 LDA 模型用于分类时强制分配隐含主题的缺陷。第传统 LDA 模型的实验对比 表明,基于 Labeled-LDA 模型的文本分类新算法可以有效改进文本分类的性能:在复旦中文语料库上 micro_F1 提高约 5.7%,在英文语料库 20newsgroup 的 comp 子集上 micro_F1 提高约 3%。 关键词: 关键词: 文本分类;图模型;隐含狄利克雷分配;变分推断

Text Classification Based on Labeled-LDA Model

Li Wenbo1,2, Sun Le1, Huang Ruihong1, Feng Yuanyong1, Zhang Dakun1

(1. Institute of Software, CAS, Beijing 100080; 2. Graduate School of the CAS, Beijing 100049)

Abstract:

Latent Dirichlet Allocation(LDA) is an unsupervised model which exhibits superiority on latent topic

modeling of text data in the research of recent years. In this paper, an improved LDA model, named as Labeled-LDA, is proposed to enhance the traditional LDA to integrate the class information. Based on Labeled-LDA, a new algorithm is introduced to figure out the latent topics’ quantities assigned to each class. In such a way, Labeled-LDA model avoids compulsive latent topic allocation of the traditional LDA when it is used as a component in classification model. Experiments on fudan corpus and the comp subset of 20newsgrop corpus show our method can improve text classification effectiveness: we get an improvement of 5.7% according to micro_F1 measure on fudan corpus and 3% on the comp sutset of 20newsgrop corpus. key words: text classification; graphical model; Latent Dirichlet Allocation(LDA); variational inference

1

引言

随着第第技第的发展,各类第第资源的存量和增长都呈现海量特征,其中文本数据在始终占据 重要地位。人们对有效地管理和使用这些的文本第第存在巨大需求, 这促进了自动文本分类技第的 迅速发展和广泛应用[1][2]。 近年来,文本分类的研究中大量工作是集中在分类模型方面,基本上是引入和改进机器第习领 域的相关成果[3]。关于文本表示的研究相对较少,绝大多数的研究是直接基于词袋(BOW, Bag Of Words)表示以及引入第第第第中加权方法,如 tf*idf 及其变体。第第第第中各种改进的文本表示方法 也被移植到文本分类中,这些方法主要是通过语言第方法和统计方法两种途径对文本表示方法进行 拓展。在语言第方面,人们作了一些尝试[4][5],力图通过引入丰富的语言第特征提高分类的性能,但

基金资助:第家 242 计划项目(2006C41) 作者简介:李文波(1975-) ,男,第蒙古,博士生 email: liwenbo02@https://www.wendangku.net/doc/e716220084.html,

1

置 信 区 间 一 文 读 懂

Nature综述:Rob Knight带你分析微生物组数据(2020版) 微生物组分析最佳实践 Best practices for analysing microbiomes Impact Factor:34.648 发表日期:2018-05-23 中文版更新时间:2018-03-30 主要单位: 1美国加州大学圣地亚哥分校微生物组创新中心,美国加利福尼亚(Center for Microbiome Innovation, University of California San Diego, La Jolla, CA, USA) 2美国加州大学圣地亚哥分校生物医学科学研究生课-程(Biomedical Sciences Graduate Program, University of California San Diego, La Jolla, CA, USA) 4美国加州大学圣地亚哥分校医学院儿科(Department of Pediatrics, School of Medicine, University of California San Diego, La Jolla, CA, USA) 6美国加州大学圣地亚哥分校计算机科学与工程系(Department of Computer Science and Engineering, University of California San Diego, La Jolla, CA, USA)

自然微生物综述(2018 IF:34.648)于2018年5月23日在线发表了Rob Knight亲自撰写(一作兼通讯)的微生物组领域分析方法综述,不到两年引用高达270次,不仅系统总结了过去,更为未来3-5年内本领域分析方法的选择,提供了清晰的技术路线,让大家走干道,少跳坑,发现更可信的生物学规律,做出更好的研究。值得本领域专业人士细心品读。 摘要Abstract 背景介绍Introduction 无论是哺乳动物肠道还是深海沉积物,DNA测序技术的快速发展改变了我们对各类复杂生境中微生物群落组成和动态变化的认识。这些技术上的发展推动从临床研究到生物技术等科学领域微生物组研究数量的激增。与之而来的是研究人员留下的大量实验数据,并使用一系列令人眼花缭乱的计算工具和方法进行分析。和其他研究一样,在微生物组研究中,扎实的实验是至关重要的,实验方法、环境因素和分析都会影响最终结果。虽然本领域当前研究获得了很多引人注目的成果,但仍然缺少数据收集和分析方法的标准。 微生物组分析方法和标准正经历快速发展。特别是过去的两年中,使用精确序列变异来替代OTU(16S测序,不知道OTU你就out了! )分析进行差异丰度检测,以及相关性分析发展迅速。可以预期,在宏基因组分类和功能方面(Cell:20种宏基因组学物种分类工具大比拼)、从多批数据的整合、进一步改善机器学习(深度学习肠道菌群揭示你的真实年龄)、组成型数据分析以及多种组学分析(Nature Protocols:整合宏基因组、代谢组和表型分析的的计算框架)等其他领域,也有类似的进展。然而,很多

基于狄利克雷DirichletProcesses聚类的协同过滤推荐算法实现(输出聚类计算过程,分布图展示)

基于狄利克雷DirichletProcesses聚类的协同过滤推荐算法代码实现(输出聚类计算 过程,分布图展示) 聚类(Clustering)就是将数据对象分组成为多个类或者簇(Cluster),它的目标是:在同一个簇中的对象之间具有较高的相似度,而不同簇中的对象差别较大。所以,在很多应用中,一个簇中的数据对象可以被作为一个整体来对待,从而减少计算量或者提高计算质量。 一、DirichletProcesses聚类算法实现原理 狄利克雷聚类(Dirichlet Processes Clustering)是一种基于概率分布模型的聚类算法。 首先我们先简要介绍一下基于概率分布模型的聚类算法(后面简称基于模型的聚类算法)的原理:首先需要定义一个分布模型,简单的例如:圆形,三角形等,复杂的例如正则分布,泊松分布等;然后按照模型对数据进行分类,将不同的对象加入一个模型,模型会增长或者收缩;每一轮过后需要对模型的各个参数进行重新计算,同时估计对象属于这个模型的概率。所以说,基于模型的聚类算法的核心是定义模型,对于一个聚类问题,模型定义的优劣直接影响了聚类的结果,下面给出一个简单的例子,假设我们的问题是将一些二维的点分成三组,在图中用不同的颜色表示,图 A 是采用圆形模型的聚类结果,图 B 是采用三角形模型的聚类结果。可以看出,圆形模型是一个正确的选择,而三

角形模型的结果既有遗漏又有误判,是一个错误的选择。 狄利克雷聚类算法是按照如下过程工作的:首先,我们有一组待聚类的对象和一个分布模型。使用 ModelDistribution 生成各种模型。初始状态,我们有一个空的模型,然后尝试将对象加入模型中,然后一步一步计算各个对象属于各个模型的概率。 本文主要是java语言实现,1000个点(本文是二维向量,也可以是多维,实现原理和程序一样),程序运行过程中会输出每一次遍历点的簇中心,和簇中包含的点,并将最终结果通过插件在html中显示。 二、DirichletProcesses聚类算法实现部分步骤 将本地文件读取到点集合中: