属性分布相似度吸引子传播聚类算法研究_王依章

收稿日期:2014-01-

25 基金项目:

国家自然科学基金资助项目(61202306);吉林省科技厅基金资助项目(20100507,201215119,20130522177JH);吉林省教育厅重点规划项目(2012185);吉林省高校新世纪优秀人才支持计划项目(2014159)

;吉林财经大学青年学俊支持计划项目

作者简介:王依章(

1990-),男,汉族,江苏徐州人,吉林财经大学硕士研究生,主要从事数据挖掘和智能计算方向研究,E-mail:755378766@qq

.com.*通讯作者:王丽敏(1975-),女,汉族,吉林梨树人,吉林财经大学教授,博士,主要从事机器学习、数据挖掘、金融工程方向研究,E-m

ail:wlm_new@163.com.第35卷第3期 长春工业大学学报(自然科学版) V

ol.35No.32014年06月 Journal of Changchun University

of Technology(Natural Science Edition) Jun.2014属性分布相似度吸引子传播聚类算法研究

王依章1, 王丽敏1*, 韩旭明

2

(1.

吉林财经大学管理科学与信息工程学院,吉林长春 130117;2.长春工业大学软件学院,吉林长春 130012

)摘 要:传统吸引子传播聚类算法对数据类型敏感,文中提出一种改进的吸引子传播聚类算法,将JACCARD系数引入对象间属性分布相似度,并与吸引子传播聚类算法结合。仿真实验结果表明,该算法收敛速度快,聚类精度高,明显提高高维稀疏数据的聚类性能。关键词:吸引子传播聚类算法;J

ACCARD系数;属性分布相似度中图分类号:TP

301 文献标志码:A 文章编号:1674-1374(2014)03-0271-04A properties distribution similarity-basedaffinity

propagation algorithmWANG Yi-zhang1, WANG Li-min1*, HAN Xu-ming

2

(1.School of Management Science and Information Engineering,Jilin University

of Finance and Economics,Changchun 130117,China;2.School of Software,Changchun University

of Technology,Changchun 130012,China)Abstract:The traditional affinity propagation algorithm is sensitive to the type of data.Here wepropose an improved affinity propagation algorithm which is based on property distribution similarity.JACCARD is introduced into property distribution similarity,and combined with affinity propagationclustering

algorithm.Simulation results show that the method is with high precision and fastconvergence,and can improve the clustering properties of high-dimensional sparse data.Key

words:affinity propagation;JACCARD;properties distribution similarity.0 引 言

吸引子传播聚类算法是美国学者Frey2007年在《S

cience》杂志上提出的一种新聚类算法。目前,该算法已成功应用于图像分割[1-

2]、图像检索[

3]、基因识别[4]、文本聚类[5]

、最优航空路线确定[6]

等诸多领域。近年来,国内外学者提出多种改进方法。例如国外学者Bruzzone

L[7]

等提出吸DOI:10.15923/https://www.wendangku.net/doc/7911847307.html,22-1382/t.2014.03.027

引子传播算法应用于多光谱图像领域,Qasim

I[8]等把该算法应用在文本概念图自动生成领域,取

得了显著的应用效果。国内学者于吉红[

9]

等提出用空间向量模型计算特征相似度,并应用于舰船

三维模型进行视点空间均匀投影。张震[

10]

等提出将吸引子传播算法与数据流聚类相结合,改良了数据流聚类模型。文中根据属性间分布相似度提出改进算法,提高对高维稀疏数据的聚类性能,并应用于超市销售数据聚类。

1 吸引子传播聚类算法

吸引子传播聚类算法利用数据点之间的相似

度构造相似度关系矩阵S[

11]

。相似度是两点间距离的相反数[

12]

。s(i,k)=-‖xi-xk‖

(1) 相似度矩阵对角线的中值就是偏向参数

P[1

3

]

。该算法初始假设每个样本点成为类代表的可能性相同,同时引入归属度矩阵和吸引度矩阵共同决定每一个样本的类代表点,计算方法如下:

a(i,k)=min 0,r(k,k)+∑

i′

s.t.i′

∈(i,k)

max{0,r(i′

,k{}

)}, i≠k∑

i′s.t.i

′

∈(

i,k)max{0,r(i′

,k)},

i=烅

烄烆k(2

)r(i,k)=s(i,k)-

maxi′

s.t.i′

∈(i,k)

{a(i,k′)+s

(i,k′

)}(3

) 吸引子传播聚类算法利用下式计算归属度

a(i,k)和吸引度r(i,k)

之和,获取每个样本的类代表点[

14]

:arg

max(a(i,k) k

,r(i,k))(4

) 利用以下公式增强算法迭代的稳定性[15]

:

r(i,k)(t+1)=λr(i,k)t+(

1-λ)r(i,k)(t-1)(5

)a(i,k)(t+1)=λa(i,k)t+(

1-λ)a(i,k)(t-1)(6

)2 基于属性分布相似度的吸引子传播聚

类算法

文中提出基于属性分布相似度的吸引子传播聚类算法,构造新相似度矩阵。在高维二元数据中,假设X是数据对象集合,X={Xi|i=1,2…,D},A是属性集合,A={Ai|i=1,2…,D},Y={Yij|i=1,2…,D}表示对象在各属性分布上的取值分布情况,是i个对象的属性分布特征向量。如果Yij=1,表明第i个对象在第j个属性上有值,否则稀疏。数据对象间相似度:

d(X1,X2)=

|{Aj|Yip=Yqj}|D

(7

) 高维稀疏情形下,

每个对象在属性取值上存在大量零值,有取值的属性数占总属性数的比例很小。改进方法如下式:

d(X1,X2)=

|Ap∩Aq||Ap∪Aq|

(8

) 将式(

8)计算的相似度矩阵引入吸引子传播算法,取代欧式距离矩阵。在实际应用中可以给相似度加上权重系数,当维度较高时,权重系数越接近1,可以发现更多有意义的相似对象,如下式:

dp(

X1X2)=wid(X1,X2) wi∈[

0,1](9

)3 仿真模拟实验与分析

仿真模拟实验环境是P

entium G6452.9GHz CPU,4GB内存。实验采用UCI二元数据集,真实类数为2类,参数λ=0.5,

调整偏向参数P值,

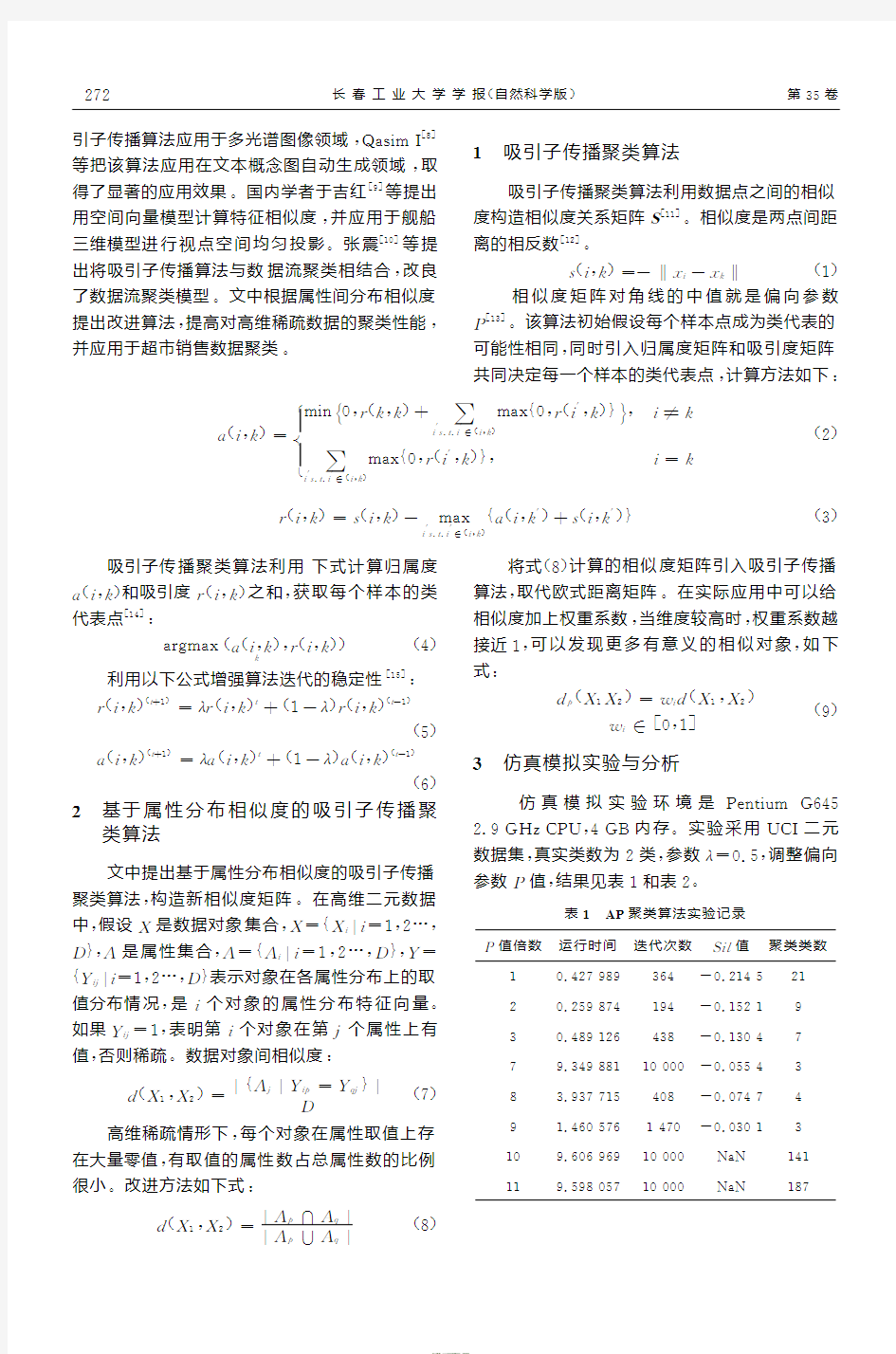

结果见表1和表2。表1 AP聚类算法实验记录

P值倍数

运行时间迭代次数Sil值聚类类数1 0.427 989 364-0.214 5 212 0.259 874 194-0.152 1 93 0.489 126

438

-0.130 4

77

9.349 881 10 000-0.055 4 38 3.937 715

408

-0.074 7 49 1.460 576 1 470-0.030 1 310 9.606 969 10 000NaN 14111

9.598 057 10

000NaN

187

272长春工业大学学报(自然科学版) 第3

5卷

表2 PDS-AP聚类算法实验记录

P值倍数运行时间迭代次数Sil值聚类类数1 0.190 873 95-0.220 2 13

2 9.515 731 10 000-0.092 6 7

3 0.175 436 87-0.082 7 5

7 0.179 438 90-0.056 7 3

11 0.188 092 101-0.004 9 2

14 0.208 857 122-0.004 9 2

表1和表2表明,AP聚类算法在λ值不变的

情况下,聚类类数逐渐减少,精度增高,最终稳定的聚类类数是3类,P值增大至某一点时发散,得不到数据集的真实类数。PDS-AP聚类算法在不同偏向参数下聚类性能均优于传统算法,并能够获取真实类数。

4 超市销售数据聚类应用

PDS-AP聚类算法应用在真实超市销售数据,数据来源于科研数据共享平台,数据总量共有741×41个数据点,超市销售数据见表3。

表3 超市销售数据

ID饮料冲饮食品乳制冲饮滋补保健品罐头食品即食主食中式挂面/通心粉24P0011002 0 0 0 0 0 0 0

3P0059002 1 1 0 0 0 0 0

124P0031005 0 0 0 0 0 0 0

123P0031005 0 0 0 0 0 0 0

122P0031005 0 0 0 0 0 0 0

121P0031005 1 0 0 0 0 0 0……………………

96P0031005 1 0 0 0 0 0 0

95P0031005 1 0 0 0 0 0 0

94P0031005 0 0 0 0 0 0 0

93P0031005 1 0 0 0 0 0 0

92P0031005 0 0 0 0 0 0 0

91P0031005 1 0 0 0 0 0 0

运行PDS-AP聚类算法,类数16,将对应的对象和其所属样本点放在一起,将增加客户的购买度和购物享受。如果有顾客特征资料,可以分析不同客户群的需求。

5 结 语

传统吸引子传播聚类算法的相似度矩阵基于欧式距离,对数据的类型具有选择性。为了克服此弊端,文中提出的基于属性分布相似度的PDS-AP聚类算法,经UCI标准数据集和真实数据的验证,与传统的AP聚类算法相比,聚类精度更高,收敛速度更快,更适合高维稀疏数据的聚类。PDS-AP聚类算法的实际应用也取得了满意结果,而面对聚类结构复杂的数据,还需结合群优化算法进一步研究。

参考文献:

[1] 许晓丽,卢志茂,张格森,等.改进近邻传播聚类的彩色图像分割[J].计算机辅助设计与图形学学报,2012,24(4):514-519.

[2] 齐美彬,朱俊俊,纪平,等.大规模图像集中的代表性图像选取[J].自动化学报,2014,40(4):706-712.[3] 杨传慧,吉根林,章志刚.基于分块加权颜色直方图的图像聚类算法研究[J].南京师范大学学报:工程

技术版,2013,13(1):42-43.

[4] 汤健,管云雁,刘文广,等.马氏珠母贝家系遗传结构的微卫星分析[J].Marine Sciences,2013,37(8):35.

[5] 文翰,肖南峰.基于强类别特征近邻传播的半监督

3

7

2

第3期 王依章,等:属性分布相似度吸引子传播聚类算法研究

文本聚类[J].模式识别与人工智能,2013(5):391.[6] 郑志敏,徐青.基于吸引子传播算法的城市航空便利性分析[J].硅谷,2013(9):72-73.

[7] Yang C,Bruzzone L,Guan R C,et al.Incrementaland decremental affinity propagation for semisuper-

vised clustering in multispectral mages[J].IEEE

Transactions on Geoscience and Remote Sensing,2013,51(3):1666-1679.

[8] Qasim I,Jeong J W,Heu J U,et al.Concept mapconstruction from text documents using affinity

propagation[J].Journal of Information Science,2013,39(1):7-14.

[9] 于吉红,白晓明,吕俊伟.改进相似度的吸引子传播聚类算法[J].小型微型计算机系统,2013,34(3):603-604.

[10] 张震,汪斌强,李向涛,等.基于近邻传播学习的半监督流量分类方法[J].自动化学报,2013,39(7):

1100-1109.

[11] Sakellariou A,Sanoudou D,Spyrou G.Combiningmultiple hypothesis testing and affinity propagation

clustering leadsto accurate,robust and sample size

independent classification on gene expression data

[J].BMC bioinformatics,2012,13(1):270.

[12] 张震,汪斌强,伊鹏,等.一种分层组合的半监督近邻传播聚类算法[J].电子与信息学报,2013,35

(3):645-651.

[13] Torrent-Fontbona F,Muoz V,Lopez B.Solvinglarge immobile location-allocation by affinity prop-

agation and simulated annealing application to se-

lect which sporting event to watch[J].Expert

Systems with Applications,2013,40(11):4593-

4599.

[14] Sattar F,Driessen P F.Non-stationary signalsseparation using STFT and affinity propagation

clustering algorithm[C]//Communications,Com-

puters and Signal Processing(PACRIM),2013

IEEE Pacific Rim Conference on.IEEE,2013:

389-394.

[15] Foster B,Bagci U,Luna B,et al.Robust seg-mentation and accurate target definition for posi-

tron emission tomography images using Affinity

Propagation[C]//Biomedical Imaging(ISBI),

2013IEEE 10th International Symposium on.

IEEE,2013:1461-1464.

4

7

2长春工业大学学报(自然科学版) 第35卷

PAM聚类算法的分析与实现

毕业论文(设计)论文(设计)题目:PAM聚类算法的分析与实现 系别: 专业: 学号: 姓名: 指导教师: 时间:

毕业论文(设计)开题报告 系别:计算机与信息科学系专业:网络工程 学号姓名高华荣 论文(设计)题目PAM聚类算法的分析与实现 命题来源□√教师命题□学生自主命题□教师课题 选题意义(不少于300字): 随着计算机技术、网络技术的迅猛发展与广泛应用,人们面临着日益增多的业务数据,这些数据中往往隐含了大量的不易被人们察觉的宝贵信息,为了得到这些信息,人们想尽了一切办法。数据挖掘技术就是在这种状况下应运而生了。而聚类知识发现是数据挖掘中的一项重要的内容。 在日常生活、生产和科研工作中,经常要对被研究的对象经行分类。而聚类分析就是研究和处理给定对象的分类常用的数学方法。聚类就是将数据对象分组成多个簇,同一个簇中的对象之间具有较高的相似性,而不同簇中的对象具有较大的差异性。 在目前的许多聚类算法中,PAM算法的优势在于:PAM算法比较健壮,对“噪声”和孤立点数据不敏感;由它发现的族与测试数据的输入顺序无关;能够处理不同类型的数据点。 研究综述(前人的研究现状及进展情况,不少于600字): PAM(Partitioning Around Medoid,围绕中心点的划分)算法是是划分算法中一种很重要的算法,有时也称为k-中心点算法,是指用中心点来代表一个簇。PAM算法最早由Kaufman和Rousseevw提出,Medoid的意思就是位于中心位置的对象。PAM算法的目的是对n个数据对象给出k个划分。PAM算法的基本思想:PAM算法的目的是对成员集合D中的N个数据对象给出k个划分,形成k个簇,在每个簇中随机选取1个成员设置为中心点,然后在每一步中,对输入数据集中目前还不是中心点的成员根据其与中心点的相异度或者距离进行逐个比较,看是否可能成为中心点。用簇中的非中心点到簇的中心点的所有距离之和来度量聚类效果,其中成员总是被分配到离自身最近的簇中,以此来提高聚类的质量。 由于PAM算法对小数据集非常有效,但对大的数据集合没有良好的可伸缩性,就出现了结合PAM的CLARA(Cluster LARger Application)算法。CLARA是基于k-中心点类型的算法,能处理更大的数据集合。CLARA先抽取数据集合的多个样本,然后用PAM方法在抽取的样本中寻找最佳的k个中心点,返回最好的聚类结果作为输出。后来又出现了CLARNS(Cluster Larger Application based upon RANdomized

数据挖掘聚类算法课程设计报告

数据挖掘聚类问题(Plants Data Set)实验报告 1.数据源描述 1.1数据特征 本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。数据集中总共有68个地区,主要分布在美国和加拿大。一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。 图1 数据格式 例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。 1.2任务要求 聚类。采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。 2.数据预处理 2.1数据清理 所给数据集中包含一些对聚类过程无用的冗余数据。数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。例如: ①abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ②abelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ③abelmoschus moschatus,hi,pr 上述数据中第①行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的②③两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集

实验三 K-均值聚类算法实验报告

实验三 K-Means聚类算法 一、实验目的 1) 加深对非监督学习的理解和认识 2) 掌握动态聚类方法K-Means 算法的设计方法 二、实验环境 1) 具有相关编程软件的PC机 三、实验原理 1) 非监督学习的理论基础 2) 动态聚类分析的思想和理论依据 3) 聚类算法的评价指标 四、算法思想 K-均值算法的主要思想是先在需要分类的数据中寻找K组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。 实验代码 function km(k,A)%函数名里不要出现“-” warning off [n,p]=size(A);%输入数据有n个样本,p个属性 cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性 %A(:,p+1)=100; A(:,p+1)=0; for i=1:k %cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心 m=i*floor(n/k)-floor(rand(1,1)*(n/k)) cid(i,:)=A(m,:); cid; end Asum=0; Csum2=NaN; flags=1; times=1; while flags flags=0; times=times+1; %计算每个向量到聚类中心的欧氏距离 for i=1:n

for j=1:k dist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离 end %A(i,p+1)=min(dist(i,:));%与中心的最小距离 [x,y]=find(dist(i,:)==min(dist(i,:))); [c,d]=size(find(y==A(i,p+1))); if c==0 %说明聚类中心变了 flags=flags+1; A(i,p+1)=y(1,1); else continue; end end i flags for j=1:k Asum=0; [r,c]=find(A(:,p+1)==j); cid(j,:)=mean(A(r,:),1); for m=1:length(r) Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); end Csum(1,j)=Asum; end sum(Csum(1,:)) %if sum(Csum(1,:))>Csum2 % break; %end Csum2=sum(Csum(1,:)); Csum; cid; %得到新的聚类中心 end times display('A矩阵,最后一列是所属类别'); A for j=1:k [a,b]=size(find(A(:,p+1)==j)); numK(j)=a; end numK times xlswrite('data.xls',A);

SPSS软件聚类分析过程的图文解释及结果的全面分析

SPSS聚类分析过程 聚类的主要过程一般可分为如下四个步骤: 1.数据预处理(标准化) 2.构造关系矩阵(亲疏关系的描述) 3.聚类(根据不同方法进行分类) 4.确定最佳分类(类别数) SPSS软件聚类步骤 1. 数据预处理(标准化) →Analyze →Classify →Hierachical Cluster Analysis →Method 然后从对话框中进行如下选择从Transform Values框中点击向下箭头,此为标准化方法,将出现如下可选项,从中选一即可: 标准化方法解释:None:不进行标准化,这是系统默认值;Z Scores:标准化变换;Range –1 to 1:极差标准化变换(作用:变换后的数据均值为0,极差为1,且|x ij*|<1,消去了量纲的影响;在以后的分析计算中可以减少误差的产生。);Range 0 to 1(极差正规化变换/ 规格化变换); 2. 构造关系矩阵 在SPSS中如何选择测度(相似性统计量): →Analyze →Classify →Hierachical Cluster Analysis →Method 然后从对话框中进行如下选择常用测度(选项说明):Euclidean distance:欧氏距离(二阶Minkowski距离),用途:聚类分析中用得最广泛的距离;Squared Eucidean distance:平方欧氏距离;Cosine:夹角余弦(相似性测度;Pearson correlation:皮尔逊相关系数; 3. 选择聚类方法 SPSS中如何选择系统聚类法 常用系统聚类方法 a)Between-groups linkage 组间平均距离连接法 方法简述:合并两类的结果使所有的两两项对之间的平均距离最小。(项对的两成员分属不同类)特点:非最大距离,也非最小距离 b)Within-groups linkage 组内平均连接法 方法简述:两类合并为一类后,合并后的类中所有项之间的平均距离最小 C)Nearest neighbor 最近邻法(最短距离法) 方法简述:用两类之间最远点的距离代表两类之间的距离,也称之为完全连接法

聚类分析算法解析.doc

聚类分析算法解析 一、不相似矩阵计算 1.加载数据 data(iris) str(iris) 分类分析是无指导的分类,所以删除数据中的原分类变量。 iris$Species<-NULL 2. 不相似矩阵计算 不相似矩阵计算,也就是距离矩阵计算,在R中采用dist()函数,或者cluster包中的daisy()函数。dist()函数的基本形式是 dist(x, method = "euclidean", diag = FALSE, upper = FALSE, p = 2) 其中x是数据框(数据集),而方法可以指定为欧式距离"euclidean", 最大距离"maximum", 绝对值距离"manhattan", "canberra", 二进制距离非对称"binary" 和明氏距离"minkowski"。默认是计算欧式距离,所有的属性必须是相同的类型。比如都是连续类型,或者都是二值类型。 dd<-dist(iris) str(dd) 距离矩阵可以使用as.matrix()函数转化了矩阵的形式,方便显示。Iris数据共150例样本间距离矩阵为150行列的方阵。下面显示了1~5号样本间的欧式距离。 dd<-as.matrix(dd)

二、用hclust()进行谱系聚类法(层次聚类) 1.聚类函数 R中自带的聚类函数是hclust(),为谱系聚类法。基本的函数指令是 结果对象 <- hclust(距离对象, method=方法) hclust()可以使用的类间距离计算方法包含离差法"ward",最短距离法"single",最大距离法"complete",平均距离法"average","mcquitty",中位数法 "median" 和重心法"centroid"。下面采用平均距离法聚类。 hc <- hclust(dist(iris), method="ave") 2.聚类函数的结果 聚类结果对象包含很多聚类分析的结果,可以使用数据分量的方法列出相应的计算结果。 str(hc) 下面列出了聚类结果对象hc包含的merge和height结果值的前6个。其行编号表示聚类过程的步骤,X1,X2表示在该步合并的两类,该编号为负代表原始的样本序号,编号为正代表新合成的类;变量height表示合并时两类类间距离。比如第1步,合并的是样本102和143,其样本间距离是0.0,合并后的类则使用该步的步数编号代表,即样本-102和-143合并为1类。再如第6行表示样本11和49合并,该两个样本的类间距离是0.1,合并后的类称为6类。 head (hc$merge,hc$height)

模糊聚类分析方法

模糊聚类分析方法 对所研究的事物按一定标准进行分类的数学方法称为聚类分析,它是多元统计“物以类聚”的一种分类方法。载科学技术、经济管理中常常要按一定的标准(相似程度或亲疏关系)进行分类。例如,根据生物的某些性状可对生物分类,根据土壤的性质可对土壤分类等。由于科学技术、经济管理中的分类界限往往不分明,因此采用模糊聚类方法通常比较符合实际。 一、模糊聚类分析的一般步骤 1、第一步:数据标准化[9] (1) 数据矩阵 设论域12{,,,}n U x x x =为被分类对象, 每个对象又有m 个指标表示其性状,即 12{,, ,}i i i im x x x x = (1,2,,) i n =, 于是,得到原始数据矩阵为 1112 1 21222 12 m m n n nm x x x x x x x x x ?? ? ? ? ??? 。 其中nm x 表示第n 个分类对象的第m 个指标的原始数据。 (2) 数据标准化 在实际问题中,不同的数据一般有不同的量纲,为了使不同的量纲也能进行比较,通常需要对数据做适当的变换。但是,即使这样,得到的数据也不一定在区间[0,1]上。因此,这里说的数据标准化,就是要根据模糊矩阵的要求,将数据压缩到区间[0,1]上。通常有以下几种变换: ① 平移·标准差变换

i k k ik k x x x s -'= (1,2,,;1,2,i n k m == 其中 11n k i k i x x n ==∑, k s =。 经过变换后,每个变量的均值为0,标准差为1,且消除了量纲的影响。但 是,再用得到的ik x '还不一定在区间[0,1]上。 ② 平移·极差变换 111m i n { }m a x {}m i n {}i k i k i n ik ik ik i n i n x x x x x ≤≤≤≤≤≤''-''=''- ,(1,2, ,)k m = 显然有01ik x ''≤≤,而且也消除了量纲的影响。 ③ 对数变换 lg ik ik x x '= (1,2,,;1,2,i n k m == 取对数以缩小变量间的数量级。 2、第二步:标定(建立模糊相似矩阵) 设论域12{,, ,}n U x x x =,12{,,,}i i i im x x x x =,依照传统聚类方法确定相似 系数,建立模糊相似矩阵,i x 与j x 的相似程度(,)ij i j r R x x =。确定(,)ij i j r R x x =的方法主要借用传统聚类的相似系数法、距离法以及其他方法。具体用什么方法,可根据问题的性质,选取下列公式之一计算。 (1) 相似系数法 ① 夹角余弦法 2 2m ik jk ij m ik jk x x r x = ∑∑ ② 最大最小法 11() () m ik jk k ij m ik jk k x x r x x ==∧= ∨∑∑。 ③ 算术平均最小法

聚类算法总结

聚类算法的种类:

--------------------------------------------------------- 几种常用的聚类算法从可伸缩性、适合的数据类型、高维性(处理高维数据的能力)、异常数据的抗干扰度、聚类形状和算法效率6个方面进行了综合性能评价,评价结果如表1所示:

--------------------------------------------------------- 目前聚类分析研究的主要内容: 对聚类进行研究是数据挖掘中的一个热门方向,由于以上所介绍的聚类方法都 存在着某些缺点,因此近些年对于聚类分析的研究很多都专注于改进现有的聚 类方法或者是提出一种新的聚类方法。以下将对传统聚类方法中存在的问题以 及人们在这些问题上所做的努力做一个简单的总结: 1 从以上对传统的聚类分析方法所做的总结来看,不管是k-means方法,还是CURE方法,在进行聚类之前都需要用户事先确定要得到的聚类的数目。然而在 现实数据中,聚类的数目是未知的,通常要经过不断的实验来获得合适的聚类 数目,得到较好的聚类结果。 2 传统的聚类方法一般都是适合于某种情况的聚类,没有一种方法能够满足各 种情况下的聚类,比如BIRCH方法对于球状簇有很好的聚类性能,但是对于不 规则的聚类,则不能很好的工作;K-medoids方法不太受孤立点的影响,但是 其计算代价又很大。因此如何解决这个问题成为当前的一个研究热点,有学者 提出将不同的聚类思想进行融合以形成新的聚类算法,从而综合利用不同聚类 算法的优点,在一次聚类过程中综合利用多种聚类方法,能够有效的缓解这个 问题。 3 随着信息时代的到来,对大量的数据进行分析处理是一个很庞大的工作,这 就关系到一个计算效率的问题。有文献提出了一种基于最小生成树的聚类算法,该算法通过逐渐丢弃最长的边来实现聚类结果,当某条边的长度超过了某个阈值,那么更长边就不需要计算而直接丢弃,这样就极大地提高了计算效率,降 低了计算成本。 4 处理大规模数据和高维数据的能力有待于提高。目前许多聚类方法处理小规 模数据和低维数据时性能比较好,但是当数据规模增大,维度升高时,性能就 会急剧下降,比如k-medoids方法处理小规模数据时性能很好,但是随着数据 量增多,效率就逐渐下降,而现实生活中的数据大部分又都属于规模比较大、 维度比较高的数据集。有文献提出了一种在高维空间挖掘映射聚类的方法PCKA (Projected Clustering based on the K-Means Algorithm),它从多个维度中选择属性相关的维度,去除不相关的维度,沿着相关维度进行聚类,以此对 高维数据进行聚类。 5 目前的许多算法都只是理论上的,经常处于某种假设之下,比如聚类能很好 的被分离,没有突出的孤立点等,但是现实数据通常是很复杂的,噪声很大, 因此如何有效的消除噪声的影响,提高处理现实数据的能力还有待进一步的提高。

对数据进行聚类分析实验报告

对数据进行聚类分析实验报告 1.方法背景 聚类分析又称群分析,是多元统计分析中研究样本或指标的一种主要的分类方法,在古老的分类学中,人们主要靠经验和专业知识,很少利用数学方法。随着生产技术和科学的发展,分类越来越细,以致有时仅凭经验和专业知识还不能进行确切分类,于是数学这个有用的工具逐渐被引进到分类学中,形成了数值分类学。近些年来,数理统计的多元分析方法有了迅速的发展,多元分析的技术自然被引用到分类学中,于是从数值分类学中逐渐的分离出聚类分析这个新的分支。结合了更为强大的数学工具的聚类分析方法已经越来越多应用到经济分析和社会工作分析中。在经济领域中,主要是根据影响国家、地区及至单个企业的经济效益、发展水平的各项指标进行聚类分析,然后很据分析结果进行综合评价,以便得出科学的结论。 2.基本要求 用FAMALE.TXT、MALE.TXT和/或test2.txt的数据作为本次实验使用的样本集,利用C均值和分级聚类方法对样本集进行聚类分析,对结果进行分析,从而加深对所学内容的理解和感性认识。 3.实验要求 (1)把FAMALE.TXT和MALE.TXT两个文件合并成一个,同时采用身高和体重数据作为特征,设类别数为2,利用C均值聚类方法对数据进行聚类,并将聚类结果表示在二维平面上。尝试不同初始值对此数据集是否会造成不同的结果。 (2)对1中的数据利用C均值聚类方法分别进行两类、三类、四类、五类聚类,画出聚类指标与类别数之间的关系曲线,探讨是否可以确定出合理的类别数目。 (3)对1中的数据利用分级聚类方法进行聚类,分析聚类结果,体会分级聚类方法。。(4)利用test2.txt数据或者把test2.txt的数据与上述1中的数据合并在一起,重复上述实验,考察结果是否有变化,对观察到的现象进行分析,写出体会 4.实验步骤及流程图 根据以上实验要求,本次试验我们将分为两组:一、首先对FEMALE 与MALE中数据组成的样本按照上面要求用C均值法进行聚类分析,然后对FEMALE、MALE、test2中数据组成的样本集用C均值法进行聚类分析,比较二者结果。二、将上述两个样本用分即聚类方法进行聚类,观察聚类结果。并将两种聚类结果进行比较。 (1)、C均值算法思想

系统聚类分析

聚类分析 聚类分析是研究“物以类聚”的一种多元统计方法。国内有人称它为群分析、点群分析、簇群分析等。 聚类分析的基本概念 聚类分析是研究对样品或指标进行分类的一种多元统计方法,是依据研究对象的个体的特征进行分类的方法。它把分类对象按一定规则分成若干类,这些类非事先给定的,而是根据数据特征确定的。在同一类中这些对象在某种意义上趋向于彼此相似,而在不同类中趋向于不相似。它职能是建立一种能按照样品或变量的相似程度进行分类的方法。 聚类分析的基本思想是认为我们所研究的样本或指标(变量)之间存在着程度不同的相似性(亲疏关系)。于是根据一批样本的多个观测指标,具体找出一些彼此之间相似程度较大的样本(或指标)聚合为一类,把另外一些彼此之间相似程度较大的样本(或指标)又聚合为另一类,关系密切的聚合到一个小的分类单位,关系疏远的聚合到一个大的分类单位,直到把所有样本(或指标)都聚合完毕,把不同的类型一一划分出来,形成一个由小到大的分类系统。最后把整个分类系统画成一张谱系图,用它把所有样本(或指标)间的亲疏关系表示出来。这种方法是最常用的、最基本的一种,称为系统聚类分析。 聚类分析有两种:一种是对样本的分类,称为Q型,另一种是对变量(指标)的分类,称为R型。 聚类分析给人们提供了丰富多彩的方法进行分类,这些方法大致可以归纳为: (1)系统聚类法。首先将n个也样品看成n类(一个类包含一个样品),然后将性质最接近的两类合并成一个新类,我们得到n-1类,再从中找出最接近的两类加以合并成了n-2类,如此下去,最后所有的样品均在一类,将上述并类过程画成一张图(称为聚类图)便可决定分多少类,每类各有什么样品。 (2)模糊聚类法。将模糊数学的思想观点用到聚类分析中产生的方法。该方法多用于定型变量的分类。 (3)K—均值法。K—均值法是一种非谱系聚类法,它是把样品聚集成k个类的集合。类的个数k可以预先给定或者在聚类过程中确定。该方法可用于比系

Matlab学习系列23. 模糊聚类分析原理及实现

23. 模糊聚类分析原理及实现 聚类分析,就是用数学方法研究和处理所给定对象,按照事物间的相似性进行区分和分类的过程。 传统的聚类分析是一种硬划分,它把每个待识别的对象严格地划分到某个类中,具有非此即彼的性质,这种分类的类别界限是分明的。 随着模糊理论的建立,人们开始用模糊的方法来处理聚类问题,称为模糊聚类分析。由于模糊聚类得到了样本数与各个类别的不确定性程度,表达了样本类属的中介性,即建立起了样本对于类别的不确定性的描述,能更客观地反映现实世界。 本篇先介绍传统的两种(适合数据量较小情形,及理解模糊聚类原理):基于择近原则、模糊等价关系的模糊聚类方法。 (一)预备知识 一、模糊等价矩阵 定义1 设R=(r ij )n ×n 为模糊矩阵,I 为n 阶单位矩阵,若R 满足 i) 自反性:I ≤R (等价于r ii =1); ii) 对称性:R T =R; 则称R 为模糊相似矩阵,若再满足 iii) 传递性:R 2 ≤R (等价于1 ()n ik kj ij k r r r =∨∧≤) 则称R 为模糊等价矩阵。 定理1 设R 为n 阶模糊相似矩阵,则存在一个最小的自然数k

(k 聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇; (6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。 K-均值聚类算法报告 摘要 K-均值是聚类方法中长用的一种划分方法,有很多优点,本文主要对K-均值是聚类方法的产生,工作原理,一般步骤,以及它的源码进行简单的介绍,了解K-均值是聚类!!! (一)课题名称:K-均值聚类(K-means clustering) (二)课题分析: J.B.MacQueen 在 1967 年提出的K-means算法[22]到目前为止用于科学和工业应用的诸多聚类算法中一种极有影响的技术。它是聚类方法中一个基本的划分方法,常常采用误差平方和准则函数作为聚类准则函数,误差平方和准则函数定义为: K-means 算法的特点——采用两阶段反复循环过程算法,结束的条件是不再有数据元素被重新分配: ① 指定聚类,即指定数据到某一个聚类,使得它与这个聚类中心的距离比它到其它聚类中心的距离要近。 ② 修改聚类中心。 优点:本算法确定的K 个划分到达平方误差最小。当聚类是密集的,且类与类之间区别明显时,效果较好。对于处理大数据集,这个算法是相对可伸缩和高效的,计算的复杂度为O(NKt),其中N是数据对象的数目,t是迭代的次数。一般来说,K< (1)从 n个数据对象任意选择 k 个对象作为初始聚类中心; (2)循环(3)到(4)直到每个聚类不再发生变化为止; (3)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分; (4)重新计算每个(有变化)聚类的均值(中心对象) k-means 算法接受输入量 k ;然后将n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 k-means 算法的工作过程说明如下:首先从n个数据对象任意选择 k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 (三)总体检索思路: 利用goole,百度,搜狗等搜索引擎及校内的一些数据库进行相关内容的检索。主要检索内容为K-均值聚类算法的工作原理,一般步骤,源码。 (四)检索过程记录: 关键词:K-均值聚类算法 搜索引擎:百度 检索内容:①K-均值聚类算法工作原理 ②K-均值聚类算法的一般步骤 ③K-均值聚类算法的源码 聚类分析的方法 一、系统聚类法 系统聚类分析法就是利用一定的数学方法将样品或变量(所分析的项目)归并为若干不同的类别(以分类树形图表示),使得每一类别内的所有个体之间具有较密切的关系,而各类别之间的相互关系相对地比较疏远。系统聚类分析最后得到一个反映个体间亲疏关系的自然谱系,它比较客观地描述了分类对象的各个体之间的差异和联系。根据分类目的不同,系统聚类分析可分为两类:一类是对变量分类,称为R型分析;另一类是对样品分类,称为Q型分析。系统聚类分析法基本步骤如下(许志友,1988)。 (一)数据的正规化和标准化 由于监测时所得到的数值各变量之间相差较大,或因各变量所取的度量单位不同,使数值差别增大,如果不对原始数据进行变换处理,势必会突出监测数据中数值较大的一些变量的作用,而消弱数值较小的另一些变量的作用,克服这种弊病的办法是对原始数据正规化或标准化,得到的数据均与监测时所取的度量单位无关。 设原始监测数据为Xij (i=1,2,…,n;j=1,2,…,m;n为样品个数,m为变量个数),正规化或标准化处理后的数据为Zij (i=1,2,…,n;j=1,2,…,m)。 1. 正规化计算公式如下: (7-32) (i=1,2,…,n;j=1,2,…,m) 2. 标准化计算公式如下: (7-33) (i=1,2,…,n;j=1,2,…,m) 其中: (二)数据分类尺度计算 为了对数据Zij进行分类,须对该数据进一步处理,以便从中确定出分类的尺度,下列出分类尺度计算的四种方法。 1.相关系数R 两两变量间简单相关系数定义为: (7-34) (i,j=1,2,…,m) 其中 一般用于变量的分类(R型)。有一1≤≤1且愈接近1时,则此两变量愈亲近, 愈接近-1,则关系愈疏远。 2.相似系数 相似系数的意义是,把每个样品看做m维空间中的一个向量,n个样品相当于m维空间中的n个向量。第i个样品与第j个样品之间的相似系数是用两个向量之间的夹角余弦来定义,即: 模糊聚类分析方法 对所研究的事物按一定标准进行分类的数学方法称为聚类分析,它是多元统计“物以类聚”的一种分类方法。载科学技术、经济管理中常常要按一定的标准(相似程度或亲疏关系)进行分类。例如,根据生物的某些性状可对生物分类,根据土壤的性质可对土壤分类等。由于科学技术、经济管理中的分类界限往往不分明,因此采用模糊聚类方法通常比较符合实际。 一、模糊聚类分析的一般步骤 1、第一步:数据标准化[9] (1) 数据矩阵 设论域12{,,,}n U x x x =为被分类对象,每个对象又有m 个指标表示其性状, 即 12{,, ,}i i i im x x x x = (1,2, ,)i n =, 于是,得到原始数据矩阵为 11 121212221 2 m m n n nm x x x x x x x x x ?? ? ? ? ??? 。 其中nm x 表示第n 个分类对象的第m 个指标的原始数据。 (2) 数据标准化 在实际问题中,不同的数据一般有不同的量纲,为了使不同的量纲也能进行比较,通常需要对数据做适当的变换。但是,即使这样,得到的数据也不一定在区间[0,1]上。因此,这里说的数据标准化,就是要根据模糊矩阵的要求,将数据压缩到区间[0,1]上。通常有以下几种变换: ① 平移·标准差变换 ik k ik k x x x s -'= (1,2,,;1,2,,)i n k m == 其中 11n k ik i x x n ==∑, k s = 经过变换后,每个变量的均值为0,标准差为1,且消除了量纲的影响。但 是,再用得到的ik x '还不一定在区间[0,1]上。 ② 平移·极差变换 111min{}max{}min{}ik ik i n ik ik ik i n i n x x x x x ≤≤≤≤≤≤''-''=''-,(1,2,,)k m = 显然有01ik x ''≤≤,而且也消除了量纲的影响。 ③ 对数变换 lg ik ik x x '= (1,2,,;1,2,,)i n k m == 取对数以缩小变量间的数量级。 2、第二步:标定(建立模糊相似矩阵) 设论域12{,, ,}n U x x x =,12{,, ,}i i i im x x x x =,依照传统聚类方法确定相似 系数,建立模糊相似矩阵,i x 与j x 的相似程度(,)ij i j r R x x =。确定(,)ij i j r R x x =的方法主要借用传统聚类的相似系数法、距离法以及其他方法。具体用什么方法,可根据问题的性质,选取下列公式之一计算。 (1) 相似系数法 ① 夹角余弦法 21 m ik jk ij m ik jk k x x r x == ∑∑。 ② 最大最小法 11() () m ik jk k ij m ik jk k x x r x x ==∧= ∨∑∑。 ③ 算术平均最小法 嵌入式方向工程设计实验报告 学院班级:130712 学生学号:13071219 学生姓名:杨阳 同作者:无 实验日期:2010年12月 聚类算法分析研究 1 实验环境以及所用到的主要软件 Windows Vista NetBeans6.5.1 Weka3.6 MATLAB R2009a 2 实验内容描述 聚类是对数据对象进行划分的一种过程,与分类不同的是,它所划分的类是未知的,故此,这是一个“无指导的学习” 过程,它倾向于数据的自然划分。其中聚类算法常见的有基于层次方法、基于划分方法、基于密度以及网格等方法。本文中对近年来聚类算法的研究现状与新进展进行归纳总结。一方面对近年来提出的较有代表性的聚类算法,从算法思想。关键技术和优缺点等方面进行分析概括;另一方面选择一些典型的聚类算法和一些知名的数据集,主要从正确率和运行效率两个方面进行模拟实验,并分别就同一种聚类算法、不同的数据集以及同一个数据集、不同的聚类算法的聚类情况进行对比分析。最后通过综合上述两方面信息给出聚类分析的研究热点、难点、不足和有待解决的一些问题等。 实验中主要选择了K 均值聚类算法、FCM 模糊聚类算法并以UCI Machine Learning Repository 网站下载的IRIS 和WINE 数据集为基础通过MATLAB 实现对上述算法的实验测试。然后以WINE 数据集在学习了解Weka 软件接口方面的基础后作聚类分析,使用最常见的K 均值(即K-means )聚类算法和FCM 模糊聚类算法。下面简单描述一下K 均值聚类的步骤。 K 均值算法首先随机的指定K 个类中心。然后: (1)将每个实例分配到距它最近的类中心,得到K 个类; (2)计分别计算各类中所有实例的均值,把它们作为各类新的类中心。 重复(1)和(2),直到K 个类中心的位置都固定,类的分配也固定。 在实验过程中通过利用Weka 软件中提供的simpleKmeans (也就是K 均值聚类算法对WINE 数据集进行聚类分析,更深刻的理解k 均值算法,并通过对实验结果进行观察分析,找出实验中所存在的问题。然后再在学习了解Weka 软件接口方面的基础上对Weka 软件进行一定的扩展以加入新的聚类算法来实现基于Weka 平台的聚类分析。 3 实验过程 3.1 K 均值聚类算法 3.1.1 K 均值聚类算法理论 K 均值算法是一种硬划分方法,简单流行但其也存在一些问题诸如其划分结果并不一定完全可信。K 均值算法的划分理论基础是 2 1 min i c k i k A i x v ∈=-∑∑ (1) 其中c 是划分的聚类数,i A 是已经属于第i 类的数据集i v 是相应的点到第i 类的平均距离,即 模糊聚类分析法及其应用 (汽车学院钟锐 2011122071) 摘要模糊聚类分析方法是一种多元统计分析方法, 它通过多个指标将样本划分为若干类, 这种分类方法能很好地应用于交通规划、交通流分析、安全评价等多个方面。文章以交通调查的选择为例说明了模糊聚类分析在规划过程中的具体应用, 并分析了模糊聚类分析在交通规划其他方面的应用。在交通调查中, 可利用模糊聚类分析将交通分区按工业、居住、公建、道路绿化广场等各项用途来进行分类。可相应减少同类交通分区的相似调查工作量。 关键词模糊聚类分析; 交通规划; 交通调查 1 问题的提出 交通规划旨在确定公路和城市道路交通建设的发展目标, 设计达到这些目 标的策略、过程与方案。交通规划包括目标确定、组织工作、数据调查、相关基本模型分析、分析预测、方案设计、方案评价、方案实施过程中的信息反馈和修改等工作阶段。在交通规划的很多阶段, 需要进行分类。例如可将众多的交通小区划分成几大类, 将具有相似特性的交通小区归于一类, 可以减少调查的工作量; 对线路网络进行分析评价时, 也需要进行分类。单一的指标往往不能全面反映交通分区之间的关系, 需要用多个指标来进行。在分类方法中,聚类分析是一种应用很广泛的方法, 它在交通规划领域应用较多。 2 聚类分析方法 聚类分析取意于“人以群分, 物以类聚”的俗语, 即将一组事物根据其性质上亲疏远近的程度进行分类, 把性质相近的个体归为一类, 使得同一类中的个体具有高度的同质性, 不同类之间的个体具有高度的异质性。为使分类合理, 必须描述个体之间的亲疏程度。对此, 通常有距离法、相关系数法等方法。距离法是将每个样本看成m( m 为统计指标的个数) 维空间的一个点, 在m 维空间中定义点与点之间的某种距离; 相关系数法是用某种相似系数来描述样本之间的关系, 如相关系数。聚类的方法有很多, 如系统聚类法、模糊聚类法、分裂法、 K-means聚类算法分析应用研究 发表时间:2011-05-09T08:59:20.143Z 来源:《魅力中国》2011年3月上作者:李曼赵松林 [导读] 本文浅谈了数字图像处理的发展概况、研究背景并对彩色图像K-means算法进行分析。 李曼赵松林 (商丘职业技术学院河南商丘,476000) 中图分类号:TP39 文献标识码:A 文章编号:1673-0992(2011)03-0000-01 摘要:本文浅谈了数字图像处理的发展概况、研究背景并对彩色图像K-means算法进行分析.主要详细谈论了是对K-means算法的一些认识,并且介绍K-means聚类的算法思想、工作原理、聚类算法流程、以及对算法结果进行分析,得出其特点及实际使用情况。 关键字:数字图像处理;K-means算法;聚类 一、数字图像处理发展概况及边缘的概念 数字图像处理(Digital Image Processing)即计算机图像处理,就是利用计算机对图像进行去除噪声、增强、复原、分割、特征提取、识别等处理的理论、方法和技术[1]。最早出现于20世纪50年代,它作为一门学科大约形成于20世纪60年代初期。它以改善图像的质量为对象,以改善人的视觉效果为目的。在处理过程中,输入低质量图像,输出质量高图像,图像增强、复原、编码、压缩等都是图像处理常用的方法[1]。数字图像处理在航天、航空、星球探测、通信技术、军事公安、生物工程和医学等领域都有广泛的应用,并取得了巨大的成就。 边缘就是图像中灰度有阶跃变化或屋顶变化的像素的集合,边缘是图像最重要的特征之一,它包含了图像的大部分信息。实质上边缘检测就是采用算法提取图像中对象与背景间的交界线。在目标与背景、目标与目标、区域与区域、基元与基元之间都存在边缘,这是图像分割所依赖的最重要的特征之一。根据灰度变化的剧烈程度,边缘可以分为两种:一种是屋顶边缘,一种为阶跃性边缘。对于屋顶状边缘,二阶导数在边缘初取极值,而对阶跃性边缘,二阶导数在边缘处零交叉;。 二、彩色图像的K-means聚类算法 (一)K-means聚类 聚类就是把数据分成几组,按照定义的测量标准,同组内数据与其他组数据相比具有较强的相似性。K-means聚类就是首先从n个数据对象任选k个对象作为初始聚类中心;剩下的其它对象,则根据它们与这些聚类中心的距离(相似度),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);一直重复此过程直至标准测度函数收敛为止。通常都采用均方差作标准测度函数。k个聚类有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 聚类的用途是很广泛的。在商业上,聚类可以帮助市场分析人员从消费者数据库中区分出不同的消费群体来,并且概括出每一类消费者的消费模式或者说习惯。它作为数据挖掘中的一个模块,可以作为一个单独的工具以发现数据库中分布的一些深层的信息,并且概括出每一类的特点,或者把注意力放在某一个特定的类上以作进一步的分析;并且,聚类分析也可以作为数据挖掘算法中其他分析算法的一个预处理步骤。 (二)算法思想分析 输入:聚类个数k,以及包含 n个数据对象的彩色图片。 输出:满足方差最小标准的k个聚类。 处理流程: (1)从 n个数据对象任意选择 k 个对象作为初始聚类中心; (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分; (3)重新计算每个(有变化)聚类的均值(中心对象); (4)循环(2)到(3)直到每个聚类不再发生变化为止。 首先设置K值,也就是确定若干个聚类中心。使用rand函数随机获得K个颜色值,存放在矩阵miu中,第一次对每个像素点中的K种颜色进行迭代运算,得到最小的颜色矩阵的2范数,同时标记该颜色,依次相加的到各点的颜色矩阵总值。再次迭代得到K中颜色的各个矩阵均值。最后提取出标记的各个颜色,依次对各个点进行颜色赋值,使每个像素点的颜色归类。得到聚类后的图像。 (三)算法的数学描述 (四)算法过程分析 设置K值为8,读入一幅图片后计算图像上所有的像素点个数为N,即令N=size(X,1)*size(X,2),令颜色矩阵R为矩阵[N,K]并清零。随机获得颜色聚类中心为Miu=fix(255*rand(K,3))。聚类分析K-means算法综述

k均值聚类报告

聚类分析的方法

模糊聚类分析方法汇总

聚类算法分析报告汇总

模糊聚类法

K-means聚类算法分析应用研究