基于分块的网页正文信息提取算法研究

收稿日期:2006-12-21 基金项目:上海市科学技术委员会科技攻关项目(055115001)

作者简介:黄文蓓(1982-),女,上海人,硕士研究生,主要研究方向:信息抽取、数据挖掘; 杨静(1976-),女,重庆人,讲师,博士,主要研究方向:知识提取、多媒体; 顾君忠(1949-),男,上海人,教授,博士生导师,主要研究方向:计算机支持的协同工作(CSC W )、分布式数据库系统及多媒体技术.

文章编号:1001-9081(2007)S1-0024-03

基于分块的网页正文信息提取算法研究

黄文蓓,杨 静,顾君忠

(华东师范大学计算机科学技术系,上海200062)

(wbhuang@ica .stc .sh .cn )

摘 要:提出并实现了一种从W eb 页面获取正文的方法。该方法包括2个步骤:网页分块和对内容块的取舍。网页分块采用了一种自底向上分析标签树的自动分块算法,该算法比起以往方法更准确,并且对于复杂结构的页面分块效果更好。通过引入块的重要度和块特征分析每个内容块,来辨别出含有正文的内容块。实验结果表明本方法切实可行并且具有较高的准确性。

关键词:W eb 网页正文提取;内容块;标签树;噪音中图分类号:TP391 文献标识码:A

0 引言

随着W eb 的迅速发展,W eb 上的信息越来越丰富。为了更好的使用W eb 上的信息,人们不断追求能够有效组织和利用网上信息的技术和系统。然而,W eb 文档不像传统的文本那样整齐、干净,其中包含大量噪音内容,例如为了增强用户交互性而加入的脚本,为了便于用户浏览而加入的导航链接,以及出于商业因素所加入的广告链接等。这些噪音内容不仅影响W eb 信息检索的效率,而且还导致了检索准确性的下降。因此快速准确地识别出网页正文已成为W eb 信息处理系统预处理环节中一个必不可少的工作。

1 相关工作

在W eb 信息抽取领域,已经有大量的研究工作。文献

[1]提出了一个去除网页噪音内容的方法。该方法是针对使

用同一个模板生成的网页集,找出在该网页集中共同出现多次的内容,作为冗余内容,而共同出现较少的内容就是有效信息。实验证明该方法是有效的,但该方法必须局限在基于同一个模板的网页集,而W eb 上的网页模板不计其数,因此该方法显然不够通用。

另一类方法是从另一种角度———视觉特征对页面结构进行挖掘。典型的代表就是微软亚洲研究院提出的V I PS

(V isi on 2based Page Seg mentati on )[2]。它充分利用了字体大小、背景颜色、空白区域等视觉特征,通过制定相应的规则把页面分成了各个视觉信息块。这能在一定程度上满足复杂页面对算法的要求,但由于视觉特征的复杂性,运用的启发知识往往较为模糊,需要人工不断地总结调整规则,因此如何保证规则集的一致性是一大难点。

还有许多研究者考虑使用HT ML 标签信息来划分页面。其中有中科院计算所软件研究室提出的利用T ABLE 标记和视觉特征对页面进行语义块划分,并识别各语义块属性的算法T VPS (Table and V isi on based Page Seg mentati on )[3]。T VPS 算法中的分块方法只考虑了把各个最底层的T ABLE 标记,但是实际情况中网页样式结构和T ABLE 标记的嵌套关系都非常复杂,网页正文信息不一定全在最底层的T ABLE 标记中。

如果只考虑最底层的T ABLE 标记,会遗漏部分正文信息。文献[4]提出了一种基于统计的方法来实现中文新闻类网页中正文信息的抽取,这种方法利用了中文网页的特性,实现简单,对新闻类网页效果不错。但是该方法只适合于一个网页中所有的正文信息都放在一个T ABLE 标记中的情况。

上述几个文献中提出的方法都有一定的局限性和不足。本文在前人工作的基础上并结合对HT ML 网页性质的统计和观察,对T VPS 算法[3]中的分块方法作了改进,提出了一种更加准确的自动分块算法,克服了T VPS 算法[3]的不足。另外引进了块的重要度和块特征,通过重要度来决定是否要将该块内容提取出来。本文方法更为通用,不需要依赖网页模板等附加信息,也不需要对要处理的网页增加限制条件,比如,这些网页属于同一个类型。算法实现复杂度也较低。

2 分块算法描述

首先要定义网页上什么信息是我们所要提取的正文。网页通常分为三种类型:主题型网页、图片型网页、目录型网页[5]。主题型网页通常通过成段的文字描述一个或多个主题,虽然也会出现图片和超链接,但这些图片和超链接并不是网页的主体;图片型网页中内容是通过图片体现的,而文字仅仅是对图片的一个说明,因而文字不多;目录型网页通常不会描述一件事物,而是提供指向相关网页的超链接,因此,网页中超链接密集。本文所研究的正文提取是指主题型网页中成

段文字的提取。

在视觉上,一张网页的页面可以划分为若干个区域,同一个区域内包含相近的内容,我们把一个区域称为一个内容块。这些内容块中,有的包含着我们所需要的正文内容,而有的则包含着噪音内容,如广告等。通常,一个内容块中的内容是紧密相关的,所以我们可以以内容块为单位对网页中的内容进行取舍,保留包含正文信息的内容块而去掉包含噪音信息的内容块。所以提取正文的过程可以分为两个步骤:将网页分块和对内容块的取舍。

2.1 网页标准化

对网页进行分块之前要做的一件事情就是网页标准化。HT ML 语言是一个标识语言(Markup Language ),它定义了一

第27卷2007年6月

计算机应用

Computer App licati ons

Vol .27June 2007

套标签来刻画网页显示时的页面布局。但有些网页中存在

HT ML 标签不规范的情况,如有

等结束标志。

开源的网页整理工具有很多,如W 3C 组织推荐了一套免费的工具集HT ML Tidy,帮助开发者转换书写不规范的HT ML 文档,并可进一步生成格式良好的XHT ML (X ML 的子集)。2.2 构造标签树

接下来对整理好的规范网页构造标签树。标签树是表示网页结构的最常用的方法。构造标签树的方法比较简单,可以自己编写递归算法,也可以使用现成的工具,如,DOM (Docu ment ObjectModel )是一个常用的标签树构造工具,它可以将网页中的标签按照嵌套关系整理成一棵树状结构。在构造的过程中注意保留每个节点的字体大小、粗细、颜色、背景等视觉属性,方便后续处理。

由于我们是提取正文信息,关心的是那些含有文字内容的节点,有必要对标签树做裁剪,把无关节点先删除,也可以提高后续处理的效率。可以按照如下的规则来裁剪:

规则1:如果一个节点不是文本节点(Text Node )并且没有子节点,则把该节点删除。

规则2:如果一个节点的所有子孙节点都不是文本节点,则把该节点删除。

另外STY LE 标签、SCR I PT 标签等里面的内容对于正文提取是无意义的,这样的节点也要删除掉。2.3 将网页分割成块

上述参考文献中大部分分块算法都是基于T ABLE 标签的,本文提出的分块算法也准备利用HT ML 标签。

依据标签的作用可以将HT ML 标签分为两类:

1)描述布局结构的标签。如上所述,在视觉上,网页是由若干内容块组成的,而内容块是由特定的标签(称之为容器标签[5])规划出的。常用的容器标签有

| 、 、 等等。

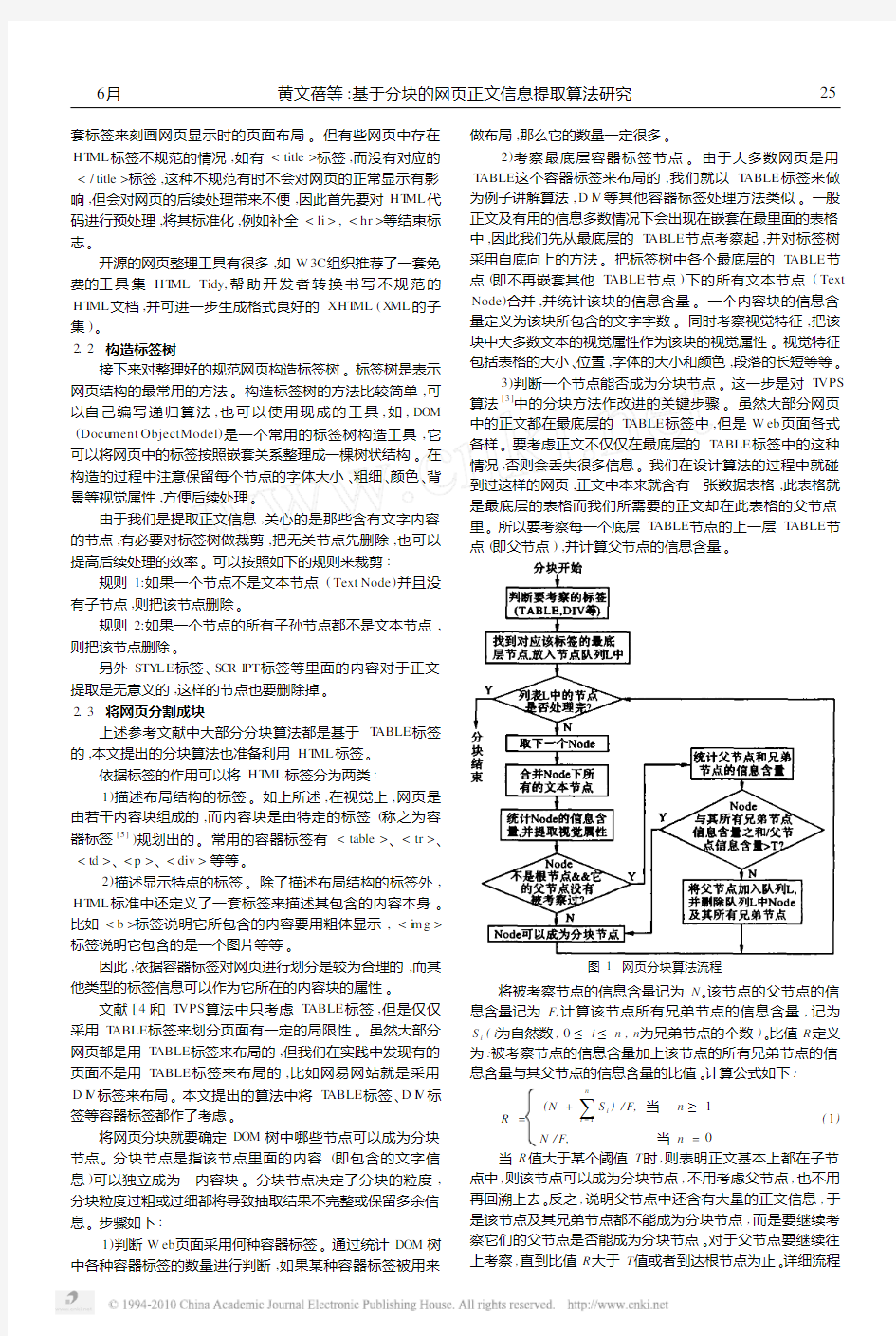

2)描述显示特点的标签。除了描述布局结构的标签外,HT ML 标准中还定义了一套标签来描述其包含的内容本身。比如标签说明它所包含的内容要用粗体显示,标签说明它包含的是一个图片等等。 因此,依据容器标签对网页进行划分是较为合理的,而其他类型的标签信息可以作为它所在的内容块的属性。 文献[4]和T VPS 算法中只考虑T ABLE 标签,但是仅仅采用T ABLE 标签来划分页面有一定的局限性。虽然大部分网页都是用T ABLE 标签来布局的,但我们在实践中发现有的页面不是用T ABLE 标签来布局的,比如网易网站就是采用D I V 标签来布局。本文提出的算法中将T ABLE 标签、D I V 标签等容器标签都作了考虑。 将网页分块就要确定DOM 树中哪些节点可以成为分块节点。分块节点是指该节点里面的内容(即包含的文字信息)可以独立成为一内容块。分块节点决定了分块的粒度,分块粒度过粗或过细都将导致抽取结果不完整或保留多余信息。步骤如下: 1)判断W eb 页面采用何种容器标签。通过统计DOM 树中各种容器标签的数量进行判断,如果某种容器标签被用来 做布局,那么它的数量一定很多。 2)考察最底层容器标签节点。由于大多数网页是用T ABLE 这个容器标签来布局的,我们就以T ABLE 标签来做为例子讲解算法,D I V 等其他容器标签处理方法类似。一般正文及有用的信息多数情况下会出现在嵌套在最里面的表格中,因此我们先从最底层的T ABLE 节点考察起,并对标签树采用自底向上的方法。把标签树中各个最底层的T ABLE 节点(即不再嵌套其他T ABLE 节点)下的所有文本节点(Text Node )合并,并统计该块的信息含量。一个内容块的信息含量定义为该块所包含的文字字数。同时考察视觉特征,把该块中大多数文本的视觉属性作为该块的视觉属性。视觉特征包括表格的大小、位置,字体的大小和颜色,段落的长短等等。 3)判断一个节点能否成为分块节点。这一步是对T VPS 算法[3]中的分块方法作改进的关键步骤。虽然大部分网页中的正文都在最底层的T ABLE 标签中,但是W eb 页面各式各样。要考虑正文不仅仅在最底层的T ABLE 标签中的这种情况,否则会丢失很多信息。我们在设计算法的过程中就碰到过这样的网页,正文中本来就含有一张数据表格,此表格就是最底层的表格而我们所需要的正文却在此表格的父节点里。所以要考察每一个底层T ABLE 节点的上一层T ABLE 节点(即父节点),并计算父节点的信息含量 。 图1 网页分块算法流程 将被考察节点的信息含量记为N 。该节点的父节点的信 息含量记为F,计算该节点所有兄弟节点的信息含量,记为S i (i 为自然数,0≤i ≤n ,n 为兄弟节点的个数)。比值R 定义为:被考察节点的信息含量加上该节点的所有兄弟节点的信息含量与其父节点的信息含量的比值。计算公式如下: R = (N +∑n i =1 S i )/F, 当 n ≥1 N /F, 当n =0 (1) 当R 值大于某个阈值T 时,则表明正文基本上都在子节点中,则该节点可以成为分块节点,不用考虑父节点,也不用再回溯上去。反之,说明父节点中还含有大量的正文信息,于是该节点及其兄弟节点都不能成为分块节点,而是要继续考察它们的父节点是否能成为分块节点。对于父节点要继续往上考察,直到比值R 大于T 值或者到达根节点为止。详细流程 526月黄文蓓等:基于分块的网页正文信息提取算法研究 见图1。 阈值T 的大小决定了分块的粒度。T 值取得太大,块会分的比较粗,不利于去掉噪音信息,因为可能将噪音信息和正文信息都放到了同一块中。反过来,T 值太小则会丢失部分有用的正文信息。我们从10个不同网站上各选取了5篇网页进行实验,T 取不同值从0.5到0.9,分别考察了分块的准确性,综合考虑能否将噪音信息与正文信息隔离在不同的块中以及正文信息的完整性。实验结果如下 : 图2 T 值选择实验结果 由此可见T 值在0.6~0.7之间有较好的效果,我们将T 值取为0.65。 3 提取含有正文的块 分块结束后接下来对内容块进行取舍,取出含有正文信息的内容块。首先提出2个概念:块的重要度和块特征。3.1 块的重要度 块的重要度根据用户不同的需求制定不同的级别,这样做比较灵活。比如本文关心的是网页中的正文信息,即网页的主题内容,而对广告、导航栏等信息并不关心,那么定义如下级别: 级别1:噪音信息,比如广告、版权以及用来装饰的无用信息等等。 级别2:有一定用处但和网页的主题并不相关的信息,比如导航栏,网站目录等等。 级别3:与网页主题相关但不是网页中最显著的部分,比如相关标题,标题索引等等。 级别4:网页中最显著部分的信息,也就是网页的主题,比如大字标题,正文内容等等。 级别越高,重要度就越高。级别4是最重要的,最后我们就要从该级别的内容块中提取出正文信息。参见图3。 可以根据用户的不同需要相应地调整级别的重要度,比如有的用户关心网站的目录链接信息,有的用户要根据导航栏追溯上层页面等等。一个块的重要度可以由块的特征反映出来。3.2 块特征 块特征主要包括两大方面:空间特征和内容特征。空间特征包括块的位置和大小等等;内容特征包括文字长度,链接数量,图片数量等等。 空间特征主要由4个参数表述:块中心的横坐标(B l ockCenter X ),块中心的纵坐标(B l ockCenterY ),块的宽度(B l ock W idth ),块的高度(B l ockHeight )。本文采用 Kovacevic [6] 中的模拟浏览器显示算法来计算位置坐标。此处不再赘述。 网页设计者一般都会将重要的信息放置在网页的正中,把导航栏放置在页面的顶端或者页面的左边以及版权信息放置在页面的底部(见图3)。所以块的位置和大小是判断块的重要度的一个重要因素。 而内容特征,即一个块表达了什么形式的内容,可以从下 面几个参数中看出:文字长度(Text L ength ),链接数量(L ink Nu m ),链接文字长度(L inkText L ength ),图片数量(I m age Nu m ),图片大小(I m ageSize )等等。例如,一个广告可能只包含图片而没有文字;导航栏一般是字数较少的链接。 设L T 值为链接文字长度比上文字长度,见下式: L T =L inkTex t L eng th /Tex t L eng th (2)如果L T 值大于阈值(实验中阈值取为0.5),那么说明该块中大部分为链接,该块为链接块,否则为文字块。 如果链接的地址在广告商地址列表中,可以判断该链接是广告,那么包含这条链接的内容块的重要度为级别1。 Hanzlik [7] 考察了该方法,并列举出了一系列广告商服务器的地址。这种方法最好定期更新广告商的黑名单,可以从htt p://accs 2net .co m 上更新,这个站点是专门列出这样的黑名单。 图3 块的重要度示例图 那如何将链接块区分级别2和级别3呢?最简单的方法 就是通过是否含有“相关链接”、“相关新闻”、“相关报道”等等敏感词来判断。当然有些网页上并不会标注此类词汇,那么将链接中的文字和正文的标题分词后作一下比较,含有相同的词的个数比较多的话可以判断是相关的了。 如果只要求提取出正文信息的话,可以省去区分级别1至级别3,能识别出级别4就行。级别4的内容块是文字块,一般位于页面的中间位置。 综合考虑空间特征和内容特征,可以判断出每个块的重要度是哪一级。最后我们提取出重要度为级别4的内容块中的文字,合并这些文字就是我们所要的正文。 4 实验结果 在实验中,我们抽取了人民网、新浪、网易、搜狐等大型的门户网站和主要新闻网站上的100多篇网页进行测试。不同 (下转第30页) App licati onContext actx = ne w FileSyste mXm l A pp licati onContext (configFile ); //通过DAO 接口获取数据访问组件Bean O rder DAO order DAO =(O rder DAO )actx .get B ean ("O rder DAO"); ? //业务逻辑实现//通过客户I D 查询订单 public L ist findO rder ByCusI d (String cusI d ){//通过DAO 接口访问数据源 L ist order L ist =order DAO.findByCusI d (cusI d ); ? return order L ist;} //其他业务逻辑实现 ? 4.4 测试结果及分析 图3 控制台输出界面 这里编辑一个测试页面BusinessTest .js p 来考察该数据 集成方法,其应用逻辑是先通过客户I D 查询并输出客户信息和订单信息,然后该客户增加和删除一个订单,最后再次查询并输出该客户的订单信息。启动服务器后,运行测试页面,在 控制台输出了如图3所示信息。 在输出的信息中,订单信息来自M icr os oft S QL Server 数据源,客户信息来自MyS QL 数据源,产品信息来自M icr os oft Office Access 数据源,产品描述信息来自Word 文档。 从该示例可以看出,该数据集成方法实现了数据源的松散配置和“即插即用”,以及业务层对数据的透明访问。然而,I oC 和OR M 并不是S p ring 和H ibernate 的独有特征,而是Sp ring 和H ibernate 实现了I oC 和OR M 。因此,该模型可以运用于其他任何实现了I oC 和OR M 的框架中。 5 结语 异构数据集成的关键是处理成员数据源和全局应用需求变化。本文介绍了一种在I oC 容器中通过配置组件实现异构数据集成的方法,在技术上满足了这种伸缩的要求。基于该方法的数据集成模型,实现了数据源的“即插即用”,具有良好的可扩展性;同时,也降低了系统开发的复杂度,提高了可维护性。参考文献: [1] 杨宏英,林长松.异构数据集成系统的应用模式与技术实现 [J ].微电子学与计算机,2006,23(8):70-72.[2] 王三明.信息系统中的异构数据源的整合和集成模式[R ].中国 软考联盟,2004. [3] 朱静,陈忠良.异构数据源集成的实现[J ].内蒙古大学学报(自 然科学版),2005,36(4):458-461.[4] 席晓峰,吕良双,逯鹏.使用J2EE 框架技术构建可重用的W eb 应用[J ].计算机工程与应用,2005,41(29):208-210,214.[5] JOHNS ON R,HOELLOR J,ARENDSEN A,et al .Sp ring 框架高 级编程[M ].蒋培,译.北京:机械工业出版社,2006.[6] JOHNS ON R,HOELLER J,ARENDSEN A,et al .Sp ring java /j2ee App licati on Frame work Reference Document v2.0.1[Z],2006.[7] 李守振,张南平,常国锋.W eb 应用分层与开发框架设计研究 [J ].计算机工程,2006,32(22):274-276. (上接第26页) 网站的网页结构差别比较大,有助于验证算法的性能。本文还实现了T VPS 算法,以便进行比较。 对正文提取效果的评估带有主观性,所以采用人工评价的方法,分为“好、良、中、差”4档,要综合考虑正文信息的完整性和噪音过滤这两方面。让5位测试者独立测试,并取其平均值。实验结果如表1所示。 表1 网页正文提取实验数据(单位:%) 本文方法 T VPS 算法 好 8368良1114中513差 1 5 由此表可知,本文方法要优于T VPS,而且“好”和“良”达到了94%。实验结果表明本文方法切实可行并且具有较高的准确率。 5 结语 本文针对W eb 信息检索和提取,研究并实现了一种从 W eb 页面获取文本正文的方法。此方法在T VPS 算法的基础 上作了改进,提出了一种新的分块方法,克服了T VPS 算法的不足。另外引进了块的重要度和块特征,通过重要度来决定 是否要将该块内容提取出来。实验效果表明该方法能自动地从网页中提取出正文信息,不依赖于网页结构,对于异构信息源具有很高的通用性。进一步研究工作包括:制定启发式规则识别正文标题,利用分块时提取出的视觉属性对正文做摘要,提取关键词等。参考文献: [1] L I N S 2H ,HO J 2M.D iscovering infor mative content bl ocks fr om W eb documents[A ].the Eighth AC M SI GK DD I nternati onal Confer 2ence on Knowledge D iscovery and Data M ining (SI GK DD π02)[C ].July,2002. [2] DE NG C,Y U SP,W EN JR,et al .V I PS:A V isi on 2Based Page Seg mentati on,MSR 2TR 22003279[R ].2003. [3] 于满泉,陈铁睿,许洪波.基于分块的网页信息解析器的研究与 设计[J ].计算机应用,2005,25(4),974-976. [4] 孙承杰,关毅.基于统计的网页正文信息抽取方法的研究[J ].中 文信息学报,2004,18(5):17-22. [5] 张志刚,陈静,李晓明.一种HT ML 网页净化方法[J ].情报学 报,2004,23(4):387-393. [6] K OVACEV I C M.Recogniti on of common areas in web page using visual infor mati on:A possible app licati on in a page classificati on [A ].Pr oceedings of I CDM02[C ].Maebashi,Japan:I EEE Press,2002.250-258. [7] HANZ L I K S .Gorilla Design Studi os Presents:The Hosts File [EB / OL ].htt p://accs -net .com /hosts/,2006. 网页链接提取方法https://www.wendangku.net/doc/2d13958142.html, 网页链接提取方法 网页链接的提取是数据采集中非常重要的部分,当我们要采集列表页的数据时,除了列表标题的链接还有页码的链接,数据采集只采集一页是不够,还要从首页遍历到末页直到把所有的列表标题链接采集完,然后再用这些链接采集详情页的信息。若仅仅靠手工打开网页源代码一个一个链接复制粘贴出来,太麻烦了。掌握网页链接提取方法能让我们的工作事半功倍。在进行数据采集的时候,我们可能有提取网页链接的需求。网页链接提取一般有两种情况:提取页面内的链接;提取当前页地址栏的链接。针对这两种情况,八爪鱼采集器均有相关功能实现。下面介绍一个网页链接提取方法。 一、八爪鱼提取页面内的超链接 在网页里点击需要提取的链接,选择“采集以下链接地址” https://www.wendangku.net/doc/2d13958142.html, 网页链接提取方法1 二、八爪鱼提取当前地址栏的超链接 从左边栏拖出一个提取数据的步骤出来(如果当前页已经有其他的提取字段,这一步可省略)点击“添加特殊字段”,选择“添加当前页面网址”。可以看到,当前地址栏的超链接被抓取下来 https://www.wendangku.net/doc/2d13958142.html, 网页链接提取方法2 而批量提取网页链接的需求,一般是指批量提取页面内的超链接。以下是一个使用八爪鱼批量提取页面内超链接的完整示例。 采集网站: https://https://www.wendangku.net/doc/2d13958142.html,/search?initiative_id=tbindexz_20170918&ie=utf8&spm=a21 bo.50862.201856-taobao-item.2&sourceId=tb.index&search_type=item&ssid=s5-e&commend=all&imgfile=&q=手表&suggest=history_1&_input_charset=utf-8&wq=&suggest_query=&source=sugg est 如何提取网页上不能复制的文字如何提取网页上不能复制的文字 我们在浏览一些网页时会发现,有的网站可能出于保护版权的缘故,上面的文字是不能复制的。那么我们应该如何提取上面的文字呢?下面就教几种常用的方法给大家: 第一招 点击浏览器的“工具”—“internet选项”—“安全”—“自定义级别”,然后将脚本全部禁用,安F5刷新一下网页。这时候你就会发现之前不能复制的内容,现在都没有问题了!(提示:复制完想要的东西之后,记得吧禁用的脚本解禁,否则会影响正常浏览的) 第二招 这招说其实是最简单,但有时最麻烦的一招。直接右击然后“查看源文件”,在源文件代码中复制需要的文章。不过复制文章的时候会有很多用不着的符号和代码。是有些麻烦。 第三招 点击浏览器的“文件”菜单栏,选择“保存网页”然后点开保存的文件,下载下来想要的网页,然后用word文本打开就可以了! 第四招 打开想要下载的网页,然后把该网页另存到电脑上面,接着用记事本打开的方法打开!在记事本中找到(onpaste= “reture flase”不准粘贴oncopy=“reture flase;”不准复制oncut=“reture flase;”不准剪切onselectarst=“reture flase”不准选择)这句语句或者类似的代码,然后把这句代码去掉,body模块中的除外,然后保存记事本。接着双击打开刚才保存的记事本,这时候出现的文章就是可以复制的文章了 第五招 可以将网页截屏或是截图下来,再使用捷速图片文字识别软件,对网页上的文字进行识别,识别得到的文字可以保存为word,word中的文字可以随意的进行编辑或是其他操作。捷速图片文字识别软件的操作很简单,软件采用引导式界面,无需专业的技术知识,只要按软件提示点几下鼠标,就能轻松转扫描文件或PDF文件和图片文件。从兼容性来看,该软件可以适用于任何Windows操作系统,具有良好的系统兼容性,同时它能识别各类图片格式,如jpg,jpeg,bmp,gif,png等等,同时还能适用于pdf文件,文件的兼容性强。首先,我们将需要识别的图片准备好,将其采用直接拖曳或是点击“添加文件”将图片添加到软件中。然后,我们就可以开启识别程序,直接点击软件操作界面中的“识别”按钮,软件就开始自动对图片文字进行分析。最后,软件会将分析结果展示出来,与原文校对之后可以保存为word或是其他格式,这个根据需求进行操作。 个人还是比较建议使用捷速图片文字识别软件来进行识别网页文字,出错率较低,不需要多少专业的知识,而且速度快,方便快捷,就能轻松提取网页上不能复制的文字了。 文本特征提取方法https://www.wendangku.net/doc/2d13958142.html,/u2/80678/showart_1931389.html 一、课题背景概述 文本挖掘是一门交叉性学科,涉及数据挖掘、机器学习、模式识别、人工智能、统计学、计算机语言学、计算机网络技术、信息学等多个领域。文本挖掘就是从大量的文档中发现隐含知识和模式的一种方法和工具,它从数据挖掘发展而来,但与传统的数据挖掘又有许多不同。文本挖掘的对象是海量、异构、分布的文档(web);文档内容是人类所使用的自然语言,缺乏计算机可理解的语义。传统数据挖掘所处理的数据是结构化的,而文档(web)都是半结构或无结构的。所以,文本挖掘面临的首要问题是如何在计算机中合理地表示文本,使之既要包含足够的信息以反映文本的特征,又不至于过于复杂使学习算法无法处理。在浩如烟海的网络信息中,80%的信息是以文本的形式存放的,WEB文本挖掘是WEB内容挖掘的一种重要形式。 文本的表示及其特征项的选取是文本挖掘、信息检索的一个基本问题,它把从文本中抽取出的特征词进行量化来表示文本信息。将它们从一个无结构的原始文本转化为结构化的计算机可以识别处理的信息,即对文本进行科学的抽象,建立它的数学模型,用以描述和代替文本。使计算机能够通过对这种模型的计算和操作来实现对文本的识别。由于文本是非结构化的数据,要想从大量的文本中挖掘有用的信息就必须首先将文本转化为可处理的结构化形式。目前人们通常采用向量空间模型来描述文本向量,但是如果直接用分词算法和词频统计方法得到的特征项来表示文本向量中的各个维,那么这个向量的维度将是非常的大。这种未经处理的文本矢量不仅给后续工作带来巨大的计算开销,使整个处理过程的效率非常低下,而且会损害分类、聚类算法的精确性,从而使所得到的结果很难令人满意。因此,必须对文本向量做进一步净化处理,在保证原文含义的基础上,找出对文本特征类别最具代表性的文本特征。为了解决这个问题,最有效的办法就是通过特征选择来降维。 目前有关文本表示的研究主要集中于文本表示模型的选择和特征词选择算法的选取上。用于表示文本的基本单位通常称为文本的特征或特征项。特征项必须具备一定的特性:1)特征项要能够确实标识文本内容;2)特征项具有将目标文本与其他文本相区分的能力;3)特征项的个数不能太多;4)特征项分离要比较容易实现。在中文文本中可以采用字、词或短语作为表示文本的特征项。相比较而言,词比字具有更强的表达能力,而词和短语相比,词的切分难度比短语的切分难度小得多。因此,目前大多数中文文本分类系统都采用词作为特征项,称作特征词。这些特征词作为文档的中间表示形式,用来实现文档与文档、文档与用户目标之间的相似度计算。如果把所有的词都作为特征项,那么特征向量的维数将过于巨大,从而导致计算量太大,在这样的情况下,要完成文本分类几乎是不可能的。特征抽取的主要功能是在不损伤文本核心信息的情况下尽量减少要处理的单词数,以此来降低向量空间维数,从而简化计算,提高文本处理的速度和效率。文本特征选择对文本内容的过滤和分类、聚类处理、自动摘要以及用户兴趣模式发现、知识发现等有关方面的研究都有非常重要的影响。通常根据某个特征评估函数计算各个特征的评分值,然后按评分值对这些特征进行排序,选取若干个评分值最高的作为特征词,这就是特征抽取(Feature Selection)。 网页正文提取我为开源做贡献,网页正文提取——Html2Article 2014-1-7 14:38|发布者: 红黑魂|查看: 16722|评论: 4|原作者: StanZhai|来自: 博客园 摘要: 为什么要做正文提取一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分 ... 为什么要做正文提取 一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分析结果的好坏。 对于特定的网站,我们可以分析其html结构,根据其结构来获取正文信息。先看一下下面这张图: 正文部分,不同的网站,正文所在的位置不同,并且Html的结构也不同,对于 爬虫而言,抓取的页面是各种各样的,不可能针对所有的页面去写抓取规则来提取正文内容,因此需要一种通用的算法将正文提取出来。 现有的网页正文提取算法 ?基于标签用途的正文提取算法(比如title或h1,h2标签一般用作标题,p一 般表示正文段落,根据标签的含义去提取正文) ?基于标签密度判定(这个简单,说白了就是字符统计,正文部分html标签的密度比较低,确定一个阈值,按照标签密度提取正文部分) ?基于数据挖掘思想的网页正文抽取方法(这里会涉及到统计学和概率论的一些知识,在高深点就成了机器学习了,没有深入研究) ?基于视觉网页块分析技术的正文抽取(CV这种高端大气上档次的东西,岂是 我等这么容易就能研究明白的。虽然实现上复杂,但就提取效果而言,这种方法提取的精度还是不错的) 前2中方法还是比较容易实现的,主要是处理简单,先前我把标签密度的提取算法实现了,但实际用起来错误率还是蛮高的;后2种方法在实现上就略复杂了,从算法效率上讲应该也高不了哪去。 我们需要的是一种简单易实现的,既能保证处理速度,提取的准确率也不错的算法。于是结合前两种算法,研究网页html页面结构,有了一种比较好的处理思 路,权且叫做基于文本密度的正文提取算法吧。后来从网上找了一下类似的算法,发现也有使用类似的处理方法来处理正文提取的,不过还是有些不同。接下来跟大家分享一下这个算法的一些处理思想。 网页分析 我任意取了百度,搜狐,网易的一篇新闻类网页,拿来作分析。 先看一篇百度的文章 任正非为什么主动与我合影,https://www.wendangku.net/doc/2d13958142.html,/article/2011 首先请求这个页面,然后过滤到所有的html标签,只保留文本信息,我们可以 看到正文信息集中在一下位置: html文件中提取网页链接C++实现方法// htmltotxt.cpp : 定义控制台应用程序的入口点。// //#include "stdafx.h" #include { int pos1 = src.find("href=\""); if(pos1<0) break; b = pos1; int pos2 = src.find("\"",pos1+6); if (pos2<0) break; string sub = src.substr(pos1+6,pos2-pos1-6); src.erase(src.begin()+pos1,src.begin()+pos2+1); if(sub[0] != 'h'&&sub[1] != 't'&&sub[0] != 't'&&sub[0] != 'p') { continue; } else out< https://www.wendangku.net/doc/2d13958142.html, 网页图片提取方法 对于新媒体运营来说,平日一定要注意积累图片素材,这样到写文案用的时候,才不会临时来照图片,耗费大量的时间。 本文向大家介绍一款网络数据采集工具【八爪鱼数据采集器】,以【图片采集】为例,教大家如何使用八爪鱼采集软件采集网络图片的方法。 1、图片采集 在八爪鱼中,采集图片有以下几大步 1、先采集网页图片的地址链接url 2、通过八爪鱼提供的专用图片批量下载工具将URL转化为图片 八爪鱼图片批量下载工具:https://https://www.wendangku.net/doc/2d13958142.html,/s/1c2n60NI 2、常见应用情景 1)非瀑布流网站纯图片采集 采集示例:豆瓣网图片采集教程https://www.wendangku.net/doc/2d13958142.html,/tutorial/tpcj-7 2)瀑布流网站纯图片采集 这类瀑布流网站的采集需要按下面的步骤对采集规则进行设置: https://www.wendangku.net/doc/2d13958142.html, ①点击采集规则打开网页步骤的高级选项; ②勾选页面加载完成后下滚动; ③填写滚动的次数及每次滚动的间隔; ④滚动方式设置为:直接滚动到底部; 完成上面的规则设置后,再对页面中图片的url进行采集 采集示例:百度网图片采集教程https://www.wendangku.net/doc/2d13958142.html,/tutorial/bdpiccj 3)文章图文采集 需要将文章里的文字和图片都采集下来,一般有两种方法 方法1:判断条件,设置判断条件分别采集文字和图片 采集示例:https://www.wendangku.net/doc/2d13958142.html,/tutorial/txnewscj 方法2:先整体采集文字,再循环采集图片 采集示例:https://www.wendangku.net/doc/2d13958142.html,/tutorial/ucnewscj 3、教程目的 采集图片URL这个步骤,以上图片采集教程中都有详细说明,不再赘述。本文将重点讲解图片采集的采集技巧和注意事项。 4、采集图片URL操作步骤 以下演示一个采集图片URL的具体操作步骤,以百度图片url采集为例。不同的网站图片url会遇到不同的情况,请大家灵活处理。 4.2.2 特征提取方法 图像经过一系列的预处理之后,原来大小不同、分布不规则的各个字符变成了一个个大小相同、排列整齐的字符。下面接要从被分割归一处理完毕的字符中,提取最能体现这个字符特点的特征向量。将提取出训练样本中的特征向量代入BP网络之中就可以对网络进行训练,提取出待识别的样本中的特征向量代入到训练好的BP网络中,就可以对汉字进行识别。 特征向量的提取方法多种多样,可以分为基于结构特征的方法和基于像素分布特征的方法,下面给予简单介绍,并说明本文所用的方法。 (1)结构特征。结构特征充分利用了字符本身的特点,由于车牌字符通常都是较规范的印刷体,因此可以较容易地从字符图像上得到它的字符笔画信息,并可根据这些信息来判别字符。例如,汉字的笔画可以简化为4类:横、竖、左斜和右斜。根据长度不同又可分为长横、短横、长竖和短竖等。将汉字分块,并提取每一块的笔画特征,就可得到一个关于笔画的矩阵,以此作为特征来识别汉字。 (2)像素分布特征。像素分布特征的提取方法很多,常见的有水平、垂直投影的特征,微结构特征和周边特征等。水平、垂直投影的特征是计算字符图像在水平和垂直方向上像素值的多少,以此作为特征。微结构法将图像分为几个小块,统计每个小块的像素分布。周边特征则计算从边界到字符的距离。优点是排除了尺寸、方向变化带来的干扰,缺点是当字符出现笔划融合、断裂、部分缺失时不适用。 ①逐像素特征提取法 这是一种最简单的特征提取方法。它可以对图像进行逐行逐列的扫描,当遇到黑色像素时取其特征值为1,遇到白色像素时取其特征值为0,这样当扫描结束后就获得一个维数与图像中的像素点的个数相同的特征向量矩阵。 这种特征提取方法的特点就是算法简单,运算速度快,可以使BP网络很快的收敛,训练效果好,更重要的是对于数字图像这样特征较少的图像,这种方法提取的信息量最大,所以对于本系统来说,这种方法较为适用。但是它的缺点也很明显,就是适应性不强,所以本文没有选用这种方法。 ②骨架特征提取法 java抓取网页内容三种方式 2011-12-05 11:23 一、GetURL.java import java.io.*; import https://www.wendangku.net/doc/2d13958142.html,.*; public class GetURL { public static void main(String[] args) { InputStream in = null; OutputStream out = null; try { // 检查命令行参数 if ((args.length != 1)&& (args.length != 2)) throw new IllegalArgumentException("Wrong number of args"); URL url = new URL(args[0]); //创建 URL in = url.openStream(); // 打开到这个URL的流 if (args.length == 2) // 创建一个适当的输出流 out = new FileOutputStream(args[1]); else out = System.out; // 复制字节到输出流 byte[] buffer = new byte[4096]; int bytes_read; while((bytes_read = in.read(buffer)) != -1) out.write(buffer, 0, bytes_read); } catch (Exception e) { System.err.println(e); System.err.println("Usage: java GetURL 教你如何复制网上的任何文字 朋友们在上网浏览一些网页时,可能会遇到过有些网页,随着时间的推移该地址也可能失效,无论你按住鼠标左键如何不停的拖动,都无法选中复制需要的文字。那是因为网站为了保密,对网页文件进行了加密,使用户无法通过选取的方法复制网页中的文字,采用“另存为”保存在硬盘中也无法复制其中的文字,是不是让人感觉无可奈何,而又心有不甘呢?下面,我就介绍几种方法来破解网上文字无法复制的问题: 方法1、先按CTRL+A键将网页全部选中,“复制”,然后从中选取需要的文字即可。 方法2、打开你想复制文字的网页,找到地址栏上面的工具栏,找到按钮,点一下右面那个向下的下拉箭头,你可以选择用Word、记事本、Excel编辑,我一般选择用Word,过一会就会出现一个Word文档,在里面找到自己需要复制的文字就可以复制了。 方法3、打开你想复制文字的网页,找到菜单栏中的→另存为(A)→就会出现下图→保存类型→点一下它右面的下拉箭头→选择→再点“保存”就可以了,然后找到该文本文件复制里面你想要的内容就可以了。 方法4、调用源文件查看文字。选择菜单“查看”,点击“源文件”,打开记事本就能看到网页的全部文字,选取你需要的即可。 方法5、点击IE的工具栏栏中的“工具/Internet”菜单,进入“安全”标签页,选择“自定义级别”,将所有脚本全部禁用然后按F5键刷新网页,然后你就会发现那些无法选取的文字就可以选取了。 方法6、下载安装一个SnagIt汉化破解版软件(找个不收费的),利用抓图软件SnagIt实现。SnagIt中有一个“文字捕获”功能,可以抓取屏幕中的文字,也可以用于抓取加密的网页文字。单击窗口中的“文字捕获”按钮,单击“输入”菜单,选择“区域”选项,最后单击“捕获”按钮,这时光标会变成带十字的手形图标,按下鼠标左键在网页中拖动选出你要复制的文本,松开鼠标后会弹出一个文本预览窗口,可以看到网页中的文字已经被复制到窗口中了。剩下的工作就好办了,把预览窗口中的文字复制到其他文本编辑器中即可,当然也可以直接在这个预览窗口中编辑修改后直接保存。 方法7、使用特殊的浏览器。如TouchNet Browser浏览器具有编辑网页功能,可以用它来复制所需文字。在“编辑”菜单中选择“编辑模式”,即可对网页文字进行选取。 注意:以上方法对某些网页并不都适用,朋友们可视情选用一种或几种配合使用,已达到我们复制网页文字的目的。 通用网页正文抽取cx-extractor 基于行块分布函数的通用网页正文抽取:线性时间、不建DOM树、与HTML标签无关对于Web信息检索来说,网页正文抽取是后续处理的关键。虽然使用正则表达式可以准确的抽取某一固定格式的页面,但面对形形色色的HTML,使用规则处理难免捉襟见肘。能不能高效、准确的将一个页面的正文抽取出来,并做到在大规模网页范围内通用,这是一个直接关系上层应用的难题。作者提出了《基于行块分布函数的通用网页正文抽取算法》,首次将网页正文抽取问题转化为求页面的行块分布函数,这种方法不用建立Dom树,不被病态HTML所累(事实上与HTML 标签完全无关)。通过在线性时间内建立的行块分布函数图,直接准确定位网页正文。同时采用了统计与规则相结合的方法来处理通用性问题。作者相信简单的事情总应该用最简单的办法来解决这一亘古不变的道理。整个算法实现代码不足百行。但量不在多,在法。建议使用svn checkout https://www.wendangku.net/doc/2d13958142.html,/svn/trunk/,svn的好处是更新及时,zip包作者不能保证每次修改完后都及时上传:)There are undoubtedly serious bugs lurking somewhere in code this funky. So feel free to contact us if you meet any problem.Bug reports and other feedback are most welcome :-)VersionAuthorEmailInstitutePerl陈鑫xchen@https://www.wendangku.net/doc/2d13958142.html,哈工大信息检索研究中心Java王利锋、罗磊{lfwang,lluo}@https://www.wendangku.net/doc/2d13958142.html,哈工大信息检索研究中心C++朱亮zhuliang@https://www.wendangku.net/doc/2d13958142.html,中科院计算所高级网络重点实验室PHP轩文烽xwf1788@https://www.wendangku.net/doc/2d13958142.html,哈工大智能技术与自然语言处理研究室C#张帆zfannn@https://www.wendangku.net/doc/2d13958142.html, 中科院信息科学与工程学院 小型微型计算机系统JournalofChineseComputerSystems2009年10月第10期V01.30No.102009 肺结节检测中特征提取方法研究 何中市1,梁琰1,黄学全2,王健2 1(重庆大学计算机学院,重庆400044) 2(第三军医大学西南医院放射科,重庆400038) E—mail:zshe@cqu.edu.ca 摘要:计算机辅助诊断(Computer—AidedDiagnosis,CAD)系统为肺癌的早期检测和诊断提供了有力的支持.本文对孤立性肺结节特征提取问题进行研究.通过对肺结节和肺内各组织在序列CT图像上的医学征象分析和研究对比,结合专家提供的知识,提出了肺结节特征提取总体方案.该方案分别从肺部CT图像的灰度特征、肺结节形态、纹理、空间上下文特征等几个方面,对关键的医学征象进行图像分析,从而实现对ROI(RegionsofInterest)区域的特征提取和量化;提出特征提取的评价方案,实验结果表明,本文提取的特征提取方案是有效的.利用本文提取的特征,肺结节检测正确率达到93.05%,敏感率为94.53%. 关键词:孤立性;肺结节;特征提取;CT图像;特征评价 中图分类号:TP391文献标识码:A文章编号:1000—1220(2009)10—2073-05 ResearchontheFeatureExtractionApproachforSPNsDetection 腼Zhong—shil,LIANGYanl,HUANGXue—quan2,WANGJian2 1(CollegeofComputerScience,c‰增幻增Univers毋,Chongqing400044,China) 2(DepartmentofRadiology,Southwest丑却池z,ThirdMilitaryMedwalUniversityofChinesePL4,Chongqing400038,China) Abstract:Imageprocessingtechniqueshaveprovedtobeeffectiveforimprovementofradiologists7diagnosisofpubmonarynodules.Inthispaper,wepresentastrategybasedonfeatureextractiontechniqueaimedatSolitaryPulmonaryNodules(SPN)detection.Infeatureextractionscheme,36featureswereobtained,contained3greylevelfeatures,16morphologicalfeatures,10texturefeaturesand7spatialcontextfeatures.Andtheclassifier(SVM)runningwiththeextractedfeaturesachievescomparativeresults,withare-suitof93.05%innoduledetectionaccuracyand94.53%insensitivity. Keywords:isolated;solitarypulmonarynodules;featureextraction;CTimages;featureassessment 1引言 近几年,随着影像检查技术的改进,临床结果初步证明CT扫描是检测早期无症状肺癌最有效的影像学方法。1J.肺部疾病在CT影像上通常表现为孤立性肺结节(SolitaryPul—monaryNodules,SPNs),因此,对孤立性肺结节的检测和识别是对肺部疾病诊断最重要的途径.计算机辅助诊断系统一方面,大大减轻了医生的工作量,提高了工作效率;另一方面,使影像诊断更加客观化,提高诊断的效率和正确效率.因此,用计算机进行肺结节辅助诊断,提取肺结节特征,检测肺结节,是具有十分重要的意义和研究价值的. 在孤立性肺结节自动识别中,肺结节的特征提取及表示是其关键问题之一,它是进行识别的重要手段.关于肺结节检测方法有很多。2…,但对肺结节医学征象描述并不充分.目前一般常用面积、周长等形态方面进行肺结节特征提取.对肺结节的形态、全局、局部上下文特征以及病理征象的分析不足,使得特征提取描述不到位,影响识别准备率.同时也欠缺对识别结果的解释.正因为对提取的特征与肺结节医学征象问的对应关系分析不足,无法对识别结果进行医学知识上的解释, 特征提取特征评价 懂歪母 I里斗1显查鲎堑卜_倒1J躺l 帽霭瓣||描述程度l 1絮嚣卜 lJs、,M识 --|别性能 图1SPNs诊断框架图 Fig.1OverviewofSPNsdetection 而只有”是”或”否”的识别结果,无法给医生提供更多的信息.本文围绕以上几个问题,意在提供全面的、系统的量化信息,便于医学专家诊断的客观化、效率化.本文对孤立性肺结节特征提取问题进行研究.通过对肺结节和肺内各组织在序列CT图像上的医学征象分析和研究对比,提出了肺结节特征提取总体方案.该方案分别从肺部CT图像的灰度特征、形 收稿日期:2008-08-30基金项目:重庆市重大科技专项项目(CSTC,2008AB5038)资助;重庆市自然科学基金项目(CSTC,2007BB2134))资助.作者简介:何中市,男,1965年生,博士,教授,研究方向为人工智能、机器学习与数据挖掘等;梁琰,女,1982年生,博士研究生,图像处理、模式识别;黄学金,男,1966年生,博士,副教授,研究方向为影像诊断和介入放射学;王健,男,1964年生,博士,教授,研究方向为影像诊断和介入放射学. https://www.wendangku.net/doc/2d13958142.html, 网页数据抓取方法详解 互联网时代,网络上有海量的信息,有时我们需要筛选找到我们需要的信息。很多朋友对于如何简单有效获取数据毫无头绪,今天给大家详解网页数据抓取方法,希望对大家有帮助。 八爪鱼是一款通用的网页数据采集器,可实现全网数据(网页、论坛、移动互联网、QQ空间、电话号码、邮箱、图片等信息)的自动采集。同时八爪鱼提供单机采集和云采集两种采集方式,另外针对不同的用户还有自定义采集和简易采集等主要采集模式可供选择。 https://www.wendangku.net/doc/2d13958142.html, 如果想要自动抓取数据呢,八爪鱼的自动采集就派上用场了。 定时采集是八爪鱼采集器为需要持续更新网站信息的用户提供的精确到分钟的,可以设定采集时间段的功能。在设置好正确的采集规则后,八爪鱼会根据设置的时间在云服务器启动采集任务进行数据的采集。定时采集的功能必须使用云采集的时候,才会进行数据的采集,单机采集是无法进行定时采集的。 定时云采集的设置有两种方法: 方法一:任务字段配置完毕后,点击‘选中全部’→‘采集以下数据’→‘保存并开始采集’,进入到“运行任务”界面,点击‘设置定时云采集’,弹出‘定时云采集’配置页面。 https://www.wendangku.net/doc/2d13958142.html, 第一、如果需要保存定时设置,在‘已保存的配置’输入框内输入名称,再保存配置,保存成功之后,下次如果其他任务需要同样的定时配置时可以选择这个配置。 第二、定时方式的设置有4种,可以根据自己的需求选择启动方式和启动时间。所有设置完成之后,如果需要启动定时云采集选择下方‘保存并启动’定时采集,然后点击确定即可。如果不需要启动只需点击下方‘保存’定时采集设置即可。 在浏览网页时,你一定会不时看到一些需要保存的数据信息。这些信息或许是一个完整的表格,或许是一段文字,如果要保存这类信息,我们常用的方法就是拖动鼠标,选中这些信息,然后用Ctrl+C组合键复制文字,然后再保存到Word、Excel当中去。 这样的步骤算不上麻烦,但如果要求你在一个个内容丰富的大网页(比如新浪、网易、Sohu首页)中频繁地复制、粘贴,一定会让你感到疲劳和浪费时间。有什么好办法呢?用“Ctrl+A”全选后复制所有文字?粘贴后你会发现麻烦更大,因为所有文字都堆在一起了!下面,理睬教你一种方便的方法。 实例:抓取新浪首页不同位置内容 第一步:打开IE,访问理睬博客首页https://www.wendangku.net/doc/2d13958142.html,/ 。 第二步:在网页左侧或右侧的空白处点击鼠标右键,在菜单中选择“导出到Microsoft Office Excel”。注意,不要在文字链接之间的空白处点右键,而是应该在完全没有任何网页内容的地方点右键。 第三步:这时Excel会启动,并出现一个“新建Web查询”的窗口。稍等片刻,等待这个窗口中显示出了完整网页,左下角会出现“完毕”字样。注意观察网页,你会发现网页被分割成了很多小的表格,每个表格的左上角有一个小的箭头标志。 第四步:双击窗口最上方标题栏,最大化窗口。依次找到要收藏的内容,然后按下该位置左上角的箭头,使它变成绿色的对勾。然后按下下方的“导入”按钮。 第五步:在弹出窗口中选择放置位置,然后按下“确定”按钮,文字、表格信息就可以自动导入Excel 了。字体格式、颜色自动处理为Excel默认的样式,表格也会被放到适当的单元格中。这样,就有效避免了直接复制粘贴网页造成一些无法识别的格式、链接信息加入网页,同时提高了导入速度。 你知道吗? 如何不将网页格式带入Office文档中? 当你在浏览器中复制一段内容,然后粘贴到Word、Excel中,会将一些网页格式直接照搬进来,这可能不是我们希望的,因为它会增大文件体积,也不利于加工整理。其实,你只要不用“Ctrl+V”来粘贴,而是选择Word、Excel中的“编辑→选择性粘贴→文本”来进行粘贴就可以了。 电子设计工程 Electronic Design Engineering 第27卷Vol.27第8期No.82019年4月Apr.2019 收稿日期:2018-07-20 稿件编号:201807113 作者简介:洪鸿辉(1992—),男,广东揭阳人,硕士研究生。研究方向:大数据处理。 自互联网问世以来,经过多年的发展,互联网站点的数量在不断的增长,互联网上的信息也在不断的增加,然而,由于商业因素的问题,这些网站在为我们提供有价值的信息的同时,还会包含其他信息,例如广告或其他网站的链接。链接可能是图片,文字。这些相对于正文内容无用的信息会降低我们的阅读效率,而且这些无用的文字可能会被搜索引擎作为索引关键词,不仅降低了搜索的效率还影响了用户的体验。 很多互联网公司也发现了这一问题,所以现在越来越多的网页都会支持RSS 。若一个网页支持RSS , 我们就可以很轻易的提取网页的正文内容,但大多数网页还是不支持RSS ,所以关于正文提取这一方面的研究工作一直没有停止。网页的类型有很多种,比如新闻网站,博客网站,论坛等。新闻类网站的正文提取一直是研究的主要方向,新闻类的文章通常要提取正文内容,标题,时间,作者等。文章通常要提取正文内容,标题,时间,作者等。一方面,网页正文提取结果的好坏会影响着文本聚类,去重,语义指纹等结果。另一方面,网页正文提取在大数据时代也是一项不可或缺的环节。 1相关工作 1.1 VIPS 2003年,微软公司亚洲研究所提出了一种网页 进行视觉分块[1]算法—VIPS [2]算法。该算法的思想是 模仿人类看网页的动作,基于网页视觉内容结构信息结合Dom 树对网页进行处理。简单的说就是把页面切割不同大小的块,在每一块中又根据块网页的内容和CSS 的样式渲染成的视觉特征把其分成小块,最后建立一棵树[3]。 但是,VIPS 必须完全渲染一个页面才能对其进基于文本及符号密度的网页正文提取方法 洪鸿辉,丁世涛,黄傲,郭致远 (武汉邮电科学研究院湖北武汉430000) 摘要:大多数的网站的网页除了主要的内容,还包含导航栏,广告,版权等无关信息。这些额外的内容亦被称为噪声,通常与主题无关。由于这些噪声会妨碍搜索引擎对Web 数据的挖掘性能,所以需要过滤噪声。在本文中,我们提出基于网页文本密度与符号密度对网页进行正文内容提取,这是一种快速,准确通用的网页提取算法,而且还可以保留原始结构。通过与现有的一些算法对比,可以体现该算法的精确度,同时该算法可以较好的支持大数据量网页正文提取操作。关键词:文本密度;算法;噪音;正文提取中图分类号:TP391 文献标识码:A 文章编号:1674-6236(2019)08-0133-05 Text extraction method based on text and symbol density HONG Hong?hui ,DING Shi?tao ,HUANG Ao ,GUO Zhi?yuan (Wuhan Research Institute of Posts and Telecommunications ,Wuhan 430000,China ) Abstract:Most web pages contain not only the main content ,but also navigation bar ,advertising ,copyright and other irrelevant information.These extra contents are also referred to as noise ,usually irrelevant to the topic.Since these noises will hamper the performance of search engine for Web data mining ,noise removal is needed.In this paper ,we propose a fast ,accurate and general web content extraction algorithm based on text density and symbol density ,which can preserve the original https://www.wendangku.net/doc/2d13958142.html,pared with some existing algorithms ,the algorithm can reflect the accuracy of the algorithm ,and the algorithm can better support the large amount of data Web page text extraction operation.Key words:text density ;algorithm ;noise ;text extract - -133 图像特征提取方法 摘要 特征提取是计算机视觉和图像处理中的一个概念。它指的是使用计算机提取图像信息,决定每个图像的点是否属于一个图像特征。特征提取的结果是把图像上的点分为不同的子集,这些子集往往属于孤立的点、连续的曲线或者连续的区域。 至今为止特征没有万能和精确的图像特征定义。特征的精确定义往往由问题或者应用类型决定。特征是一个数字图像中“有趣”的部分,它是许多计算机图像分析算法的起点。因此一个算法是否成功往往由它使用和定义的特征决定。因此特征提取最重要的一个特性是“可重复性”:同一场景的不同图像所提取的特征应该是相同的。 特征提取是图象处理中的一个初级运算,也就是说它是对一个图像进行的第一个运算处理。它检查每个像素来确定该像素是否代表一个特征。假如它是一个更大的算法的一部分,那么这个算法一般只检查图像的特征区域。作为特征提取的一个前提运算,输入图像一般通过高斯模糊核在尺度空间中被平滑。此后通过局部导数运算来计算图像的一个或多个特征。 常用的图像特征有颜色特征、纹理特征、形状特征、空间关系特征。当光差图像时,常 常看到的是连续的纹理与灰度级相似的区域,他们相结合形成物体。但如果物体的尺寸很小 或者对比度不高,通常要采用较高的分辨率观察:如果物体的尺寸很大或对比度很强,只需 要降低分辨率。如果物体尺寸有大有小,或对比有强有弱的情况下同事存在,这时提取图像 的特征对进行图像研究有优势。 常用的特征提取方法有:Fourier变换法、窗口Fourier变换(Gabor)、小波变换法、最 小二乘法、边界方向直方图法、基于Tamura纹理特征的纹理特征提取等。 设计内容 课程设计的内容与要求(包括原始数据、技术参数、条件、设计要求等):一、课程设计的内容 本设计采用边界方向直方图法、基于PCA的图像数据特征提取、基于Tamura纹理特征的纹理特征提取、颜色直方图提取颜色特征等等四种方法设计。 (1)边界方向直方图法 由于单一特征不足以准确地描述图像特征,提出了一种结合颜色特征和边界方向特征的图像检索方法.针对传统颜色直方图中图像对所有像素具有相同重要性的问题进行了改进,提出了像素加权的改进颜色直方图方法;然后采用非分割图像的边界方向直方图方法提取图像的形状特征,该方法相对分割方法具有简单、有效等特点,并对图像的缩放、旋转以及视角具有不变性.为进一步提高图像检索的质量引入相关反馈机制,动态调整两幅图像相似度中颜色特征和方向特征的权值系数,并给出了相应的权值调整算法.实验结果表明,上述方法明显地优于其它方法.小波理论和几个其他课题相关。所有小波变换可以视为时域频域的形式,所以和调和分析相关。所有实际有用的离散小波变换使用包含有限脉冲响应滤波器的滤波器段(filterbank)。构成CWT的小波受海森堡的测不准原理制约,或者说,离散小波基可以在测不准原理的其他形式的上下文中考虑。 通过边缘检测,把图像分为边缘区域和非边缘区域,然后在边缘区域内进行边缘定位.根据局部区域内边缘的直线特性,求得小邻域内直线段的高精度位置;再根据边缘区域内边缘的全局直线特性,用线段的中点来拟合整个直线边缘,得到亚像素精度的图像边缘.在拟合的过程中,根据直线段转角的变化剔除了噪声点,提高了定位精度.并且,根据角度和距离区分出不同直线和它们的交点,给出了图像精确的矢量化结果 图像的边界是指其周围像素灰度有阶跃变化或屋顶变化的那些像素的集合,边界广泛的存在于物体和背 景之间、物体和物体之间,它是图像分割所依赖的重要特征.边界方向直方图具有尺度不变性,能够比较好的 描述图像的大体形状.边界直方图一般是通过边界算子提取边界,得到边界信息后,需要表征这些图像的边 界,对于每一个边界点,根据图像中该点的梯度方向计算出该边界点处法向量的方向角,将空间量化为M级, 计算每个边界点处法向量的方向角落在M级中的频率,这样便得到了边界方向直方图. 图像中像素的梯度向量可以表示为[ ( ,),),( ,),)] ,其中Gx( ,),),G ( ,),)可以用下面的 https://www.wendangku.net/doc/2d13958142.html, 网页内容如何批量提取 网站上有许多优质的内容或者是文章,我们想批量采集下来慢慢研究,但内容太多,分布在不同的网站,这时如何才能高效、快速地把这些有价值的内容收集到一起呢? 本文向大家介绍一款网络数据采集工具【八爪鱼数据采集】,以【新浪博客】为例,教大家如何使用八爪鱼采集软件采集新浪博客文章内容的方法。 采集网站: https://www.wendangku.net/doc/2d13958142.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集” https://www.wendangku.net/doc/2d13958142.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址” https://www.wendangku.net/doc/2d13958142.html, 步骤2:创建翻页循环 https://www.wendangku.net/doc/2d13958142.html, 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。) 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax加载数据”,超时时间设置为5秒,点击“确定”。 https://www.wendangku.net/doc/2d13958142.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。 2)鼠标点击“循环点击每个链接”,列表循环就创建完成,并进入到第一个循环项的详情页面。 相关文档

|