01单符号离散信源及其信息度量

第1讲 单符号离散信源及其信息度量

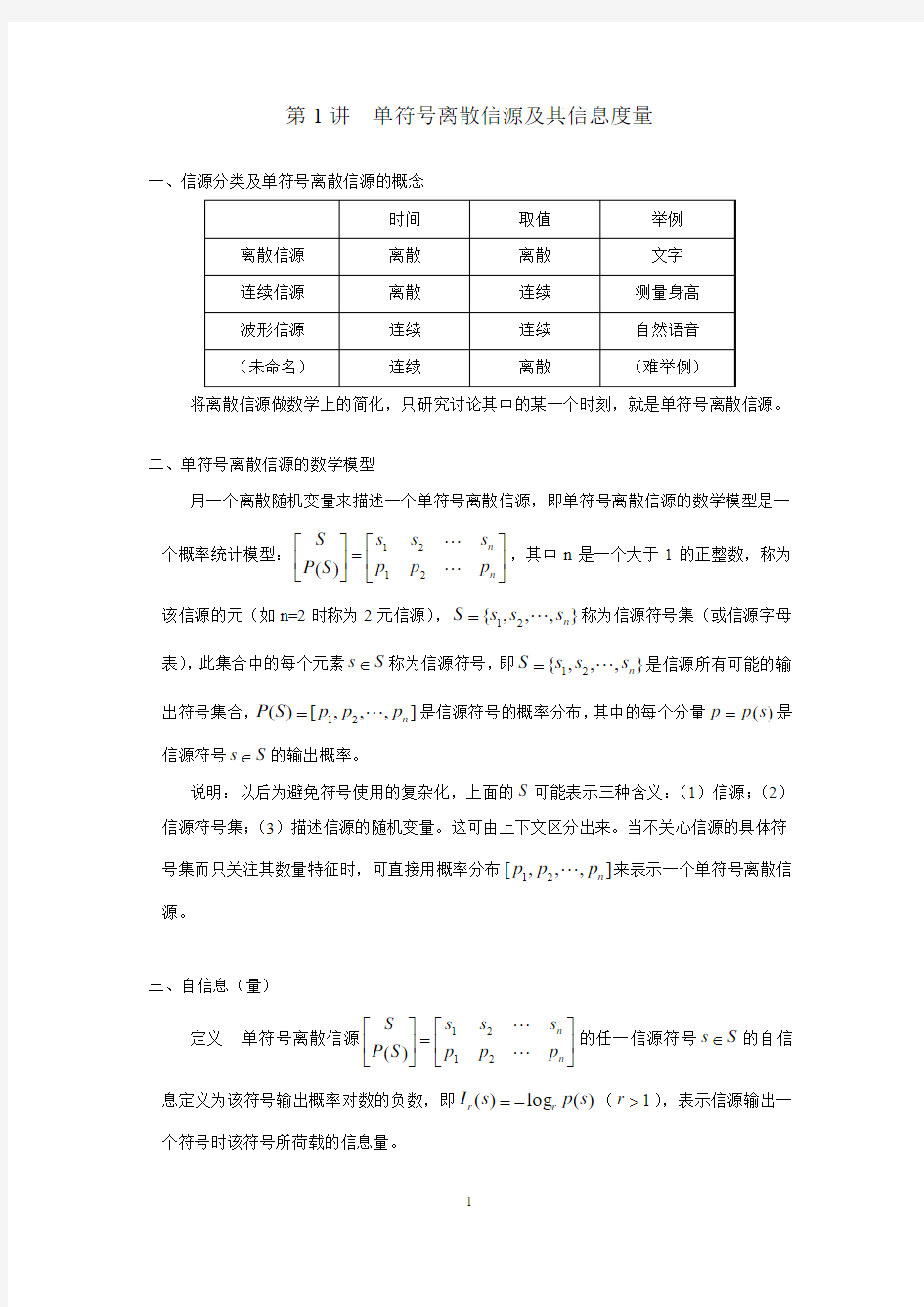

一、信源分类及单符号离散信源的概念

将离散信源做数学上的简化,只研究讨论其中的某一个时刻,就是单符号离散信源。

二、单符号离散信源的数学模型

用一个离散随机变量来描述一个单符号离散信源,即单符号离散信源的数学模型是一

个概率统计模型:??

?

???=??????n n p p p s s s S P S

21

21

)(,其中n 是一个大于1的正整数,称为该信源的元(如n=2时称为2元信源),},,,{21n s s s S =称为信源符号集(或信源字母表),此集合中的每个元素S s ∈称为信源符号,即},,,{21n s s s S =是信源所有可能的输出符号集合,],,,[)(21n p p p S P =是信源符号的概率分布,其中的每个分量)(s p p =是信源符号S s ∈的输出概率。

说明:以后为避免符号使用的复杂化,上面的S 可能表示三种含义:(1)信源;(2)信源符号集;(3)描述信源的随机变量。这可由上下文区分出来。当不关心信源的具体符号集而只关注其数量特征时,可直接用概率分布],,,[21n p p p 来表示一个单符号离散信源。

三、自信息(量)

定义 单符号离散信源??

?

???=??????n n p p p s s s S P S

21

21

)(的任一信源符号S s ∈的自信息定义为该符号输出概率对数的负数,即)(log )(s p s I r r -=(1>r ),表示信源输出一个符号时该符号所荷载的信息量。

1.对数的底

对数的底只要满足1>r 都具有合理意义,常用的是 ,,10,3,2e r =,其中2=r 最为常见,故把它作为信息计量时默认的底,即将)(l o g )(22s p s I -=简写成

)(l o g )(s p s I -=。

2.计量单位

用)(log )(s p s I r r -=进行信息度量时,对数不同的底其数值计算的结果显然会不一样,故计量自信息时必须明确交代对数的底是什么,这等价于采用的计量单位是什么。

2=r 时,计量单位为bit(binary unit)比特;

3=r 时,计量单位为tet(tertiary unit)铁特;

10=r 时,计量单位为det(decimal unit)迪特或hart(Hartlay)哈特;

e r =时,计量单位为nat(natural unit)奈特;

一般情况下计量单位为r-ary unit (r 进制信息单位或r 进制单位)。 3.单位换算

unit

t r unit

t unit

r unit r t r t r r ary -log ary -)(log ary -)(log ary -111=-=-= 如:bits 3.321910log det 1≈=,tets 2.095910log det 13≈=。

4.基本性质

(1)0)(≥s I r (非负性); (2)若1)(=s p 则0)(=s I r , (3)若0)(=s p 则+∞=)(s I r ;

(4))(s I r 随)(s p 严格单调递减(单调性)。 5.例题

某地二月份天气概率分布如下:

??

?

???=??????81

4813412211)()()()()(雪雨阴晴s s s s S P S 当气象台(信源)播出这四种天气之一时,其荷载的信息量(自信息)分别是:

bit s I 1)(1=,bits s I 2)(2=,bits s I 3)(3=,bits s I 3)(4=。

四、单符号离散信源的熵

定义 单符号离散信源??

?

???=??????n n p p p s s s S P S

21

21

)(的熵定义为各符号自信息的平均(即数学期望),即∑=-

=-=n

i i r

i

r r p p p E S H 1

log

]log [)(,用以描述信源的整体特征,

表示每个符号平均所荷载的信息量、或相应随机变量的随机性(不确定性)大小、或以随机变量描述的系统的紊乱程度。

1.几点说明

(1)计量单位为:r 进制信息单位/符号(r-ary unit/char ); (2)当2=r 时,)(2S H 可直接写为)(S H 。

(3))(S H r 由信源的概率分布],,,[21n p p p P =唯一确定,故)(S H r 也可以记为

),,,(21n r p p p H 。

(4)若2=n 即概率分布为]1,[p p P -=时,将)1,(p p H r -简单记为)(p H r ,如

15.0log 5.05.0log 5.0)5.0(=--=H (bit/char),

0.635.0log 5.05.0log 5.0)5.0(333≈--=H (tet/char)。

(5)熵(Entropy)也叫作信源熵、信息熵、香农熵、平均自信息等等。由于熵是概率分布的函数,故熵也被称为熵函数。

(6)为保证熵对所有概率分布均有意义,合理补充定义0log lim 0log 00

==+→εεεr r 。

2.例题

某地二月份天气概率分布如下:

??

?

???=??????81

4813412211)()()()()(雪雨阴晴s s s s S P S 该信源的熵为

)/(75.18

1

log 8181log 8141log 4121log 21)(char bits S H =----=

五、二元熵函数)(p H 的图像

当n=2时,二元熵函数])1,0[()1log()1(log )(∈----=p p p p p p H 实际上是一个一元实函数,画出其图像能帮助理解熵的很多性质,它的图像与二次函数

])1,0[()1(4)(∈-=x x x x f 有点像。

p p p H -=1log

)(',2

ln )1(1

)(''p p p H --=。

六、熵的基本性质

1.对称性

定理1 ),,,(),,,(2121n r n r q q q H p p p H =,其中],,,[21n q q q 是],,,[21n p p p 的任意排列,特别地)1()(p H p H -=。

证明 ],,,[21n p p p 的任意排列对应着∑=-n

i i r

i p p 1

log

中各项的任意排列,由加法

的交换律知熵不会发生变化。

2.非负性

定理2 0),,,(21≥n r p p p H ,当且仅当],,,[21n p p p 是]0,,0,1[ 的某一排列即信源是一个确定性信源时等号成立。

证明 自信息非负即0log )(≥-=i r i r p p I ,所以它们的期望0),,,(21≥n r p p p H 。

当],,,[21n p p p 是]0,,0,1[ 的某一排列时,0)0,,0,1(),,,(21== r n r H p p p H ,反过来,0),,,(21=n r p p p H 时,由自信息的非负性必有∑=-

n

i i r

i p p 1

log

中的每一项

0log =-i r i p p ,从而0=i p 或1=i p ,由121=+++n p p p 得到],,,[21n p p p 只

有一个分量为1,其余全为0,得证。

3.递推性(递增性)

定理3 ),

,(),,,(),,,,,(111111n

m n p q p q

r n n n r m n r H p p p p H q q p p H +=--,其中

01>++=m n q q p 。

证明

),,(),,,(log log log log log log log log log ),,,,,(1

111

1

1

11

1111

1111n m n

n

i n

i

n

i

p q p q r n n n r m

i p q r

p q n n

i i r i m

i p q r

i n

i i r i m

i i

r i m

i n r i n

i i r i m

i i

r i n i i r i m n r H p p p p H p p p q p p q q p q p p q q p p q q p p H +=--=--=-+-=--=-========-=-∑∑∑∑∑∑∑∑∑

4.连续性

定理4 ),,,(21n r p p p H 是概率分布的连续函数,即

),,,(),,,(lim

2122110

||max )

,,2,1(100

21n r n n r n i p p p p H p p p H i i i n =+++→=≤+≤=+++εεεεεεεε

特别地,)(p H 在区间]1,0[上连续。

证明 由∑=-=n

i i r

i n r p p p p p H 1

21log

),,,( 的每一项连续性直接得出。

5.扩展性

定理5

),,,(),,,,(lim

2122110

||max )

,,2,1(10021n r n n r n i p p p p H p p p H i i i n =---→=≤-≤≥=+++εεεεεεεεεε,

特别地),,,()0,,,,(2121n r n r p p p H p p p H =。

证明

)

,,,(log )log )(log )((lim

),,,,(lim

211

10

||max )

,,2,1(10022110

||max )

,,2,1(1002121n r n

i i r i r n

i i i r i i n i p n n r n i p p p p H p p p p p p p H i i i n i i i n =-=----=

---∑∑==→=≤-≤≥=+++→=≤-≤≥=+++εεεεεεεεεεεεεεεεεεεε

6.极值性

定理6 ∑=-

≤n

i i r

i n r q p p p p H 1

21log

),,,( ,其中],,,[21n q q q 也是一概率分布,

当且仅当),,2,1(n i q p i i ==时等号成立。

证明

)

'(log log )

log ()log ()

log (),,,(1

1

1

1

121=≤=---=--∑∑∑∑∑=====inequality s Jensen p q p p q p q p p p q p p p p H n

i i

i i

r n

i i i r

i n

i i r i n

i i r i n

i i r i n r

当且仅当

n

n p q p q p q === 22

11即),,2,1(n i q p i i ==时等号成立。得证。 两点说明:

(1)取定],,,[21n q q q 时∑=-

=n

i i r

i n q p p p p f 1

21log

),,,( 是),,,(21n r p p p H 在

],,,[],,,[2121n n q q q p p p =处的切(超)平面,如下图)(p H 在45.0=p 处的切线刚

好是55.0log )1(45.0log )(p p p f ---=。

(2)记],,,[],,,,[2121n n q q q Q p p p P ==,∑==

n

i i

i

r

i r q p p Q P D 1

log )||(称为相对熵(relative entropy ),用以描述两个分布之间的差异程度,相对熵也被称为Kullback- Leibler 距离,相对熵在信息论中是个重要工具,更有学者主张将其作为信息度量的基础,只是本讲义中避免使用。

7.最大熵原理

定理7 n p p p H r n r log ),,,(21≤ ,当且仅当),,2,1(1n i p i ==即均匀分布时等号成立。

证明 极值性的直接推论,取]

,,,[],,,[1

1121n n n n q q q =,由极值性定理,对于任何概率分布],,,[21n p p p 有n p p p p H r n

i n r

i

n r log )(

log ),,,(1

1

21=-

≤∑= ,当且仅当

),,2,1

(1n i q p n i i ===时等号成立。

8.熵函数的凸性

定理8 ),,,(21n r p p p H 是概率分布的严格上凸函数,即对于任意两个概率分布

],,,[21n p p p P =和],,,[21n q q q Q =,对任意)1,0(∈α时总有

)()1()())1((Q H P H Q P H r r r αααα-+≥-+

当且仅当Q P =时等号成立。

证明 容易验证当)1,0(∈α时Q P )1(αα-+也是一概率分布,进一步

)

()1()(log )1(log ))1((log )1())1((log )

)1((log ))1(()

)1((1

1

1

11Q H P H q q p p q p q q p p q p q p Q P H n

i i

r i n

i i r i n

i i i r i n i i i r i n

i i i r i i r αααααααααααααααα-+=---≥-+---+-=-+-+-=-+∑∑∑∑∑=====

当且仅当),,2,1()1(n i q q p p i i i i ==-+=αα即Q P =时等号成立。得证。 或者用Jensen 不等式直接证明,

)1(log )1()1(log )1(log )1()1(log )

)1((log ))1((log )1(log )

)1(()()1()(1

1

1

1

1

1

1

=-+-+-+≤-+-+-+=-+-++---=-+--+∑∑∑∑∑∑∑=======n

i i

i

i i

r n

i i

i

i i

r n

i i

i

i r

i n

i i

i

i r

i n

i i i r i i n

i i r i n

i i r i r q q p q p q p p q q p q p q p p q p q p q q p p Q P H Q H P H αααααααααααααααααααααα

当且仅当),,2,1()1(n i q q p p i i i i ==-+=αα即Q P =时等号成立。得证。

实验一离散信源及其信息测度

预备知识 一、矩阵处理 1)在MATLAB中矩阵的创建应遵循以下基本常规:矩阵元素应用方括号([])括住;每行内的元素间用逗号(,)或空格隔开;行与行之间用分号(;)或回车键隔开;元素可以是数值或表达式。 2)矩阵赋值 若A=[1 2 3; 4 5 6; 7 8 9;10 11 12] 若A=[1 2 3; 4 5 6; 7 8 9;10 11 12],选出前3行构成矩阵B,B=A(1:3,:)选出前2列构成矩阵C,C=A(:,1:2) 3)矩阵删除 在MATLAB中可以对数组中的单个元素、子矩阵和所有元素进行删除操作,删除就是将其赋值为空矩阵(用[]表示)。 若将A的2,3行去除,则A([2,3],:)=[] 4)矩阵变换 A' %矩阵A的转置 A(:) %矩阵A按列展开形成一维数组 5)矩阵运算 点运算 两个矩阵之间的点运算是按照数组运算规则计算,矩阵的对应元素直接运算。要求参加运算的矩阵大小必须相同。有“.*”、“./”和“.\”三种运算符。 乘法运算 两个矩阵的维数相容时(A的列数等于B的行数),可以进行A乘B的乘法运算。二、M文件 if语句 最简单的选择结构语句,其基本格式为: if 表达式 语句组 end 说明:表达式多为关系或逻辑表达式。如果表达式为真(非零),就执行if和end之间的语句组,然后再执行end之后的语句;如果表达式为假(零),就直接执行end之后的语句。 for语句 for语句为计数循环语句,在许多情况下,循环条件是有规律变化的,通常把循环条件初值、终值和变化步长放在循环语句的开头,这种形式就是for语句的循环结构。for循环的一般形式是: for 循环变量名=表达式1:表达式2:表达式3 语句体 end

信源及信源熵习题答案

第二章: 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少 (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13 =-=-==

(完整版)计算离散信源的熵matlab实现

实验一:计算离散信源的熵 一、实验设备: 1、计算机 2、软件:Matlab 二、实验目的: 1、熟悉离散信源的特点; 2、学习仿真离散信源的方法 3、学习离散信源平均信息量的计算方法 4、熟悉 Matlab 编程; 三、实验内容: 1、写出计算自信息量的Matlab 程序 2、写出计算离散信源平均信息量的Matlab 程序。 3、掌握二元离散信源的最大信息量与概率的关系。 4、将程序在计算机上仿真实现,验证程序的正确性并完成习题。 四、实验报告要求 简要总结离散信源的特点及离散信源平均信息量的计算,写出习题的MATLAB 实现语句。 信息论基础: 自信息的计算公式 21()log a I a p = Matlab 实现:I=log2(1/p) 或I=-log2(p) 熵(平均自信息)的计算公式 22111()log log q q i i i i i i H x p p p p ====-∑∑ Matlab 实现:HX=sum(-x.*log2(x));或者h=h-x(i)*log2(x(i)); 习题: 1. 甲地天气预报构成的信源空间为: 1111(),,,8482 X p x ??????=???????? 小雨 云 大雨晴 乙地信源空间为: 17(),88 Y p y ??????=???????? 小雨晴 求此两个信源的熵。求各种天气的自信息量。 案:() 1.75;()0.5436H X H Y ==

运行程序: p1=[1/2,1/4,1/8,1/8];%p1代表甲信源对应的概率p2=[7/8,1/8];%p2代表乙信源对应的概率 H1=0.0; H2=0.0; I=[]; J=[]; for i=1:4 H1=H1+p1(i)*log2(1/p1(i)); I(i)=log2(1/p1(i)); end disp('自信息量分别为:'); I disp('H1信源熵为:'); H1 for j=1:2 H2=H2+p2(j)*log2(1/p2(j)); J(j)=log2(1/p2(j)); end disp('自信息量分别为:'); J disp('H2信源熵为:'); H2

实验一 离散信源及其信息测度

实验一 离散信源及其信息测度 一、[实验目的] 离散无记忆信源是一种最简单且最重要的信源,可以用完备的离散型概率空间来描述。本实验通过计算给定的信源的熵,加深对信源及其扩展信源的熵的概念的理解。 二、[实验环境] windows XP,MATLAB 三、[实验原理] 信源输出的各消息的自信息量的数学期望为信源的信息熵,表达式如下 1()[()]()log ()q i i i H X E I xi p x p x ===-∑ 信源熵是信源的统计平均不确定性的描述,是概率函数()p x 的函数。 四、[实验内容] 1、有条100字符英文信息,假定其中每字符从26个英文字母和1个空格中等概选取,那么每条信息提供的信息量为多少?若将27个字符分为三类,9个出现概率占2/7,13个出现概率占4/7,5个出现占1/7,而每类中符号出现等概,求该字符信源的信息熵。 2、二进制通信系统使用0、1,由于存在失真,传输会产生误码,用符号表示下列事件:u0:一个0发出;u1:一个1发出;v0:一个0收到;v1:一个1收到;给定下列概率:p(u0)=1/2,p(v0|u0)=3/4,p(v0|u1)=1/2。求:(a)已知发出一个0,求收到符号后得到的信息量;(b)已知发出的符号,求收到符号后得到的信息量; 3、给定离散无记忆信源X ,其概率空间为 010.70.3X P ????=???????? 求该信源的熵和其二次、三次扩展信源的熵。(编写一M 函数文件: function [H_X1,H_X2,H_X3]=t03(X1,P1) %t03 求信源和其二次、三次扩展信源的熵 %输入为X1,P1,分别为信源符号和概率阵 %输出为原离散信源的熵H_X1和二次、三次扩展信源的熵H_X2、H_X3

信息论与编码第二章 信源熵习题的答案[最新]

2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11= 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15 .075.025.0log )()/()(log )/(log )/(11111111=?-=-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: ! 521)(=i x p bit x p x I i i 581.225!52log )(log )(==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:

离散信源题与答案

? ?? ???=====??????8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。 求: (1) 此消息的自信息量是多少 (2) 此消息中平均每符号携带的信息量是多少 解: (1) 此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是: 6 2514814183?? ? ?????? ?????? ??=p 此消息的信息量是:bit p I 811.87log =-= (2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/== 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为 ???? ??=??????4/34/110 )(X P X (1) 求信息符号的平均熵; (2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。 解: (1) bit x p x p X H i i i 811.043log 4341log 41 )(log )()(=??? ??+-=-=∑ (2) bit m x p x I x p m i i m m m i 585.15.414 3 log )(log )(4 34341)(100 100100 100100+=-=-==? ? ? ?????? ??=--- (3) bit X H X H 1.81811.0100)(100)(100=?== 某信源的消息符号集的概率分布和二进制代码如题表所列。 题表

2015秋.信息论.第2章离散信源与信息熵

第2章离散信源与信息熵 信号 信号+干扰 消息 干扰 消息 信源 编码器 信道 译码器 信宿 噪声源 通信系统模型 信息

2.1 信源的分类和描述 信源是信息的发源地,可以是人、生物、机器或其他事物。信源的输出是包含信息的消息。消息的形式可以是离散的或连续的。 信源输出为连续信号形式(如语音),可用连续随机变量描述。 连续信源←→模拟通信系统 信源输出是离散的消息符号(如书信),可用离散随机变量描述。 离散信源←→数字通信系统

离散信源…X i…X j… 离散无记忆信源:输出符号X i X j 之间相互无影响; 离散有记忆信源:输出符号X i X j 之间彼此依存。 3 离散信源 无记忆 有记忆发出单个符号发出符号序列马尔可夫信源 非马尔可夫信源

y j 将一粒棋子随意地放 在棋盘中的某列; 棋子放置的位置是一 个随机事件; 可看做一个发出单个 符号的离散信源。 x i

1212,,...,(),(),...,()m m x x x X P p x p x p x ????=???????? 就数学意义来讲,信源就是一个概率场,可用概率空间来描述信源。由离散随机变量X 表示棋子位置: 10()1,()1m i i i p x p x =≤≤=∑i x 其中,代表随机事件的某一结果。

2.2离散信源的信息熵信息的可度量性是信息论建立的基础; 香农的信息论用事件发生概率的对数来描述事件的不确定性,得到消息的信息量,建立熵的概念。 2.2.1自信息量 –定义2.1 任意随机事件x i 的自信息量定义为: i i i 1(x )log log (x )(x ) I P P ==-

关于信源熵的实验报告讲解

实验报告 实验名称关于信源熵的实验课程名称信息论与编码 姓名xxx 成绩90 班级电子信息 1102学号0909112204 日期2013.11.22地点综合实验楼

实验一关于信源熵的实验 一、实验目的 1. 掌握离散信源熵的原理和计算方法。 2. 熟悉matlab 软件的基本操作,练习使用matlab 求解信源的信息熵。 3. 自学图像熵的相关概念,并应用所学知识,使用matlab 或其他开发工具 求解图像熵。 4. 掌握Excel的绘图功能,使用Excel绘制散点图、直方图。 二、实验原理 1. 离散信源相关的基本概念、原理和计算公式 产生离散信息的信源称为离散信源。离散信源只能产生有限种符号。随机事件的自信息量I(xi)为其对应的随机变量xi 出现概率对数的负值。 即: I (xi )= -log2p ( xi) 随机事件X 的平均不确定度(信源熵)H(X)为离散随机变量 xi 出现概 率的数学期望,即:

2.二元信源的信息熵 设信源符号集X={0,1} ,每个符号发生的概率分别为p(0)= p,p(1)= q, p+ q =1,即信源的概率空间为: 则该二元信源的信源熵为: H( X) = - plogp–qlogq = - plogp –(1 - p)log(1- p) 即:H (p) = - plogp –(1 - p)log(1- p) 其中 0 ≤ p ≤1 3. MATLAB二维绘图 用matlab 中的命令plot( x , y) 就可以自动绘制出二维图来。 例1-2,在matlab 上绘制余弦曲线图,y = cos x ,其中 0 ≤ x ≤2 >>x =0:0.1:2*pi; %生成横坐标向量,使其为 0,0.1,0.2,…, 6.2 >>y =cos(x ); %计算余弦向量 >>plot(x ,y ) %绘制图形 4. MATLAB求解离散信源熵 求解信息熵过程: 1) 输入一个离散信源,并检查该信源是否是完备集。

通信原理第三章-离散信源及信息测度

第三章 离散信源及其信息测度 3.1 信源的数学模型及分类 信源是信息的来源,是产生消息或消息序列的源泉。信息是抽象的,而消息是具体的。消息不是信息本身,但它包含着和携带着信息。我们不研究信源的内部结构,不研究信源为什么产生和怎样产生各种不同的、可能的消息,而只研究信源的各种可能的输出,以及各种可能消息的不确定性。 在通信系统中收信者在未收到消息以前,对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机矢量或随机过程来描述信源输出的消息。不同的信源输出的消息不同,可以根据消息的不同的随机性质来对信源进行分类。 1)信源输出的单符号消息可用随机变量描述 在实际情况中,有些信源可能输出的消息数是有限的或可数的,而且每次只输出其中一个消息,如书信文字、计算机的代码、电报符号、阿拉伯数字码等。这些信源输出的都是单个符号的消息,它们符号集的取值是有限的或可数的。我们可用一维离散型随机变量X 来描述这些信源的输出。这样的信源称为离散信源。它的数学模型就是离散型的概率空间 121 2(), ,(),(),()q q X P x a a a P a P a P a =???????????? (3-1) 显然,()(1,2,,)i P a i q =应满足 1()1q i i P a ==∑ (3-2) 式中,{}i a 是离散信源可能的输出符号;()1(1,2,,)0i P a i q ≤=≤是信源输出符号 (1,2,,)i a i q =的先验概率。 有的信源虽然输出的是单个符号(代码)的消息,但其可能出现的消息数是不可数的无限值,即输出消息的取值是连续的,或取值是实数集(,)-∞∞。例如,语音信号、热噪声信号某时间的连续取值数据,遥控系统中有关电压、温度、压力等测得的连续数据。这些数据取值是连续的,但又是随机的。我们可用一维的连续型随机变量X 来描述这些消息,则这种信源称为连续信源,其数学模型是连续型概率空间 ()(x)X P x p =?????????? ??R (3-3) 并满足 ()d 1b a p x x =? 或()d 1p x x =?R 式中,R 表示实数集(,)-∞∞;()p x 是随机变量X 的概率密度函数。 上述离散信源和连续信源是最简单、最基本的情况,信源只输出一个消息(符号),所

实验一、离散信源的熵与离散信道的容量

信息论与编码实验报告 信息学院10电子A班级第组姓名同组成员实验名称实验一、离散信源的熵与离散信道的容量 实验设备(1)计算机(2)所用软件:Matlab或C 实验目的掌握信源的熵、信道容量的物理意义,概念;熟练掌握离散信源熵、离散信道容量的计算方法步骤;利用Matlab编写离散信源熵、离散信道容量的计算程序;验证程序的正确性。 实验内容(1)根据熵,信道容量计算的方法步骤,用Matlab编写离散信源熵、离散信道容量的计算程序; (2)用习题2.16和例3.6验证程序的正确性。 实验报告要求 1、简要总结信源的熵、信道容量的物理意义,概念; 2、写出离散信源熵、离散信道容量计算的基本步骤,画出实现离散信源熵、离散信道容量 计算的程序流程图; 3、实现离散信源熵、离散信道容量计算的Matlab源程序; 4、讨论信源的熵的大小与前后符号之间相关性的关系,讨论信道容量与信源先验概率及信 道转移概率的关系。 5、实验报告在实验后一周内交给老师,报告单一律用16开大小的纸写,以此单为封面,装 订成册。 完成时间:2012年12月22日

1、简要总结信源的熵、信道容量的物理意义,概念。 信源熵的物理意义是指信源中的各个符号的平均不确定性;熵是信源符号的平均信息量,是信源符号的平均不确定度。 信道容量概念:在信道可以传输的基本前提下,对信源的一切可能的概率分布而言,信道能够传输的最大(接收)熵速率称为信道容量。 意义:求出了某个信道的信道容量,也就找到了信源的最佳概率分布。从而指导人们改造信源,使之最大可能地利用信道的传输能力。 2、写出离散信源熵、离散信道容量计算的基本步骤,画出实现离散信源熵、离散信道容量计算的程序流程图; 离散信源熵的计算步骤: ()()() 11log log ()q r r r i i i i H X E p a a p a =??==- ???∑信道容量的计算步骤:()(){}()符号/;max bit Y X I C X P =3、实现离散信源熵、离散信道容量计算的Matlab 源程序; 实验程序: 1)计算信源熵: 新建M 文件: function[h]=H(x) h=-log2(x)*x'; 保存为H.m

第二章信源信息熵

第二章信源与信息熵 主要内容:(1)信源的描述与分类;(2)离散信源熵和互信息;(3)离散序列信源的熵;(4)连续信源的熵和互信息;(5)冗余度。 重点:离散/连续信源熵和互信息。 难点:离散序列有记忆信源熵。 说明:本章内容主要针对信源,但是很多基本概念却是整个信息论的基础,所以安排了较多课时。由于求熵涉及一些概率论的基础知识,考虑到大四的同学可能对这部分知识已经遗忘,故适当复习部分概率论知识。较难的 2.1.2节马尔可夫信源部分放置在本章最后讲,便于同学理解。本章概念和定理较多,比较抽象,课堂教学时考虑多讲述一些例题,通过例题来巩固概念和消化定理。 作业: 2.1—2.7,2.10,2.12。 课时分配:10课时。 板书及讲解要点: 在信息论中,信源是发出消息的源,信源输出以符号形式出现的具体消息。如果符号是确定的而且预先是知道的,那么该消息就无信息而言。只有当符号的出现是随机的,预先无法确定,一旦出现某个符合就给观察者提供了信息。因此应该用随机变量或随机矢量来表示信源,运用概率论和随机过程的理论来研究信息,这就是香农信息论的基本点。 2.1 信源的描述与分类 在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。 信源:产生随机变量、随机序列和随机过程的源。 信源的基本特性:具有随机不确定性。 信源的分类 离散信源:文字、数据、电报——随机序列 连续信源:话音、图像——随机过程 离散信源:输出在时间和幅度上都是离散分布的消息。

消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。 发出单个符号的无记忆信源 离散无记忆信源: 发出符号序列的无记忆信源 离散信源 离散有记忆信源: 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源 概率论基础: 无条件概率,条件概率和联合概率的性质和关系: (1) 非负性 0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, (2) 完备性 111 1 11 ()1,()1,(/)1, (/)1,()1 n m n i j i j i j i m m n j i i j j j i p x p y p x y p y x p x y ===========∑∑∑∑∑∑ 1 1 ()(),()()n m i j j i j i i j p x y p y p x y p x ====∑∑ (3) 联合概率 ()()(/)()(/)()()()(/)()(/)() i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,, (4) 贝叶斯公式 1 1 () () (/)(/)() () i j i j i j j i n m i j i j i j p x y p x y p x y p y x p x y p x y === = ∑∑, 2.1.1 无记忆信源: 例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。可以用一个离散型随机变量X 来描述这个信源输出的消息。

信源及信源熵习题答案

· 1 · 第二章: 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13=-=-==

实验一:绘制信源熵函数曲线

信息与通信工程学院实验报告 (软件仿真性实验) 课程名称:信息论基础 实验题目:绘制信源熵函数曲线指导教师:毛煜茹 班级:15050541学号:19 学生姓名:王宇 一、实验目的和任务 掌握离散信源熵的原理和计算方法。 熟悉matlab软件的基本操作,练习应用matlab软件进行信源熵函数曲线的绘制。 理解信源熵的物理意义,并能从信源熵函数曲线图上进行解释其物理意义。 二、实验内容及原理 2.1实验内容: 用matlab软件绘制二源信源熵函数曲线。根据曲线说明信源熵的物理意义。 2.2实验原理: (1)离散信源相关的基本概念、原理和计算公式 产生离散信息的信源称为离散信源。离散信源只能产生有限种符号。 假定X是一个离散随机变量,即它的取值范围R={x1,x2,x3,…}是有限或可数的。设第i个变量x i 发生的概率为p i=P{X=x i}。则: 定义一个随机事件的自信息量I(x i)为其对应的随机变量x i出现概率对数的负值。即: I(x i )= -log 2 p(x i ) 定义随机事件X的平均不确定度H(X)为离散随机变量x i出现概率的数学期望,即:

∑∑-==i i i i i i x p x p x I x p X H )(log )()()()( 单位为 比特/符号 或 比特/符号序列。 平均不确定度H (X )的定义公式与热力学中熵的表示形式相同,所以又把平均不确定度H (X )称为信源X 的信源熵。 必须注意以下几点: 某一信源,不管它是否输出符号,只有这些符号具有某些概率特性,必有信源的熵 值;这熵值是在总体平均上才有意义,因而是个确定值,一般写成H (X ),X 是指随机变量的整体(包括概率分布)。 信息量则只有当信源输出符号而被接收者收到后,才有意义,这就是给与信息者的 信息度量,这值本身也可以是随机量,也可以与接收者的情况有关。 熵是在平均意义上来表征信源的总体特征的,信源熵是表征信源的平均不确定度, 平均自信息量是消除信源不确定度时所需要的信息的量度,即收到一个信源符号,全部解除了这个符号的不确定度。或者说获得这么大的信息量后,信源不确定度就被消除了。信源熵和平均自信息量两者在数值上相等,但含义不同。 当某一符号x i 的概率p (x i )为零时,p (x i )log p (x i ) 在熵公式中无意义,为此规定这 时的 p (x i )log p (x i ) 也为零。当信源X 中只含有一个符号x 时,必有p (x )=1,此时信源熵H (X )为零。 例1-1,设信源符号集X ={0,1},每个符号发生的概率分别为p (0)=p ,p (1)=q ,p+ q =1,即信源的概率空间为 ?? ????=?????? 1 0q p P X 则该二元信源的信源熵为: H (X ) = - p log p – q log q = - p log p – (1- p )log (1- p) 即:H (p) = - p log p – (1- p )log (1- p) 其中0 ≤ p ≤1

实验一 离散信源及其信息测度

信息论与编码 实验报告 实验一离散信源及其信息测度 专业 班级 学号 姓名 成绩

实验一 离散信源及其信息测度 一、[实验目的] 离散无记忆信源是一种最简单且最重要的信源,可以用完备的离散型概率空间来描述。本实验通过计算给定的信源的熵,加深对信源及其扩展信源的熵的概念的理解。 二、[实验环境] windows XP,MATLAB 三、[实验原理] 信源输出的各消息的自信息量的数学期望为信源的信息熵,表达式如下 1()[()]()log ()q i i i H X E I xi p x p x ===-∑ 信源熵是信源的统计平均不确定性的描述,是概率函数()p x 的函数。 四、[实验内容] 1、有条100字符英文信息,假定其中每字符从26个英文字母和1个空格中等概选取,那么每条信息提供的信息量为多少?若将27个字符分为三类,9个出现概率占2/7,13个出现概率占4/7,5个出现占1/7,而每类中符号出现等概,求该字符信源的信息熵。 2、二进制通信系统使用0、1,由于存在失真,传输会产生误码,用符号表示下列事件:u0:一个0发出;u1:一个1发出;v0:一个0收到;v1:一个1收到;给定下列概率:p(u0)=1/2,p(v0|u0)=3/4,p(v0|u1)=1/2。求: (a)已知发出一个0,求收到符号后得到的信息量; (b)已知发出的符号,求收到符号后得到的信息量; 五、[实验过程] 每个实验项目包括:1)设计思路2)实验中出现的问题及解决方法; 1)设计思路

1、每字符从26 个英文字母和1 个空格中等概选取,一共100 个字符,那么可以组成27^100 条消息,每条消息出现的概率是1/(27^100),由自信息量公式可得每条消息的自信息量。 程序代码: clear all,clc; H1=log2(27^100) 程序结果: H1 =475.4888 2、求出各种条件概率,将其代入信息量公式计算信息量。 程序代码: p_u0=1/2; p_v0_u0=3/4; p_v0_u1=1/2; p_v1_u0=1-p_v0_u0; H_V_u0=p_v0_u0*log2(p_v0_u0)-p_v1_u0*log2(p_v1_u0) p_u1=1-p_u0; p_v1_u1=1-p_v0_u1; p_u0v0=p_v0_u0*p_u0; p_u0v1=p_v1_u0*p_u0; p_u1v0=p_v0_u1*p_u1; p_u1v1=p_v1_u1*p_u1; H_V_U=-p_u0v0*log2(p_v0_u0)-p_u0v1*log2(p_v1_u0)-p_u1v0*log2(p_v0_u1) -p_u1v1*log2(p_v1_u1) 程序结果: H_V_u0 =0.1887 H_V_U =0.9056 2)实验中出现的问题及解决方法; 实验中遇到的问题有很多,如各种概率空间的计算,弄混,概念不清楚,公式不熟悉,对信息论的定理概念及意义不理解,不能灵活运用。对于各种概率的计算,需要准确分析,然后逐一进行计算。信息论的定理概念及意义,翻书查阅,尽可能的熟悉,理解,并加以运用。 六、[实验总结] 通过实验,回顾了各种概率的求解方法,该实验主要是计算消息的信息量,信息熵。在实验过程中,不断地学习查阅课本,巩固了上课的知识,对所学的定理和公式有了更加深刻的认识和理解。

离散信源熵信道容量实验报告

计算离散信源熵、离散信道容量

1 实验任务和目的 实验任务: (1)简要总结信源的熵、信道容量的物理意义,概念; (2)写出离散信源熵、离散信道容量计算的基本步骤,画出实现离散信源熵、离散信道容量计算的程序流程图; (3)讨论信源的熵的大小与前后符号之间相关性的关系,讨论信道容量与信源先验概率及信道转移概率的关系。 实验目的: 掌握信源的熵、信道容量的物理意义,概念;熟练掌握离散信源熵、离散信道容量的计算方法步骤;利用Matlab 编写离散信源熵、离散信道容量的计算程序;验证程序的正确性。 2 实验过程和结果 2.1 实验过程 1、简要总结信源的熵、信道容量的物理意义,概念。 信源熵的物理意义是指信源中的各个符号的平均不确定性;熵是信源符号的平均信息量,是信源符号的平均不确定度。 信道容量 概念:在信道可以传输的基本前提下,对信源的一切可能的概率分布而言,信道能够传输的最大(接收)熵速率称为信道容量。 意义:求出了某个信道的信道容量,也就找到了信源的最佳概率分布。从而指导人们改造信源,使之最大可能地利用信道的传输能力。 2、写出离散信源熵、离散信道容量计算的基本步骤,画出实现离散信源熵、离散信道容量计算的程序流程图; 离散信源熵的计算步骤: ()()()11log log ()q r r r i i i i H X E p a a p a =?? ==- ??? ∑ 信道容量的计算步骤:() (){}()符号/;m ax bit Y X I C X P =

3、(1)讨论信源的熵的大小与前后符号之间相关性的关系,讨论信道容量与信源先验概率及信道转移概率的关系。 信源的相关性是信源符号间的依赖程度的度量。由于信源输出符号间的依赖关系也就是信源的相关性使信源的实际熵减小。信源输出符号间统计约束关系越长,信源的实际熵越小。当信源输出符号间彼此不存在依赖关系且为等概率分布时,信源的实际熵等于最大熵。 (2)信道容量与信源先验概率及信道转移概率的关系。 信道容量是信道的一个参数,反映了信道所能传输的最大信息量,其大小与信源无关。对不同的输入概率分布,互信息一定存在最大值。我们将这个最大值定义为信道的容量。一但转移概率矩阵确定以后,信道容量也完全确定了。尽管信道容量的定义涉及到输入概率分布,但信道容量的数值与输入概率分布无关。我们将不同的输入概率分布称为试验信源,对不同的试验信源,互信息也不同。其中必有一个试验信源使互信息达到最大。这个最大值就是信道容量。 实验结果 计算离散信源熵:

第二章 信源熵改习题答案

· 1 · 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11= 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15 .075 .025.0log )()/()(log )/(log )/(11111111=?-=-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: ! 521)(= i x p bit x p x I i i 581.225!52log )(log )(==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:

信源及信源熵习题问题详解

第二章: 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 2.3 一副充分洗乱了的牌(含52牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52牌共有4种花色、13种点数,抽取13点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13 =-=-==

- 通信原理第三章-离散信源及信息测度

- 【VIP专享】第二章离散信源

- (信息论)第3章离散信源

- 离散信源的信息熵

- 高等教育《信息论》第3章离散信源

- 3离散信源及其数学模型

- 第2讲——离散信源的数学模型及其信息测度(1)讲解

- 第2章 离散信源及其测度(ok)讲解

- 实验一 离散信源及其信息测度

- 第二章信源及其信息量

- 离散信源熵和互信息(上)

- 第二章 离散信源及其信息测度_02

- 实验一离散信源及其信息测度

- 2015秋.信息论.第2章离散信源与信息熵

- 实验一 离散信源及其信息测度

- 信息理论基础 第三章 离散信源

- 第2章_离散信源及信息测度3

- 第2讲——离散信源的数学模型及其信息测度(1)

- 离散信源的信息熵

- 信息论与编码信源及信源熵